最近公開されたオープンソースAIモデルReflection70Bは、業界から広く疑問視されています。

ニューヨークのスタートアップ企業HyperWriteが発表したこのモデルは、Meta社のLlama3.1の派生版と自称しており、第三者機関によるテストで優れた性能を示したことから注目を集めていました。しかし、いくつかのテスト結果が発表されると、Reflection70Bの評判は揺らぎ始めました。

発端は、HyperWriteの共同創設者兼CEOであるMatt Shumer氏が9月6日、ソーシャルメディアX上でReflection70Bを発表し、「世界最強のオープンソースモデル」と自信満々に宣言したことでした。

Shumer氏は、このモデルの「反射チューニング」技術についても説明し、この方法によりモデルがコンテンツ生成前に自己検証を行い、正確性を向上させると主張しました。

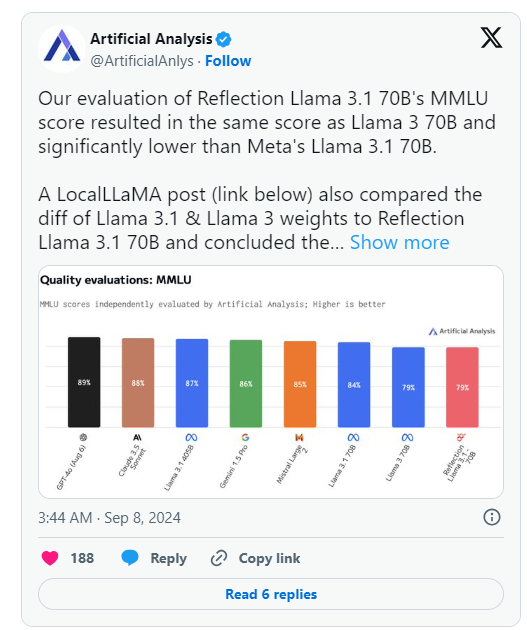

しかし、HyperWriteの発表から翌日、「AIモデルとホスティングプロバイダーの独立分析」を行う組織Artificial AnalysisがX上で独自の分析を発表し、彼らが評価したReflection Llama3.1 70BのMMLU(Massive Multitask Language Understanding)スコアはLlama3 70Bと同じであり、MetaのLlama3.1 70Bを明らかに下回っていることを指摘しました。これは、HyperWrite/Shumerが最初に発表した結果と大きく食い違っています。

その後、Shumer氏は、Reflection70Bのウェイト(またはオープンソースモデルの設定)がHugging Face(第三者AIコードホスティングリポジトリおよび企業)へのアップロード中に問題が発生したため、HyperWriteの「内部API」バージョンよりも性能が劣っていた可能性があると述べました。

Artificial Analysisはその後、プライベートAPIへのアクセス権を取得し、印象的なパフォーマンスを確認したものの、当初の声明レベルには達していないと発表しました。このテストはプライベートAPI上で行われたため、テスト対象の内容を独立して検証することはできませんでした。

この組織は、HyperWriteとShumerの最初の性能に関する声明を強く疑問視する2つの重要な問題を提起しました。

- なぜ公開されたバージョンが、ReflectionプライベートAPIでテストされたバージョンではないのか。

- なぜテストされたバージョンのモデルウェイトがまだ公開されていないのか。

同時に、Reddit上の複数の機械学習とAIコミュニティのユーザーも、Reflection70Bの主張する性能と起源に疑問を呈しました。一部の人々は、Github上で公開されているモデルの比較によると、Reflection70BはLlama-3.1の派生版ではなく、Llama3の派生版であるように見えると指摘し、ShumerとHyperWriteの最初の声明に対する疑いをさらに深めました。

これにより、少なくともXユーザーのShin Megami Boson氏が9月8日午後8時7分、

にShumer氏をAI研究コミュニティにおける「詐欺行為」で公然と告発し、一連のスクリーンショットやその他の証拠を公開しました。

その他の人々は、このモデルが実際には、専有/クローズドソースの競合他社であるAnthropicのClaude3の上に構築された「ラッパー」またはアプリケーションであると主張しています。

しかし、Shumer氏とReflection70Bを擁護する他のXユーザーもおり、彼らが体験したモデルの印象的な性能についても発表しています。

現在、AI研究コミュニティは、Shumer氏によるこれらの詐欺疑惑への対応と、Hugging Face上での更新されたモデルウェイトを待っています。

🚀 Reflection70Bモデル公開後、性能に疑問が呈され、テスト結果が初期の性能主張を再現できませんでした。

⚙️ HyperWriteの創設者は、モデルのアップロードの問題により性能が低下したと説明し、更新版への注目を呼びかけています。

👥 ソーシャルメディアではこのモデルに関する議論が活発に行われており、非難と擁護が入り混じり、状況は複雑です。