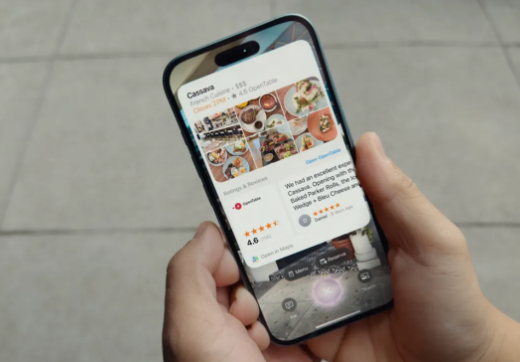

先日開催されたiPhone16発表会で、アップル社は新型iPhone、AirPods、Apple Watch Series10を発表しただけでなく、AI駆動のビジュアルインテリジェンス機能を初めて搭載しました。この新機能により、iPhoneのカメラはGoogle Lensのような機能を備え、よりスマートな撮影体験が可能になります。

アップルのビジュアルインテリジェンス機能を使えば、写真撮影を通して身の回りの物体を認識できます。例えば、看板やレストランのメニューなどを撮影し、iPhoneのAI技術を使って関連情報を検索できます。カメラを開いて認識したい物を撮影するだけで、iPhoneが瞬時に情報を処理して表示します。

さらに、アップルはデータプライバシーを特に強調しました。ユーザーの撮影データはアップルのプライベートクラウドに保存され、安全性が確保されます。ただし、ユーザーが希望する場合、サードパーティサービスとの連携を選択することも可能です。例えば、撮影した内容をGoogle Lensのようにカメラアプリ内で直接検索するといった連携も可能です。

さらに興味深いことに、アップルはChatGPTとの連携も導入しました。ユーザーは、カメラで撮影した画像データをChatGPTで処理し、より詳細な情報や提案を得ることができます。これらの機能は、ユーザーが自分のニーズに合わせて権限を有効にするかどうかを選択できます。

特筆すべき点として、iPhone16とiPhone16 Plusは既に予約受付を開始しており、価格はそれぞれ799ドルと899ドルですが、ビジュアルインテリジェンス機能はすぐに利用できるわけではありません。アップルは、これらのAI機能は来月から段階的にテスト版の提供を開始し、今後数ヶ月でさらに多くの機能を追加していくと発表しました。

重要なポイント:

🌟 アップルが発表したビジュアルインテリジェンス機能により、iPhoneカメラでGoogle Lensのように画像検索が可能になります。

🔒 ユーザーデータはアップルのプライベートクラウドに保存され、プライバシーと安全性が保護されます。

🤖 今後はChatGPTなどのサードパーティアプリとの連携が可能になり、より多くの情報を得ることができます。