研究チームは、画像を入力するだけで画像の撮影場所を特定できる革新的な視覚位置認識技術「Revisit Anything」を発表しました。

画像出典:AI生成画像、画像ライセンス提供元Midjourney

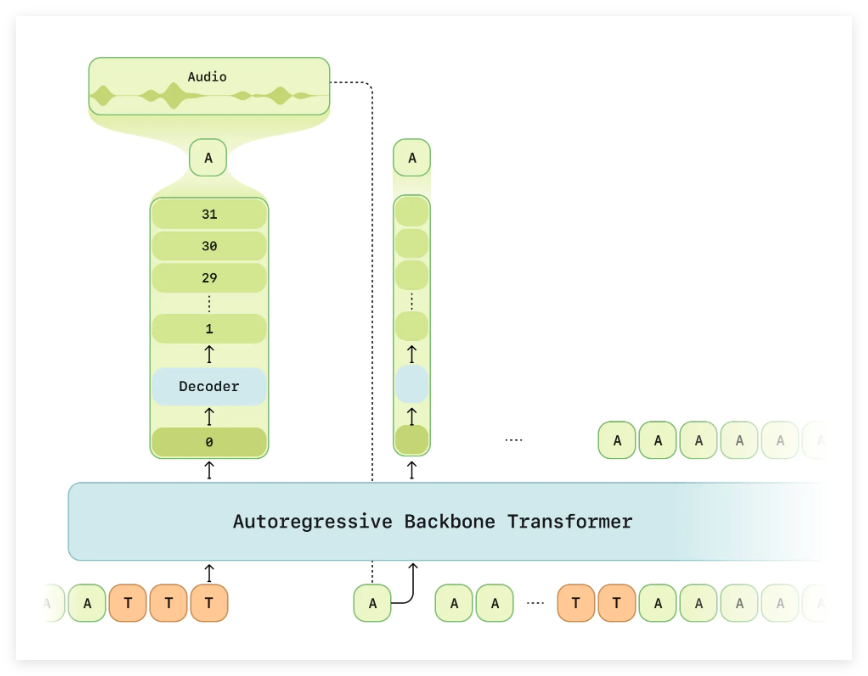

この技術は、最新のSAM(Segment Anything Model)とDINO(Self-Distillation with No Labels)を組み合わせ、画像セグメントの検索精度を向上させ、より正確な場所の再認識を実現することを目指しています。

この技術の中核は、画像セグメントの検索能力にあります。研究チームは、Baidu、VPAir、Pitts、17placesなど、様々なデータセットを使用し、包括的なテスト基盤を提供しています。ユーザーが簡単に使用できるように、研究者たちは、まず小さなデータセットである17placesから始めることを推奨しています。

データセットの準備では、データセットのフォルダ名を、設定ファイルの名前と一致させる必要があります。これにより、データがスムーズに読み込まれます。

次に、DINOまたはSAMモデルを使用して特徴抽出を行い、VLADクラスタ中心を生成します。クラスタ中心の生成手順は任意であり、既存の中心はキャッシュから直接呼び出すことができます。特徴抽出が完了したら、PCAモデルを抽出し、メインのSegVLADパイプラインを実行して最終結果を取得します。すべての結果は保存することができ、後続のオフライン検索計算に便利です。

この研究は、新しい視覚位置認識手法を提供するだけでなく、最新の深層学習モデルを用いた画像解析の方法を示し、この分野の更なる発展を促しています。

プロジェクトページ:https://github.com/AnyLoc/Revisit-Anything

要点:

🌟 SAMとDINO技術を組み合わせた、斬新な視覚位置認識手法。

📊 特定のデータセットの準備と設定ファイルの設定により、迅速に実験を開始・実行可能。

🔍 SegVLADの高効率な結果を得るための詳細な手順とスクリプトを提供。