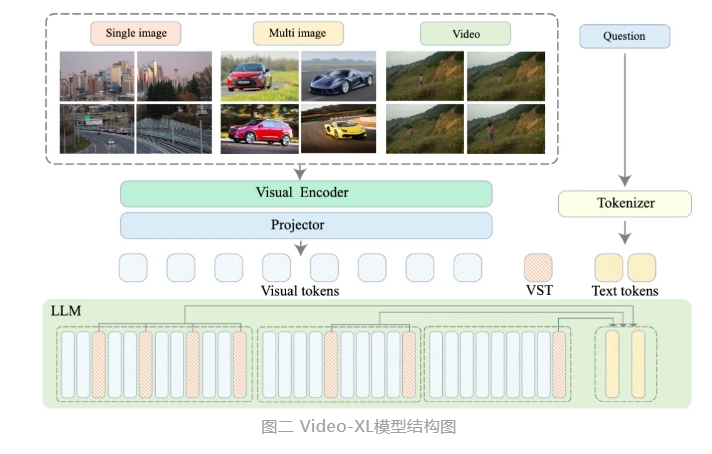

北京智源人工知能研究院は、上海交通大学、中国人民大学、北京大学、北京郵電大学などの大学と共同で、Video-XLという超長尺動画理解大規模モデルを開発しました。このモデルは、マルチモーダル大規模モデルの中核能力を効果的に示しており、汎用人工知能(AGI)への重要な一歩でもあります。既存のマルチモーダル大規模モデルと比較して、Video-XLは10分を超える長尺動画の処理において、優れた性能と効率性を発揮します。

Video-XLは、言語モデル(LLM)の固有能力を活用して、長尺の視覚シーケンスを圧縮し、短尺動画の理解能力を維持しながら、長尺動画の理解において優れた汎化能力を示します。このモデルは、複数の主要な長尺動画理解ベンチマーク評価における多くのタスクで1位を獲得しました。Video-XLは効率性と性能のバランスに優れており、80GBのメモリを搭載したGPU1枚だけで2048フレームの入力処理が可能で、数時間の長尺動画をサンプリングし、「大海から針を見つける」タスクで約95%の精度を達成しました。

Video-XLは、映画の要約、動画の異常検知、広告挿入検知などのアプリケーションシナリオで幅広い応用価値を発揮し、長尺動画理解の強力なツールとなることが期待されます。このモデルの発表は、長尺動画理解技術の効率性と正確性において重要な一歩を踏み出したことを示しており、将来の長尺動画コンテンツの自動処理と分析に強力な技術サポートを提供します。

現在、Video-XLのモデルコードはオープンソース化されており、世界中のマルチモーダル動画理解研究コミュニティの協力と技術共有を促進します。

論文タイトル:Video-XL: Extra-Long Vision Language Model for Hour-Scale Video Understanding

論文リンク:https://arxiv.org/abs/2409.14485

モデルリンク:https://huggingface.co/sy1998/Video_XL

プロジェクトリンク:https://github.com/VectorSpaceLab/Video-XL