最近、シアトルのスタートアップ企業Moondreamが、moondream2というコンパクトなビジョン言語モデルを発表しました。小型ながら、様々なベンチマークテストで優れた性能を示し、注目を集めています。オープンソースモデルであるmoondream2は、スマートフォンでのローカル画像認識機能の実現に期待されています。

3月に正式リリースされたmoondream2は、テキストと画像の入力を処理し、質問応答、テキスト抽出(OCR)、物体カウント、物体分類などの機能を備えています。リリース以来、Moondreamチームはモデルの継続的な更新を行い、ベンチマーク性能を向上させてきました。7月版では、OCRと文書理解において顕著な進歩が見られ、特に歴史的経済データの分析で優れた成果を示しました。DocVQA、TextVQA、GQAでのスコアは全て60%を超え、ローカル実行時の強力な能力を示しています。

moondream2の大きな特徴は、そのコンパクトなサイズです。わずか16億個のパラメータしか持たないため、クラウドサーバー上での実行だけでなく、ローカルコンピュータ、さらにはスマートフォンやシングルボードコンピュータなどの低性能デバイス上でも実行可能です。

小型ながら、数十億個のパラメータを持つ競合モデルと同等の性能を発揮し、一部のベンチマークテストではそれらの大型モデルを上回る結果も出ています。

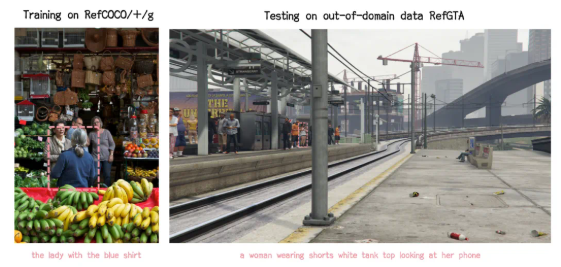

モバイルデバイス向けビジョン言語モデルの比較において、研究者らは、moondream2のパラメータ数が1.7億個しかないにもかかわらず、7億個のパラメータを持つモデルと同等の性能を示し、SQAデータセットでのみやや劣る結果だったと指摘しています。これは、小型モデルが優れた性能を示す一方で、特定のコンテキストの理解においてはまだ課題が残っていることを示唆しています。

開発者のVikhyat Korrapati氏によると、moondream2はSigLIP、マイクロソフトのPhi-1.5、LLaVAなどのモデルのトレーニングデータセットに基づいて構築されています。このオープンソースモデルは、GitHubで無料でダウンロード可能で、Hugging Faceでデモ版も公開されています。コーディングプラットフォーム上でも、moondream2は開発者コミュニティから大きな注目を集め、5000を超えるスター評価を獲得しています。

この成功は投資家の注目を集め、Felicis Ventures、マイクロソフトのM12 GitHubファンド、Ascendが主導するシードラウンドで、Moondreamは450万ドルの資金調達に成功しました。CEOのJay Allen氏はアマゾンウェブサービス(AWS)で長年勤務しており、この成長著しいスタートアップ企業を率いています。

moondream2の発表は、より大きく古いモデルと同様の性能を提供しながら、必要なリソースが少ない、専門的に最適化されたオープンソースモデルの誕生を告げるものです。現在市場には、アップルのスマートアシスタントやグーグルのGemini Nanoなど、小型のローカルモデルがいくつか存在しますが、これらの企業は依然としてより複雑なタスクをクラウドにアウトソーシングしています。

huggingface:https://huggingface.co/vikhyatk/moondream2

github:https://github.com/vikhyat/moondream

要点:

🌟 Moondreamは、わずか1.6億個のパラメータを持つビジョン言語モデルmoondream2を発表。スマートフォンなどの小型デバイスで動作します。

📈 強力なテキストと画像処理能力を備え、質問応答、OCR、物体カウント、分類が可能。ベンチマークテストで優れた成績を収めています。

💰 Moondreamは450万ドルの資金調達に成功。CEOはアマゾン勤務経験者。チームはモデル性能の継続的な向上に努めています。