非営利AI研究機関Ai2は、最新のOLMo2シリーズを発表しました。これは同機関が開発した「オープン言語モデル」(OLMo)シリーズの第2世代モデルです。OLMo2の発表は、AIコミュニティに強力な技術サポートを提供するだけでなく、完全にオープンソースであるという特性から、オープンソースAIの最新の発展を示しています。

MetaのLlamaシリーズなどの、現在市場に出回っている他の「オープン」言語モデルとは異なり、OLMo2はオープンソースイニシアチブの厳格な定義に準拠しています。これは、開発に使用されたトレーニングデータ、ツール、コードがすべて公開されており、誰でもアクセスして使用できることを意味します。オープンソース促進会の定義によると、OLMo2は同機関が10月に最終決定した「オープンソースAI」基準を満たしています。

Ai2はブログで、OLMo2の開発において、すべてのトレーニングデータ、コード、トレーニング方法、評価方法、中間チェックポイントが完全に公開されていると述べています。これは、リソースを共有することで、オープンソースコミュニティのイノベーションと発見を促進することを目的としています。「データ、方法、発見を公開することで、オープンソースコミュニティに新しい方法と革新的な技術を発見するためのリソースを提供したいと考えています。」とAi2は述べています。

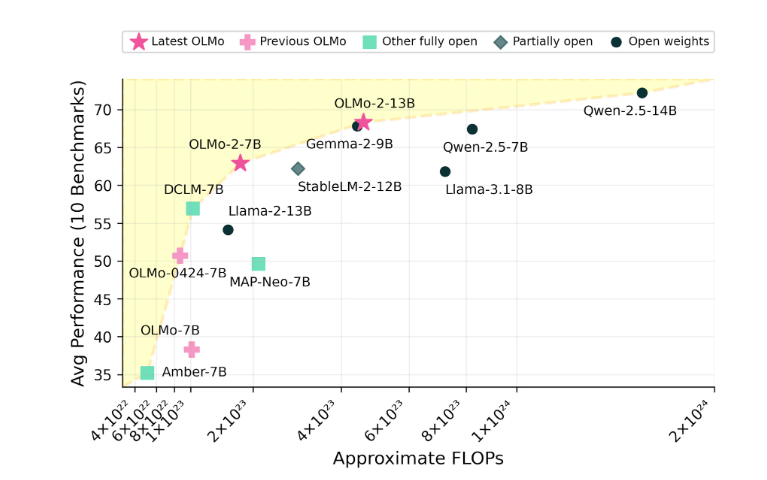

OLMo2シリーズには、70億パラメーターのOLMo7Bと130億パラメーターのOLMo13Bの2つのバージョンがあります。パラメーターの数が多いほど、モデルのパフォーマンスに直接影響し、パラメーターが多いバージョンは通常、より複雑なタスクを処理できます。一般的なテキストタスクにおいて、OLMo2は質問応答、文書要約、コード作成などのタスクをこなせる優れたパフォーマンスを示しています。

画像出典:AI生成画像、画像ライセンス提供元Midjourney

OLMo2のトレーニングには、5兆個のトークンを含むデータセットが使用されました。トークンは言語モデルにおける最小単位であり、100万個のトークンは約75万語に相当します。トレーニングデータには、高品質のウェブサイト、学術論文、Q&Aフォーラム、合成数学練習帳からのコンテンツが含まれており、これらのデータはモデルの効率性と正確性を確保するために厳選されています。

Ai2はOLMo2のパフォーマンスに自信を持っており、その性能はMetaのLlama3.1などのオープンソースモデルと競争できると主張しています。Ai2は、OLMo2 7BのパフォーマンスがLlama3.1 8Bを上回り、現在最も強力な完全にオープンな言語モデルの1つであると指摘しています。すべてのOLMo2モデルとそのコンポーネントは、Ai2の公式ウェブサイトから無料でダウンロードでき、Apache2.0ライセンスに従います。これは、これらのモデルが研究目的だけでなく、商業用途にも使用できることを意味します。