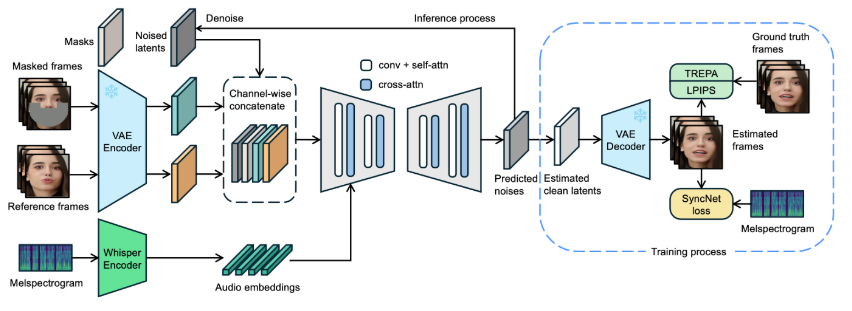

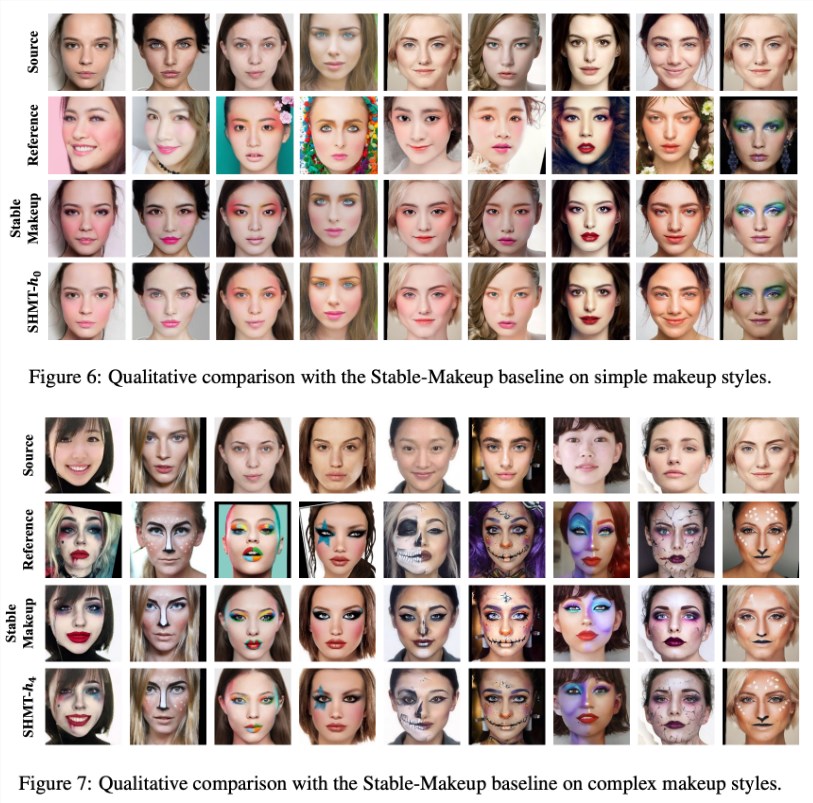

先日、アリババの達摩院研究チームが重要な研究成果を発表しました。「SHMT:自己教師あり階層的メイクアップ転移」というこの論文は、国際的なトップレベルの学術会議NeurIPS2024に採択されました。この研究は、潜在拡散モデル(Latent Diffusion Models)を利用して、メイクアップ画像の精密な生成を実現する新しいメイクアップ効果転移技術を示しており、メイクアップアプリケーションと画像処理分野に新たな活力を注ぎ込んでいます。

簡単に言うと、SHMTはメイクアップ転移技術です。メイクアップ済みの参考画像と、対象となる人物の写真があれば、そのメイクアップ効果を対象者の顔に移すことができます。

チームは、トレーニングコード、テストコード、および事前トレーニング済みモデルを公開するオープンソース方式を採用することで、研究者が関連する研究開発をより容易に行えるようにしました。

モデル構築において、チームはユーザーに「ldm」という名前のconda環境を作成し、提供された環境ファイルを使用して迅速に設定を完了することを推奨しています。さらに、研究ではVQ-f4を事前トレーニング済みのオートエンコーダーモデルとして採用しており、ユーザーはそれをダウンロードして指定されたチェックポイントフォルダに入れる必要があります。これにより、推論をスムーズに開始できます。

データの準備は、SHMTモデルの成功した実行の鍵となります。研究チームは、「BeautyGAN」が提供するメイクアップ転移データセットをダウンロードし、異なるメイクアップ画像と非メイクアップ画像を統合することを推奨しています。同時に、顔解析と3D顔データの準備も非常に重要であり、関連ツールとデータパスは研究で詳細に説明されており、ユーザーが効果的にデータ準備を行うことができるように配慮されています。

モデルのトレーニングと推論に関して、研究チームは詳細なコマンドラインスクリプトを提供しており、ユーザーは自身のニーズに合わせてパラメーターを調整できます。チームはデータ構造の重要性を特に強調しており、明確なディレクトリ構造の例を提供して、ユーザーがどのようにデータを準備するかをガイドしています。

SHMTモデルの発表は、自己教師あり学習がメイクアップ効果転移分野で成功裏に適用されたことを示しており、今後、美容、化粧品、画像処理などの業界で広く活用される可能性があります。この研究は、技術の可能性を示しただけでなく、関連分野の更なる研究の基礎も築きました。

プロジェクト入口:https://github.com/Snowfallingplum/SHMT

要点:

1. 🎓 SHMTモデルは潜在拡散モデルを利用してメイクアップ効果の転移を実現し、NeurIPS2024に採択されました。

2. 🔧 チームは完全なオープンソースコードと事前トレーニング済みモデルを提供し、研究者による応用と改良を容易にしています。

3. 📂 データの準備とパラメーター調整は非常に重要であり、研究では操作手順とディレクトリ構造を詳細に説明しています。