Hugging Faceが注目すべきAIモデル、SmolVLMを発表しました。この視覚言語モデルは非常にコンパクトで、スマートフォンなどの小型デバイスでも動作し、大規模データセンターを必要とする従来のモデルを凌駕する性能を誇ります。

SmolVLM-256MモデルのGPUメモリ使用量は1GB未満ですが、300倍の規模を誇る前身モデルIdefics80Bモデルを上回る性能を発揮します。これは、実用的なAI導入における大きな進歩を示しています。

Hugging Faceの機械学習研究エンジニアであるアンドレス・マラフィオティ氏によると、SmolVLMモデルは市場投入と同時に、企業にとって計算コストの大幅削減をもたらします。「2023年8月に発表したIdefics80Bは、初のオープンソースのビデオ言語モデルでしたが、SmolVLMはサイズを300分の1に縮小しながら、性能を向上させています」と、マラフィオティ氏は『アントレプレナー・デイリー』のインタビューで述べています。

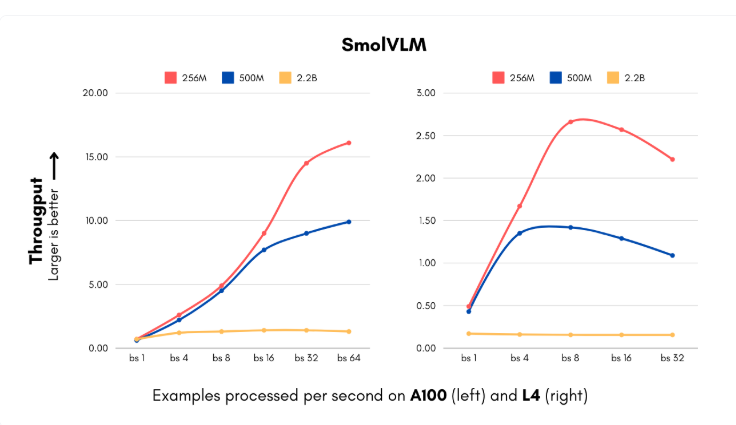

SmolVLMモデルの発表は、企業がAIシステム導入において高額な計算コストに直面している時期と重なります。この新しいモデルは、256Mと500Mの2種類のモデルサイズがあり、これまで想像もできなかった速度で画像を処理し、視覚的な内容を理解できます。最小版は毎秒16インスタンスを処理でき、メモリ使用量はわずか15GBです。大量の視覚データを処理する必要がある企業に最適です。月間100万枚の画像を処理する中規模企業にとっては、年間の計算コストを大幅に削減できます。

さらに、IBMもHugging Faceと提携し、256Mモデルをドキュメント処理ソフトウェアDoclingに統合しました。IBMは豊富な計算リソースを保有していますが、より小さなモデルを使用することで、数百万件のファイルを低コストで効率的に処理できます。

Hugging Faceチームは、視覚処理と言語コンポーネントの技術革新により、モデルサイズを縮小しながら性能を維持することに成功しました。従来の4億パラメーターの視覚エンコーダーを9300万パラメーターのバージョンに置き換え、より積極的なトークン圧縮技術を実装しました。これらの革新により、中小企業やスタートアップ企業は短期間で複雑なコンピュータービジョン製品を導入でき、インフラストラクチャコストも大幅に削減できます。

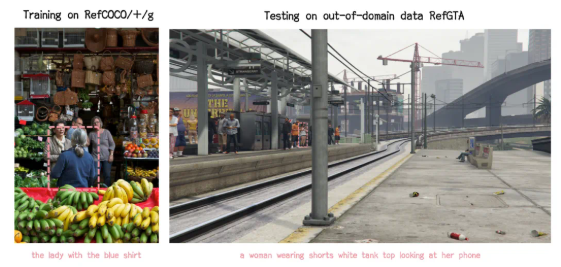

SmolVLMのトレーニングデータセットには、1億7000万個のトレーニングサンプルが含まれており、その約半分はドキュメント処理と画像アノテーションに使用されています。これらの進歩はコスト削減だけでなく、企業に新たな応用可能性をもたらし、視覚検索能力をかつてないレベルに引き上げます。

Hugging Faceのこの進歩は、モデルサイズと能力の関係に関する従来の考え方に挑戦するものです。SmolVLMは、小型で効率的なアーキテクチャでも優れた性能を実現できることを証明しており、将来のAI開発は、より大規模なモデルを目指すのではなく、より柔軟で効率的なシステムを目指す方向に向かう可能性があります。

モデル:https://huggingface.co/blog/smolervlm

要点:

🌟 Hugging Faceが発表したSmolVLMモデルは、スマートフォンで動作し、300倍の規模のIdefics80Bモデルを上回る性能を発揮します。

💰 SmolVLMモデルは、企業の計算コストを大幅に削減し、処理速度は毎秒16インスタンスに達します。

🚀 このモデルの技術革新により、中小企業やスタートアップ企業は、短期間で複雑なコンピュータービジョン製品を導入できます。