Metaとウォータールー大学の研究者らが共同で開発した、MoChaという新しいAIシステムが発表されました。これは、簡単なテキストの説明から、同期した音声と自然な動きを伴う完全なアニメーションキャラクターを生成できる画期的なシステムです。この革新的な技術は、コンテンツ制作の効率と表現力を大幅に向上させ、様々な分野で大きな可能性を秘めています。

従来を打破、全身アニメーションと正確な口パク同期

これまでのAIモデルが顔の表情に重点を置いていたのに対し、MoChaの最大の特徴は、全身の自然な動きをレンダリングできる点にあります。近距離でも半近距離でも、テキストの内容に基づいて、唇の同期、ジェスチャー、複数キャラクター間のインタラクションなど、細やかな動きを生成できます。初期のデモでは主に上半身に焦点を当て、キャラクターの口パクが会話内容と正確に一致し、ボディランゲージもテキストの意味と自然に調和している様子が示されました。

より正確な唇の同期を実現するため、研究チームは「音声-ビデオウィンドウアテンション」メカニズムという革新的な手法を導入しました。このメカニズムは、AIビデオ生成における長年の課題である、高解像度のオーディオを維持しながらビデオ処理における情報圧縮と、並列ビデオ生成における口パクのずれの問題を効果的に解決します。その核心は、各フレームの画像が特定のウィンドウ範囲内のオーディオデータのみにアクセスするよう制限する点にあります。この方法は、人間の音声の動作様式、つまり口の動きは瞬時の音に依存し、ボディランゲージはより広いテキストパターンに従うという点を模倣しています。各オーディオの前後にマーカーを追加することで、MoChaはよりスムーズなトランジションとより正確な唇の同期効果を生み出します。

複数キャラクターの容易な管理、シンプルで効率的なプロンプトシステム

複数キャラクターを含むシーンを処理する場合、MoChaチームはシンプルで効率的なプロンプトシステムを開発しました。ユーザーは一度だけキャラクター情報を定義すれば、「Person1」、「Person2」などの簡単なタグを使用して、異なるシーンでこれらのキャラクターを参照できます。この方法により、キャラクターの繰り返し記述による煩雑な作業を回避し、複数キャラクターアニメーションの作成をより容易にします。

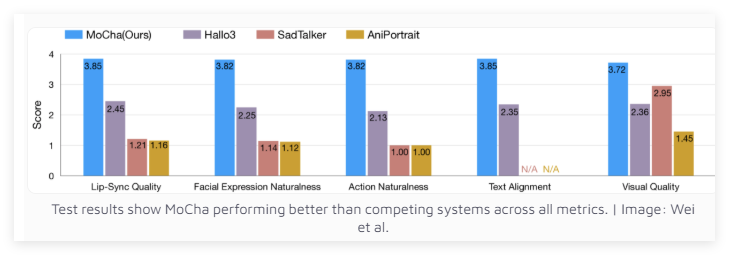

優れた性能、同等のシステムを凌駕

150種類の異なるシーンでのテストの結果、MoChaは唇の同期と自然な動きの質において、同等のシステムを上回りました。独立した評価者から、MoChaが生成したビデオのリアルさについて高い評価を得ています。テスト結果から、MoChaはあらゆる指標において競合他社を凌駕する能力を示しました。

Metaの研究チームは、MoChaがデジタルアシスタント、バーチャルアバター、広告、教育コンテンツなどの分野で大きな可能性を秘めていると考えています。しかし、Metaは、このシステムがオープンソース化されるか、それとも研究プロトタイプとして残るのかについては明らかにしていません。注目すべきは、MoChaの開発は、主要なソーシャルメディア企業がAI駆動のビデオ技術の開発を競っている重要な時期に行われているということです。

以前、MetaはMovieGenを発表しており、TikTokの親会社であるバイトダンスも、INFP、OmniHuman-1、Gokuなど、独自のAIアニメーションシステムを積極的に開発しています。このAIビデオ技術の競争は、間違いなく関連技術の進歩と普及を加速させるでしょう。

プロジェクト入口:https://top.aibase.com/tool/mocha