中国の人工知能研究機関DeepSeek AIは、強力なオープンソース言語モデルDeepSeek-R1に続く大きな進歩として、大規模言語モデル(LLM)分野で画期的な技術を発表しました。最近、より汎用的で拡張性の高いAI報酬モデル(Reward Models、RM)を構築することを目指した、Self-Principled Critique Tuning(SPCT)という革新的な技術を発表しました。この技術は、AIがオープンなタスクや複雑な環境における理解力と対応能力を大幅に向上させ、よりスマートなAIアプリケーションへの道を拓くと期待されています。

背景:報酬モデル—強化学習の「道標」

高度なLLMの開発において、強化学習(Reinforcement Learning、RL)は重要な技術となっています。RLはフィードバック信号を用いてモデルの微調整を行い、より質の高い応答を生成できるようにします。この過程で、報酬モデルは「審判」のような極めて重要な役割を果たし、LLMの出力の評価を行い、それに応じたスコアや「報酬」を与えます。これらの報酬信号はRLプロセスを効果的に導き、LLMがより有益なコンテンツを学習するよう促します。

しかし、現在の報酬モデルには多くの制限があります。ルールが明確で、答えが容易に検証できる狭い分野では優れた性能を示しますが、DeepSeek-R1などのモデルが数学やプログラミング問題で優れた成果を上げているのは、これらの問題に明確な「正解」があるためです。しかし、複雑で、オープンで、主観性の強い一般的なクエリに対しては、効果的な報酬モデルを構築することは依然として大きな課題です。DeepSeek AIの研究者たちは論文の中で、「汎用報酬モデルは、特定の分野以外で高品質の報酬を生成する必要がありますが、これらの分野の報酬基準はより多様で複雑であり、明確な参照や標準的な答えがないことがよくあります」と述べています。

SPCT:4つの課題への対応、汎用報酬モデルの構築

既存の報酬モデルの限界を克服するために、DeepSeek AIの研究者たちはSPCTという全く新しい技術を提案しました。彼らは、汎用報酬モデルの構築に必要な4つの重要な課題を強調しました。

- 入力の柔軟性(Input flexibility):報酬モデルは、さまざまな入力タイプを処理でき、1つ以上の応答を同時に評価できなければなりません。

- 正確性(Accuracy):標準的で複雑で、明確な答えがないさまざまな分野において、報酬モデルは正確な報酬信号を生成できなければなりません。

- 推論時の拡張性(Inference-time scalability):より多くの計算リソースを推論に割り当てると、報酬モデルはより高品質の報酬を生成できる必要があります。

- 学習可能な拡張性のある行動(Learning scalable behaviors):報酬モデルが推論時に効果的に拡張できるようにするためには、計算リソースの増加に伴って性能が向上する行動を学習する必要があります。

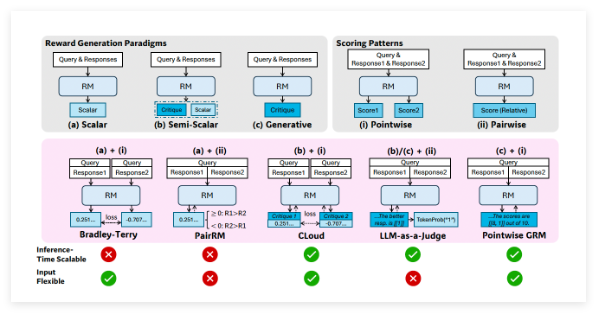

研究者たちは、「ポイントワイズ生成報酬モデリング」(Pointwise Generative Reward Modeling、GRM)、つまりモデルがテキストコメントを生成し、そこからスコアを導き出す方法が、汎用タスクに必要な柔軟性と拡張性を提供できると指摘しています。DeepSeekチームは、GPT-4oやGemma-2-27Bなどのモデルで行った予備実験で、「特定の原則が、生成報酬モデルが適切な基準内で報酬を生成することを導き、報酬の質を向上させる可能性がある」ことを示し、高品質の原則と正確なコメントの生成を拡張することで、報酬モデルの推論時の拡張性を実現できることを示唆しました。

SPCTの中核メカニズム:自己主導原則と批判的調整

上記の発見に基づき、DeepSeekチームはSPCT技術を開発しました。この技術は、GRMを訓練して、クエリと応答に基づいて動的に原則とコメントを生成します。研究者たちは、原則は「報酬生成の一部であり、前処理ステップではない」と考えています。このようにすることで、GRMは評価中のタスクに応じて即座に原則を生成し、それらの原則に基づいて批判的な意見を生成できます。

SPCTには2つの主要な段階があります。

- 拒否的微調整(Rejective fine-tuning):この段階では、GRMを訓練して、さまざまな入力タイプに対して正しい形式で原則とコメントを生成します。モデルは、与えられたクエリ/応答に対して、原則、コメント、報酬を生成します。予測された報酬が現実(例えば、より良い応答を正しく識別した場合)と一致した場合のみ、生成された軌跡が受け入れられ、そうでない場合は拒否されます。このプロセスは繰り返し行われ、モデルはフィルタリングされた例で微調整され、原則/コメント生成能力が向上します。

- ルールベースの強化学習(Rule-based RL):この段階では、モデルは結果に基づく強化学習によってさらに微調整されます。GRMは各クエリに対して原則とコメントを生成し、報酬信号は単純な正確性ルールに基づいて計算されます(例えば、既知の最適な応答が選択されたかどうか)。次に、モデルが更新され、GRMは動的で拡張可能な方法で有効な原則と正確なコメントを生成する方法を学習するように促されます。

推論時の拡張性の課題に対処するために、研究者たちは同じ入力に対してGRMを複数回実行し、異なる原則とコメントのセットを生成しました。最終的な報酬は投票(サンプルスコアの集約)によって決定されます。これにより、モデルはより広範な視点を取り入れることができ、より多くのリソースを獲得した場合に、より正確で詳細な最終的な判断を下すことができます。

さらに、生成された原則/コメントの一部が質が低いか、バイアスがある可能性がある問題に対処するために、研究者たちは「メタ報酬モデル」(meta RM)—主要なGRMが生成した原則/コメントが正しい最終的な報酬につながる可能性があるかどうかを予測するために特化した、独立した軽量のスカラーRM—を導入しました。推論プロセスにおいて、メタRMは生成されたサンプルを評価し、低品質の判断をフィルタリングすることで、拡張性をさらに向上させました。

DeepSeek-GRMの優れた性能

研究者たちは、SPCTをGoogleのオープンソースモデルGemma-2-27Bに適用して、DeepSeek-GRM-27Bを作成しました。複数のベンチマークテストで、いくつかの強力なベースラインRM(LLM-as-a-Judge、スカラーRM、半スカラーRMなど)や公開モデル(GPT-4oやNemotron-4-340B-Rewardなど)と評価しました。その結果、DeepSeek-GRM-27Bは、同じデータで訓練されたベースライン手法よりも優れていることが示されました。

標準的な微調整と比較して、SPCTは報酬の質を大幅に向上させ、さらに重要なことに、推論時の拡張性を向上させました。より多くのサンプルを生成して推論時に拡張することで、DeepSeek-GRM-27Bのパフォーマンスは大幅に向上し、Nemotron-4-340B-RewardやGPT-4oなどのより大きなモデルを上回りました。メタRMの導入により、拡張性がさらに向上し、判断をフィルタリングすることで最適な結果が得られました。研究者たちは、「より大規模なサンプリングを行うことで、DeepSeek-GRMはより多様な原則に基づいてより正確な判断を行い、より精緻な報酬を出力できます」と述べています。興味深いことに、検証可能なタスクでは良好な性能を示すものの他の分野では性能が低いスカラーRMと比較して、SPCTはさまざまな分野でバイアスが少ないことを示しました。

より汎用的で拡張性の高い報酬モデルの開発は、エンタープライズレベルのAIアプリケーションに大きな可能性を秘めています。潜在的な恩恵を受ける分野には、創造的なタスクや、モデルが動的な環境(変化する顧客の好みなど)に適応する必要があるアプリケーションが含まれます。

顕著な成果を収めたものの、非生成型RMと比較して、DeepSeek-GRMは純粋に検証可能なタスクにおける性能と効率の点で依然として課題が残っています。DeepSeekチームは、今後の取り組みとして、効率の向上とより深い統合に重点を置くとしています。彼らは、「将来の方向性としては、報酬システムの汎用インターフェースとしてGRMをオンラインRLプロセスに統合すること、戦略モデルとの推論時の協調的な拡張を検討すること、または基礎モデルの堅牢なオフライン評価器として使用することなどが考えられます」と結論付けています。

論文:https://arxiv.org/abs/2504.02495