人工知能分野において、OpenAIのo1モデルとDeepSeekのR1モデルが注目を集める中、大規模言語モデル(LLM)の推論能力とテスト時拡張(TTS)技術は多くの研究者の関心を集めています。しかし、複雑な推論問題を扱う際に、モデルの各ステップの回答の質を正確に評価することは、依然として解決すべき課題です。そこで、清華大学と上海AI Labは、生成式プロセス報酬モデル(GenPRM)を提案し、プロセス監視推論のための革新的なソリューションを提供しました。

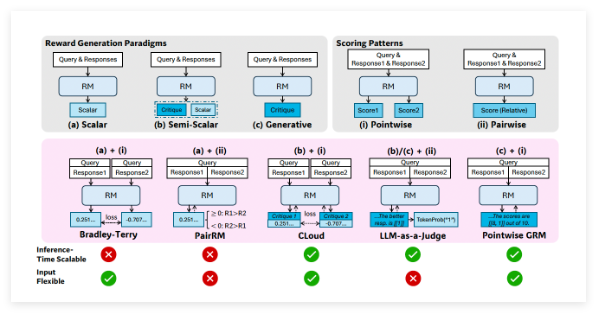

従来のプロセス報酬モデル(PRM)は推論ステップの正しさを検証できますが、スカラー評価メカニズムを採用しているため、深層的な論理エラーを捉えることができません。さらに、PRMの識別的モデリング手法は、テスト段階での拡張能力を制限しています。そこで、GenPRMは生成式思考連鎖推論とコード検証を組み合わせ、テスト時拡張メカニズムを導入することで、全く新しい研究分野を切り開きました。

画像出典:画像はAIで生成され、画像ライセンスサービスプロバイダーMidjourneyによって提供されています。

GenPRMの設計理念は、人間が問題を解く際の思考プロセスを模倣したもので、モデルは各推論ステップで自然言語解析を行い、透明性を高めるとともに、ステップ評価をより解釈可能なものにします。同時に、GenPRMは推論関連のPythonコードを生成・実行し、推論の信頼性を確保します。「まず説明し、次に検証する」というこのメカニズムは、正誤を判断するだけでなく、具体的な改善策も提供するため、プロセス監視の効果を大幅に向上させます。

驚くべきことに、GenPRMはわずか23,000個の訓練サンプルで、GPT-4oを上回る優れた性能を達成しました。ProcessBenchなどの数学的推論ベンチマークテストにおいて、15億パラメータのGenPRMはテスト時拡張技術の恩恵を受け、優れた性能を発揮しました。一方、70億パラメータのバージョンは、720億パラメータのQwen2.5-Math-PRMを凌駕し、強力なステップレベルの批判能力を示しました。

さらに、GenPRMの利点は、効率的なデータ合成手法にもあります。相対的進歩推定(RPE)とコード検証により、GenPRMは高品質のプロセス監視データを作成し、大量の注釈データへの依存を大幅に削減しました。研究者らはQwQ-32Bモデルを使用してデータを合成し、コンセンサスフィルタリングによって高品質のサンプルを選択することで、最終的にわずか23,000個の訓練データセットを作成しました。

将来的には、GenPRMは回答の検証ツールとしてだけでなく、「コーチ」としての役割も果たし、フィードバックを通じて戦略モデルの反復的な最適化を導きます。「生成・批判・熟考」という閉ループは、大規模言語モデルの自己改善のための全く新しい道を提供し、将来的にはコード生成やマルチモーダル推論などの分野にも拡大する可能性があります。