先日、Metaは6つの研究成果を静かに発表し、AI分野に新たな応用と技術的ブレークスルーをもたらしました。これには、マルチモーダルモデル、テキストから音楽を生成するモデル、オーディオウォーターマーキング技術、データセットなどが含まれています。これらの研究成果を詳しく見ていきましょう。

Meta Chameleon(「カメレオン」モデル)

まず、発表されたマルチモーダルモデル「Chameleon」は、テキストと画像の両方を同時に処理し、混合入力とテキスト出力に対応することで、マルチモーダルデータ処理に全く新しいソリューションを提供します。

現在のほとんどの後期融合モデルは拡散ベースの学習を使用していますが、Meta Chameleonはテキストと画像にトークン化を使用しています。これにより、より統一的な手法を実現し、モデルの設計、保守、拡張を容易にします。

下記の動画例:画像から創造的なタイトルを生成したり、テキストプロンプトと画像を組み合わせて全く新しいシーンを作成したりします。

現在、Metaは研究ライセンスに基づき、Chameleon 7Bと34Bモデルの主要コンポーネントを公開しています。現在公開されているモデルは安全性を考慮して調整されており、混合モード入力と純粋なテキスト出力をサポートし、研究目的で使用できます。公式には、Chameleonの画像生成モデルは公開しないと強調されています。

アクセス方法:https://top.aibase.com/tool/meta-chameleon

Multi-Token Prediction(複数トークン予測)

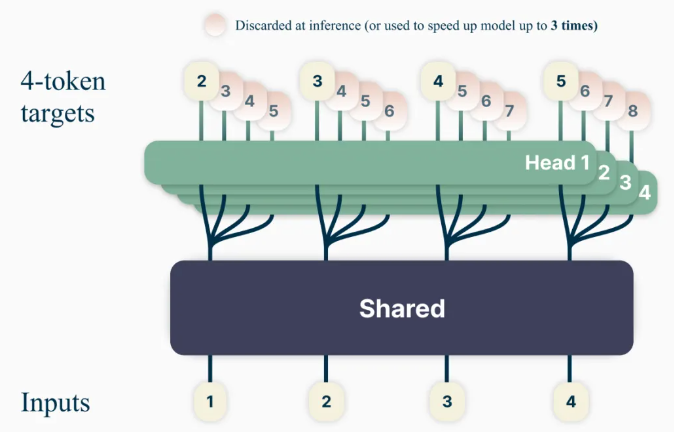

新しい言語モデルのトレーニング方法「Multi-Token Prediction」は、モデルの能力とトレーニング効率を向上させることを目的としており、モデルが一度に複数の単語を予測することで、予測精度を向上させます。

この方法を使用することで、従来のように一度に1単語ずつ予測するのではなく、言語モデルは複数の将来の単語を同時に予測するようにトレーニングできます。これにより、モデルの能力とトレーニング効率が向上し、速度も向上します。責任あるオープンサイエンスの精神に基づき、非商業目的/研究専用のライセンスで、コード補完のために事前トレーニングされたモデルを公開します。

アクセス方法:https://top.aibase.com/tool/multi-token-prediction

テキストから音楽を生成するモデル「JASCO」

既存のテキストから音楽を生成するモデル(MusicGenなど)は主にテキスト入力に依存して音楽を生成しますが、Metaの新しいモデル「時間制御されたテキストから音楽への生成のためのメタ結合オーディオと記号条件」(JASCO)は、特定のコードやビートなどの様々な条件入力を受け入れることができ、生成された音楽出力のコントロールを改善します。具体的には、情報ボトルネック層と時間的曖昧さを組み合わせることで、特定のコントロールに関連する情報を抽出できます。これにより、同じテキストから音楽を生成するモデル内で、記号ベースとオーディオベースの条件を同時に組み合わせることができます。

JASCOは、生成品質において評価基準とほぼ同等でありながら、生成された音楽をより良く、より柔軟に制御できます。研究論文とサンプルページを公開し、今月末にはMITライセンスの下でAudioCraftリポジトリの一部として推論コードを、CC-BY-NCの下で事前トレーニングされたモデルを公開する予定です。

コードアクセス:https://top.aibase.com/tool/audiocraft

オーディオウォーターマーキング技術「AudioSeal」

これは、AI生成音声の局所検出のために特別に設計された最初のオーディオウォーターマーキング技術であり、長い音声セグメント内のAI生成セグメントを正確に特定できます。AudioSealは、ステガノグラフィではなく、AI生成コンテンツの検出に焦点を当てることで、従来のオーディオウォーターマーキングを改良しています。

複雑な復号化アルゴリズムに依存する従来の方法とは異なり、AudioSealの局所検出方法は、より高速で効率的な検出を実現します。以前の方法と比較して、この設計により検出速度が485倍向上し、大規模かつリアルタイムのアプリケーションに非常に適しています。私たちの方法は、オーディオウォーターマーキングの堅牢性と不可知覚性において最先端の性能を実現しています。

AudioSealは商業ライセンスで公開されています。

アクセス方法:https://top.aibase.com/tool/audioseal

PRISMデータセット

同時に、Metaは外部パートナーとの協力でPRISMデータセットも公開しました。これは、世界中の1500人の参加者の会話データと好みを含んでおり、大規模言語モデルの改良に使用され、モデルの会話の多様性、好みの多様性、社会的便益を向上させます。

このデータセットは、各人の好みと詳細なフィードバックを、21種類の異なるLLMとの8011回のリアルタイム会話にマッピングしています。

データセットアクセス:https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

「DIG In」指標

テキストから画像を生成するモデルに存在する地理的差異を評価するために使用され、モデルの改良のためのより多くの参照データを提供します。異なる地域の人々が地理的表現についてどのように考えているかを理解するために、Metaは大規模な注釈調査を実施しました。魅力、類似性、一貫性、共有された提案を含め、65,000件以上の注釈と20件以上の調査回答を収集し、テキストから画像へのモデルの自動および手動評価を改善しました。

コードアクセス:https://top.aibase.com/tool/dig-in

これらのプロジェクトの発表は、AI分野に新たな技術的ブレークスルーと応用への展望をもたらし、AI技術の発展と応用を推進する上で重要な意味を持ちます。