OpenAIの研究者らは木曜日、ChatGPTが生成したコードのエラーを識別し修正することを目的とした革新的なAIモデル、CriticGPTを発表しました。この画期的な進歩は、人工知能技術における自己改善と品質管理において重要な一歩を踏み出したことを示しています。

CriticGPTの主な特徴

1. GPT-4シリーズに基づく:CriticGPTは、強力なGPT-4言語モデルを基盤として構築されています。

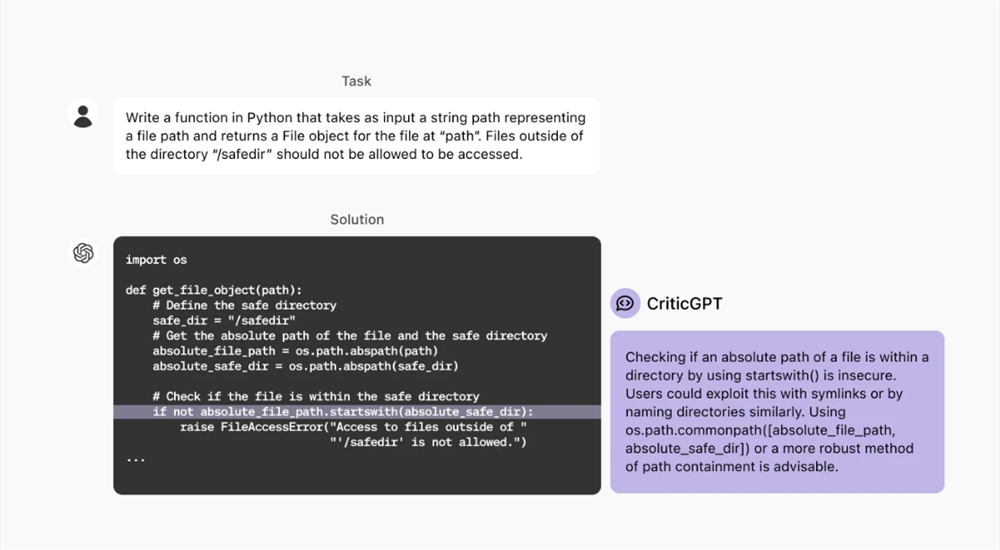

2. コードレビューに特化:主にChatGPTが生成したプログラミングコードを分析し、潜在的なエラーを指摘するために使用されます。

3. 人工知能と人間の協働:人間のトレーナーのAIアシスタントとして、コードレビューの効率と正確性を向上させます。

4. 強化学習:人間のフィードバックから学習することで(RLHF)、AIシステムの「整合性」を高めます。

開発プロセスと成果

研究者らは、CriticGPTを開発するために革新的なトレーニング方法を採用しました。

1. データセットの準備:意図的にエラーを挿入したコードサンプルを使用してトレーニングを行いました。

2. 人間の参加:人間のトレーナーにChatGPTが書いたコードを修正させ、エラーを導入し、フィードバックを提供してもらいました。

3. 新技術の応用:「強制サンプリング束探索」(FSBS)技術を導入し、詳細なコメントと架空の問題の生成のバランスを取りました。

実験結果

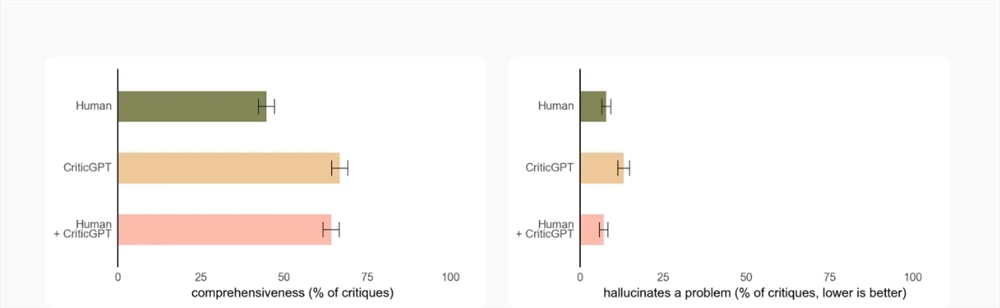

- 自然発生的なエラー事例の63%で、人間はCriticGPTの指摘をより好みました。

- CriticGPTは、無意味な「批判」や誤検知/幻覚の問題を削減しました。

- 以前は完璧だと考えられていた事例の24%で、CriticGPTはエラーを発見し、それが確認されました。

潜在的な応用と限界

CriticGPTは主にコードレビューを対象としていますが、研究によると、非コードタスクにも適用できる可能性があります。しかし、このモデルにはいくつかの限界もあります。

1. 比較的短いChatGPTの回答でトレーニングされているため、より複雑なタスクには適していない可能性があります。

2. 架空の行動は減少しましたが、完全に排除されたわけではありません。

3. 複数の部分に分散しているエラーの識別においては、まだ改善の余地があります。

将来展望

OpenAIは、CriticGPTのようなモデルをRLHFラベリングパイプラインに統合し、トレーナーにAIアシスタントを提供する予定です。これは、大規模言語モデル(LLM)の出力評価ツールの開発における重要な進歩を示しています。しかし、研究者らは、AIアシスタントがあっても、非常に複雑なタスクは人間の評価者にとって依然として困難であることを強調しています。

AI技術の進歩に伴い、CriticGPTのような革新は、AIシステムの正確性と信頼性を向上させる上で重要な役割を果たし、AIと人間のニーズのさらなる整合性を促進するでしょう。

アドレス:https://openai.com/index/finding-gpt4s-mistakes-with-gpt-4/