ALMA-13B-R

高度洗練された機械翻訳モデル

一般製品生産性機械翻訳モデルのファインチューニング

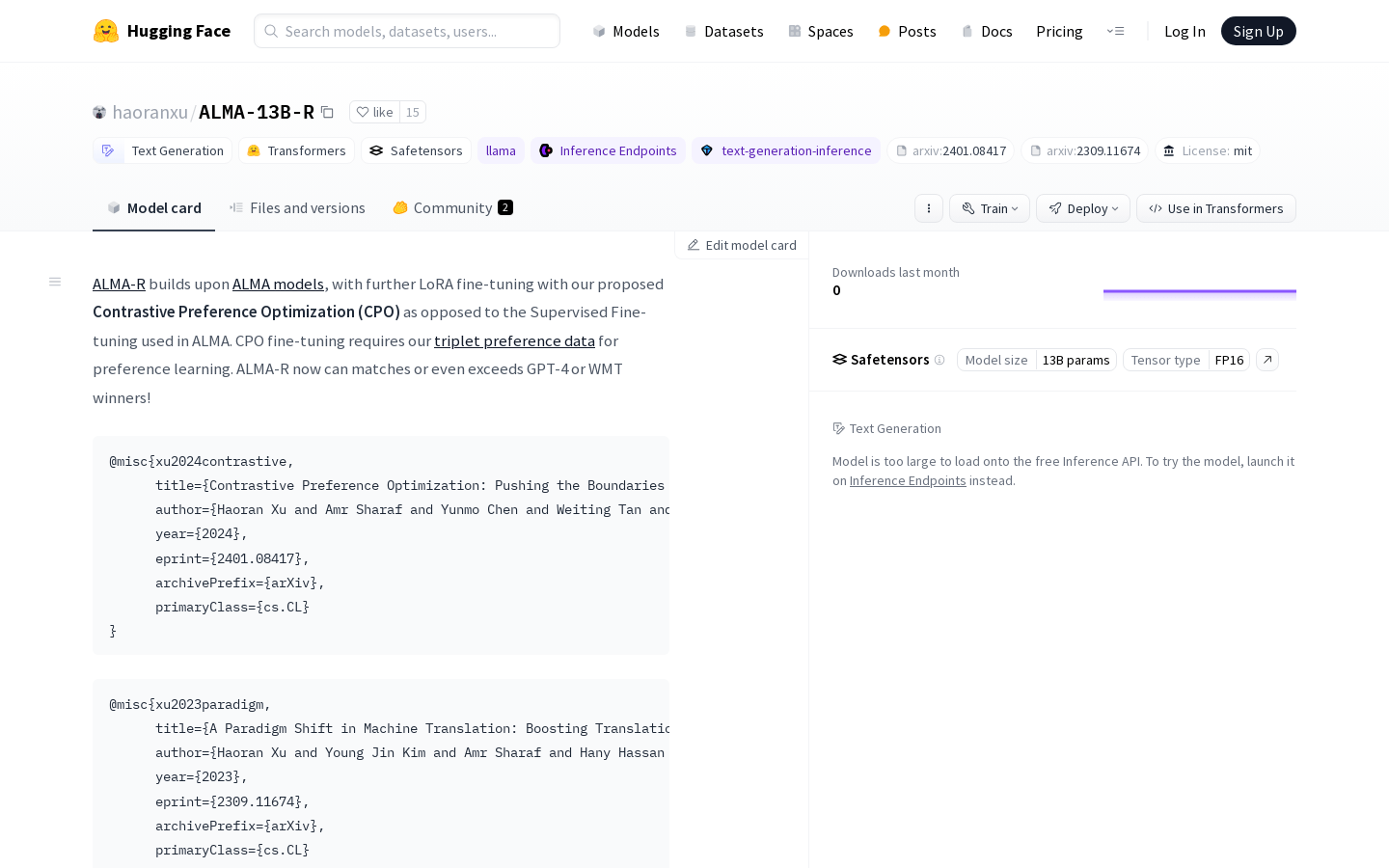

ALMA-Rモデルは、Contrastive Preference Optimization (CPO)を用いたLoRAファインチューニングにより、GPT-4やWMT受賞モデルを凌駕しています。ALMA(-R)モデルとデータセットはGitHubリポジトリからダウンロード可能です。ALMA-RはALMAモデルをベースに構築されており、ALMAで使用された教師ありファインチューニングではなく、提案するContrastive Preference Optimization (CPO)を用いてファインチューニングされています。CPOによるファインチューニングには、三元組選好データを用いた選好学習が必要です。ALMA-Rは現在、GPT-4やWMT受賞モデルに匹敵、あるいはそれらを上回る性能を発揮しています!

ALMA-13B-R 最新のトラフィック状況

月間総訪問数

29742941

直帰率

44.20%

平均ページ/訪問

5.9

平均訪問時間

00:04:44