In einer aktuellen Studie haben Google, die Carnegie Mellon University und das MultiOn-Team die Auswirkungen synthetischer Daten auf das Training großer Sprachmodelle untersucht. Sie stellten fest, dass synthetische Daten die Leistung großer Modelle in der logischen Schlussfolgerung, insbesondere bei der Lösung mathematischer Probleme, deutlich verbessern können – um das Achtfache.

Diese Entdeckung ist angesichts des zunehmenden Mangels an Trainingsdaten von großer Bedeutung. Derzeit stehen weltweit etwa 300 Billionen hochwertige Textdaten für das Training zur Verfügung. Mit der zunehmenden Verbreitung von Modellen wie ChatGPT steigt der Bedarf an Trainingsdaten jedoch rapide an, und es wird erwartet, dass diese Daten bis 2026 nicht mehr ausreichen werden. Vor diesem Hintergrund werden synthetische Daten zu einer entscheidenden Alternative.

Das Forschungsteam untersuchte hauptsächlich zwei Arten synthetischer Daten: positive und negative Daten. Positive Daten sind korrekte Problemlösungen, die von leistungsstarken Modellen wie GPT-4 und Gemini 1.5 Pro generiert wurden und anderen Modellen als Beispiel dienen. Allerdings hat das Training allein mit positiven Daten einige Nachteile. Modelle könnten beispielsweise durch Mustererkennung lernen, ohne den Lösungsprozess wirklich zu verstehen, was zu einer geringeren Generalisierungsfähigkeit führt.

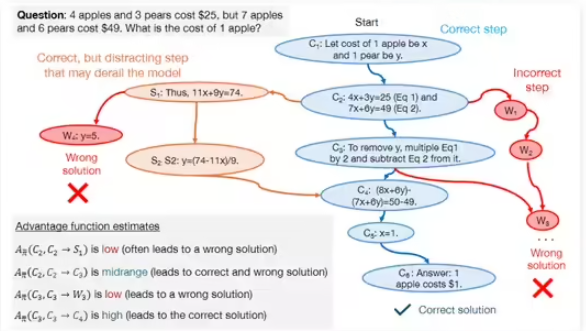

Um diese Nachteile zu überwinden, führte das Forschungsteam negative Daten ein, hauptsächlich falsch verifizierte Lösungsschritte. Diese Daten helfen dem Modell, häufige Fehler zu erkennen und so seine logische Schlussfolgerungsfähigkeit zu verbessern. Obwohl die Verwendung negativer Daten einige Herausforderungen mit sich bringt, da falsche Schritte irreführende Informationen enthalten können, konnten die Forscher durch direkte Präferenzoptimierung (DPO) das Modell in die Lage versetzen, effektiv aus Fehlern zu lernen und die Bedeutung jedes Schritts im Lösungsprozess zu bestimmen.

In der Studie wurden Modelle wie DeepSeek-Math-7B und LLaMa2-7B verwendet und umfangreiche Tests auf den Datensätzen GSM8K und MATH durchgeführt. Die Ergebnisse zeigten, dass große Sprachmodelle, die mit positiven und negativen synthetischen Daten vorab trainiert wurden, ihre Leistung bei mathematischen Schlussfolgerungsaufgaben um das Achtfache verbesserten. Dieses Forschungsergebnis belegt nicht nur das enorme Potenzial synthetischer Daten zur Verbesserung der logischen Schlussfolgerungsfähigkeit großer Sprachmodelle, sondern bietet auch neue Ansätze für das zukünftige Modelltraining.