En un estudio reciente, Google, en colaboración con la Universidad Carnegie Mellon y el equipo de MultiOn, investigó el efecto del uso de datos sintéticos en el entrenamiento de modelos grandes. Descubrieron que los datos sintéticos mejoran significativamente el rendimiento de estos modelos en el razonamiento lógico, especialmente en la resolución de problemas matemáticos, con una mejora asombrosa de ocho veces. Este hallazgo es de gran importancia dado el creciente déficit de datos de entrenamiento.

Actualmente, hay aproximadamente 300 billones de datos de texto de alta calidad disponibles en todo el mundo, pero con la creciente popularidad de modelos como ChatGPT, la demanda de datos de entrenamiento está aumentando drásticamente, y se prevé que estos datos serán insuficientes para 2026. En este contexto, los datos sintéticos se convierten en una alternativa crucial.

El equipo de investigación exploró principalmente dos tipos de datos sintéticos: datos positivos y datos negativos. Los datos positivos son soluciones correctas a problemas generadas por modelos de alto rendimiento como GPT-4 y Gemini1.5Pro, proporcionando ejemplos a otros modelos. Sin embargo, entrenar únicamente con datos positivos presenta algunas limitaciones. Por ejemplo, el modelo podría aprender mediante la coincidencia de patrones sin comprender realmente el proceso de resolución del problema, lo que reduce su capacidad de generalización.

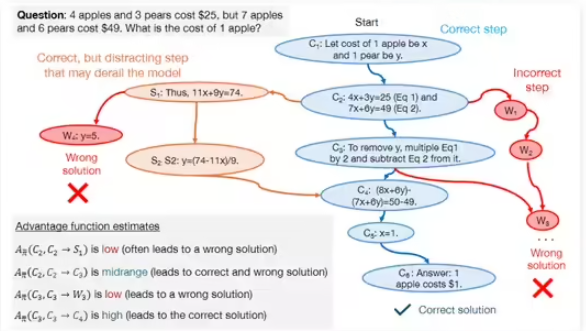

Para superar estas limitaciones, el equipo introdujo datos negativos, que son pasos de resolución de problemas erróneos verificados. Estos datos ayudan al modelo a identificar errores comunes, mejorando así su capacidad de razonamiento lógico. Aunque el uso de datos negativos presenta ciertos desafíos, ya que los pasos erróneos pueden contener información engañosa, los investigadores utilizaron la optimización de preferencia directa (DPO) para permitir que el modelo aprenda eficazmente de los errores, aclarando la importancia de cada paso en el proceso de resolución del problema.

Durante el estudio, el equipo utilizó modelos como DeepSeek-Math-7B y LLaMa2-7B, realizando numerosas pruebas en los conjuntos de datos GSM8K y MATH. Los resultados mostraron que los modelos grandes preentrenados con datos sintéticos positivos y negativos mejoraron su rendimiento en tareas de razonamiento matemático hasta ocho veces. Este resultado de investigación no solo demuestra el enorme potencial de los datos sintéticos para mejorar la capacidad de razonamiento lógico de los modelos grandes, sino que también proporciona nuevas ideas para el entrenamiento de modelos futuros.