Dans une étude récente, Google, en collaboration avec l’université Carnegie Mellon et l’équipe MultiOn, a exploré l’impact des données synthétiques sur l’entraînement des grands modèles. Ils ont découvert que les données synthétiques amélioraient considérablement les performances des grands modèles en matière de raisonnement logique, notamment en résolution de problèmes mathématiques, avec une augmentation impressionnante de huit fois. Cette découverte est d'une importance capitale compte tenu de la pénurie croissante de données d'entraînement.

Actuellement, environ 300 000 milliards de données textuelles de haute qualité sont disponibles dans le monde. Cependant, avec la popularisation de modèles comme ChatGPT, la demande en données d'entraînement augmente considérablement, et on prévoit une insuffisance d'ici 2026. Dans ce contexte, les données synthétiques apparaissent comme une solution de remplacement essentielle.

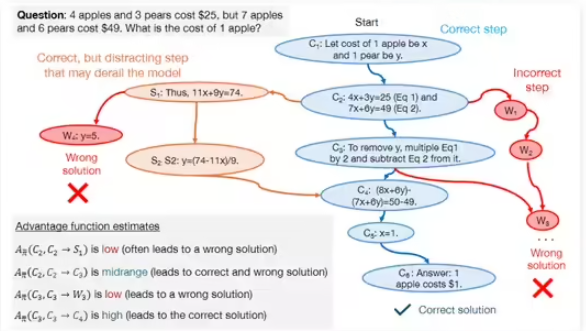

L'équipe de recherche a principalement exploré deux types de données synthétiques : les données positives et les données négatives. Les données positives sont des solutions correctes à des problèmes, générées par des modèles performants comme GPT-4 et Gemini 1.5 Pro. Elles servent d'exemples pour les autres modèles. Cependant, l'entraînement basé uniquement sur des données positives présente des limites. Par exemple, les modèles peuvent apprendre par simple correspondance de motifs sans véritablement comprendre le processus de résolution, ce qui diminue leur capacité de généralisation.

Pour pallier ces limites, l'équipe a introduit des données négatives, c'est-à-dire des étapes de résolution de problèmes erronées et validées comme telles. Ces données aident les modèles à identifier les erreurs courantes et ainsi à améliorer leurs capacités de raisonnement logique. Bien que l'utilisation de données négatives présente des défis, car les étapes erronées peuvent être trompeuses, les chercheurs ont utilisé l'optimisation par préférence directe (DPO) pour permettre aux modèles d'apprendre efficacement des erreurs, en clarifiant l'importance de chaque étape dans le processus de résolution.

Au cours de la recherche, l'équipe a utilisé des modèles tels que DeepSeek-Math-7B et LLaMa2-7B, et a effectué de nombreux tests sur les ensembles de données GSM8K et MATH. Les résultats montrent que les grands modèles pré-entraînés avec des données synthétiques positives et négatives ont vu leurs performances en matière de raisonnement mathématique multipliées par huit. Cette découverte démontre le potentiel énorme des données synthétiques pour améliorer les capacités de raisonnement logique des grands modèles et ouvre de nouvelles perspectives pour l'entraînement futur des modèles.