腾讯推视频生成模型VideoCrafter2 克服数据限制,提高视频质量

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

亚马逊近日对其 AI 视频生成模型 Nova Reel 进行了升级,推出了 Nova Reel1.1版本。这个新版本不仅能够生成长达两分钟的视频片段,还可以制作多镜头视频,使得各个镜头之间的风格保持一致。Nova Reel 于2024年12月首次发布,是亚马逊在生成视频领域的重要尝试。据 AWS 开发倡导者 Elizabeth Fuentes 在一篇博文中透露,用户可以通过提供最长4,000个字符的提示,生成由六秒镜头组成的长视频。新版的 Nova Reel 还引入了一种名为 “Multishot Manual” 的新模式。在这种模式下,用户可以提供图像和文本提

备受瞩目的 AI 研究公司 Runway 近日隆重推出其下一代人工智能模型系列—— Runway Gen-4。本次发布的 Gen-4模型专注于媒体生成和世界一致性,旨在为用户带来前所未有的创作自由和控制力。其中,最引人瞩目的功能便是其能够精确地生成并保持角色、场景和物体在不同镜头中的高度一致性。告别“换脸”烦恼:角色一致性轻松实现以往的 AI 视频生成模型常常面临角色在不同场景中形象不统一的问题,这给叙事创作带来了诸多挑战。Runway Gen-4革命性地解决了这一痛点。用户只需提供单个角色参

你是不是已经看惯了那些由AI生成的,虽然逼真但总感觉少了点“味道”的短视频?现在,一项名为长上下文调整 (Long Context Tuning, LCT) 的创新技术横空出世,它让AI视频生成模型拥有了执导多镜头叙事视频的能力,如同电影和电视剧那样,在不同镜头之间自由切换,构建出更连贯、更引人入胜的故事场景。过去,顶尖的AI视频生成模型,比如SoRA,Kling,Gen3,已经能够创造出长达一分钟的逼真单镜头视频。但这与真实世界中,由多个镜头组成的叙事视频(比如电影中的一个场景)的需求之

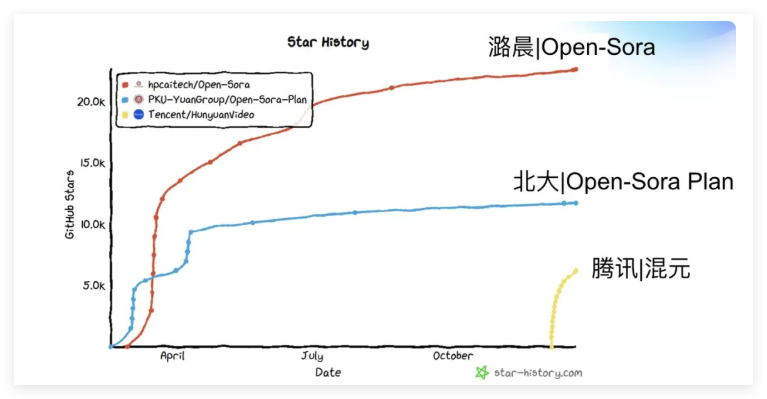

听说过壕无人性的 OpenAI Sora 吧?动辄几百万美元的训练成本,简直就是视频生成界的“劳斯莱斯”。现在,潞晨科技宣布开源视频生成模型 Open-Sora2.0!仅仅花费了区区20万美元(相当于224张 GPU 的投入),就成功训练出了一个拥有 110亿参数的商业级视频生成大模型。性能直追“OpenAI Sora ”别看 Open-Sora2.0成本不高,实力可一点都不含糊。它可是敢于叫板行业标杆 HunyuanVideo 和拥有300亿参数的 Step-Video 的狠角色。在权威评测 VBench 和用户偏好测试中,Open-Sora2.0的表现都令人刮目相看,多项关键指

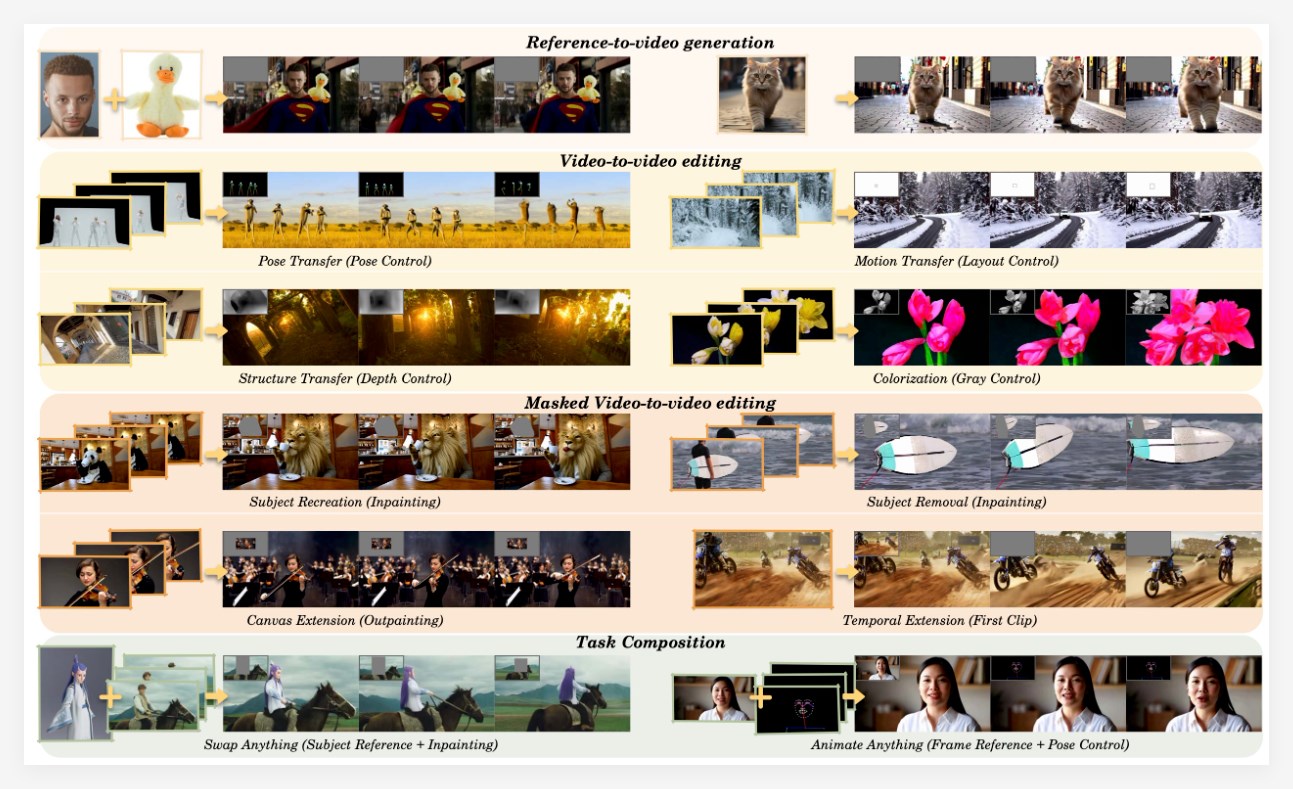

是否还在感叹视频制作门槛高,后期编辑太烧脑?别担心,阿里通义Wan团队再次出手,推出了他们最新的重量级模型All-in-One视频生成和编辑模型——VACE。VACE最引人注目的能力之一,便是其强大的按条件生成视频功能。这意味着,你只需要用文字描绘出心中的场景,VACE就能迅速将你的想象变为现实。这如同拥有了一支听你指挥的梦幻摄制组,效率之高令人惊叹!VACE支持多种灵活高效的编辑方式,包括:物体运动轨迹任你掌控。借助 Move-Anything 功能,你可以精确控制视频中任何物体的运动轨迹

近日,魔乐社区(Modelers)正式上线了由阶跃星辰研发的 Step-Video 和 Step-Audio 两款开源多模态大模型。这两款模型分别用于视频生成和语音交互,旨在为开发者和企业用户提供更强大的 AI 工具。Step-Video 模型的全名为 Step-Video-T2V,这是一款参数量高达300亿的全球最大开源视频生成模型。该模型能够直接生成204帧、540P 分辨率的高质量视频,并在指令遵循、运动平滑性、物理合理性以及美感等方面,表现超越了市场上现有的顶尖开源视频模型。另一方面,Step-Audio 则是业内首款能够生成多种情

2025年3月5日,Lightricks团队推出了备受期待的LTX-Video0.9.5版本,这一基于DiT(Diffusion Transformer)的开源AI视频生成模型。作为全球首款实时高质量视频生成模型的最新迭代,LTX-Video0.9.5以其强大的功能更新和开放的商用许可,为技术爱好者、开发者和商业用户带来了全新体验。Lightricks官方账号在当天上午宣布,新版本不仅提升了生成质量,还新增了多项实用特性,标志着开源AI视频创作迈向新高度。据官方推文介绍,LTX-Video0.9.5的最大亮点之一是支持商用许可,这意味着企业和个人开发者可以

近日,DeepBeepMeep 团队在 GitHub 上发布了 Wan2.1GP,一个针对低端 GPU 用户优化的视频生成模型。该模型基于阿里巴巴的 Wan2.1,旨在为缺乏高性能 GPU 资源的用户提供强大的视频生成能力。Wan2.1GP 的推出标志着视频生成技术的一个重要进步,尤其是在开放源代码领域。图源备注:图片由AI生成,图片授权服务商MidjourneyWan2.1GP 的主要特点包括其优异的性能和广泛的适用性。该模型在多个基准测试中持续超越现有的开源模型和一些商业解决方案,展现出强大的竞争力。此外,T2V-1.3B 模型仅需8.19GB 的

OpenAI 该公司宣布,其视频生成模型 Sora 现已正式在欧洲地区上线。这意味着,包括欧盟、英国、瑞士、挪威、列支敦士登以及冰岛的用户,现在都能享受到这一创新科技带来的便利。Sora 模型的首次亮相是在2024年2月。经过几个月的测试和优化,该模型于2024年12月向 ChatGPT Plus 和 Pro 用户开放,但遗憾的是,最初并未覆盖到欧洲市场。如今,随着政策和技术的成熟,OpenAI 终于能够在这些地区推出 Sora,使更多用户能够体验到视频生成的乐趣。用户只需是 ChatGPT Plus 或 Pro 的订阅者,就可以轻松

OpenAI 宣布其视频生成模型 Sora 现已正式在欧洲市场推出,覆盖包括欧盟、英国、瑞士、挪威、列支敦士登和冰岛在内的多个国家。这一消息让众多用户期待已久的 Sora 终于能够在这些地区的 ChatGPT Plus 和 Pro 订阅用户中使用。Sora 模型最早于2024年2月亮相,在2024年12月,OpenAI 对 ChatGPT Plus 和 Pro 用户开放了这一功能,但由于地区限制,欧洲用户当时未能使用。这一次,Sora 的上线标志着 OpenAI 在全球扩展其 AI 技术的又一重要一步,进一步推动了视频生成技术的普及。在当前数字内容消费日益增