如何选择Stable Diffusion采样器?科普Stable Diffusion采样器工作指南

站长之家

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

AMD 在 AI 领域的进展值得关注,尤其是其最新发布的针对 Stable Diffusion 模型的优化。近日,Stability AI 推出了基于 ONNX 框架优化的 Stable Diffusion 版本,这意味着 AMD 的 Radeon 显卡和锐龙集显在运行 AI 任务时性能提升显著,最高可达3.8倍。这一进展不仅缩小了与 NVIDIA 在生态系统优化方面的差距,也为 AMD 用户带来了实实在在的好处。过去一年,AMD 与多个合作伙伴,包括操作系统供应商(OSV)、原始设备制造商(OEM)和独立软件开发商(ISV),在硬件设计、驱动程序、编译器和机器学习模型等方面紧

近日,开发者 scraed 在 GitHub 上发布了 LanPaint,一个无需额外训练的图像修复工具。该工具旨在帮助用户在任何稳定扩散模型(SD)上实现高质量的图像修复效果,甚至包括用户自己训练的自定义模型。LanPaint 通过多次迭代让模型在去噪之前 “思考”,从而获得更为无缝和准确的修复结果。LanPaint 的主要特点之一是零训练修复。用户可以立即在任何 SD 模型上使用该工具,无需进行繁琐的训练过程。此外,LanPaint 的集成十分简单,用户可以像使用标准的 ComfyUI KSampler 一样进行操作,流畅的工

Stability AI因其Stable Diffusion文本生成图像模型而闻名。最近,该公司与全球半导体巨头 Arm 展开合作,致力于将生成音频人工智能能力引入移动设备。这一合作使得Stable Audio Open模型能够完全在 Arm CPU 上运行,用户可以在设备上快速生成音效、音频样本和制作元素,且无需互联网连接。Stability AI表示,随着生成性人工智能在企业和专业创作者中的应用越来越广泛,确保我们的模型和工作流程在各个创造领域都能便捷使用显得尤为重要。这不仅能够提升创作效率,也有助于将这些技术无缝整合

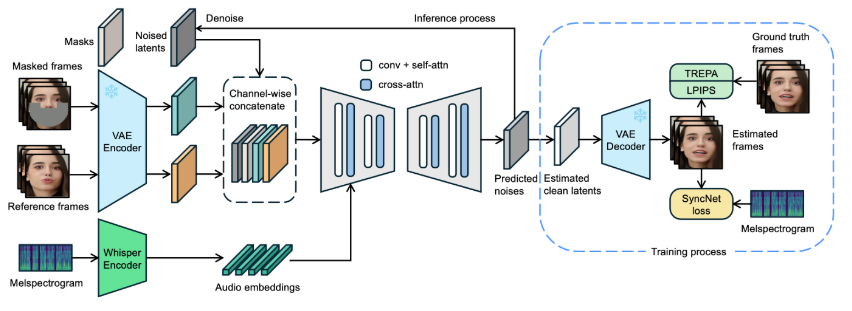

近日,字节跳动发布了名为 LatentSync 的新型口型同步框架,旨在利用音频条件潜在扩散模型实现更精确的口型同步。该框架基于Stable Diffusion,针对时间一致性做了优化。与以往的基于像素空间扩散或两阶段生成的方法不同,LatentSync 采用端到端的方式,无需中间运动表示,能够直接建模复杂的音频与视觉之间的关系。在 LatentSync 的框架中,首先使用 Whisper 将音频频谱图转换为音频嵌入,并通过交叉注意力层将其集成到 U-Net 模型中。框架通过将参考帧和掩码帧与噪声潜在变量进行通道级拼接

字节跳动近日开源了一项名为 LatentSync 的创新技术,该技术是一种基于音频条件的潜在扩散模型的端到端唇同步框架。这项技术无需任何中间运动表示,即可实现视频中人物唇部动作与音频的精准同步。与以往基于像素空间扩散或两阶段生成的唇同步方法不同,LatentSync 直接利用了 Stable Diffusion 的强大功能,能更有效地建模复杂的视听关联。研究发现,基于扩散的唇同步方法在时间一致性方面表现不佳,因为不同帧之间的扩散过程存在不一致性。为了解决这个问题,LatentSync 引入了时间表示

在近日的 AWS re:Invent 大会上,Stable Diffusion3.5 Large(SD3.5Large)宣布正式在亚马逊 Bedrock 平台上可用。作为 AWS 的完全托管平台,Bedrock 旨在为开发者提供构建和扩展生成式人工智能应用的基础模型。通过将 SD3.5Large 引入亚马逊 Bedrock,Stability AI 希望满足开发者在可信的 AWS 环境中进行工作和部署的需求,从而使初创企业和大型企业能够安全、便捷地使用这一先进模型,而无需担心额外的基础设施问题。Stable Diffusion3.5 Large在文本到图像生成方面表现卓越,具有多种关键能力。首先,它支持多样

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。新鲜AI产品点击了解:https://top.aibase.com/1、震撼来袭!公司通过融资和技术创新,尤其是超级计算机的建设,进一步巩固了其在行业中的地位。

Stability AI 正式发布了新版 Stable Diffusion3.5 Large,并新增了三种 ControlNet 功能,分别是Blur、Canny和Depth。这一更新为用户提供了更强大的图像生成能力,使得生成的图像更加丰富和多样化。根据 Stability AI 的介绍,这一模型的发布是基于其社区许可协议,允许用户在不商业化的前提下免费使用。无论是个人还是机构,都可以在科学研究等领域使用该模型,而无需支付费用。此外,对于年收入低于100万美元的小型企业和创作者,Stability AI 也允许其在商业用途上免费使用该模型。这种宽松的使用

Stability AI近日推出了其最新的深度学习文本到图像生成模型 ——Stable Diffusion3.5。这一版本包括三种改进的开源模型,旨在满足不同用户的需求,包括研究人员、企业客户和爱好者。其中,Stable Diffusion3.5Large 是整个系列中最强大的模型,参数高达81亿。该模型以其卓越的图像质量和对提示的高度响应能力,成为专业用户的理想选择,能够生成分辨率达到1兆像素的高质量图像。此外,Stable Diffusion3.5Large Turbo 是 Stable Diffusion3.5Large 的简化版。它在生成高质量图像的同时,极大地提升了速度,仅

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。新鲜AI产品点击了解:https://top.aibase.com/1、免费开放商用!这款助手基于Anthropic的Claude3.5Sonnet模型,能够自动处理代码重构和文档生成,提升开发者工作效率。