Após a Meta anunciar o lançamento de seu poderoso modelo de código aberto Llama 3.1 ontem, a Mistral AI lançou, na madrugada de hoje, seu modelo principal, o Mistral Large 2. Este novo produto possui 123 bilhões de parâmetros e uma enorme janela de contexto de 128k, rivalizando com o Llama 3.1 nesse aspecto.

Detalhes do Modelo Mistral Large 2

O Mistral Large 2 possui uma janela de contexto de 128k, suporta dezenas de idiomas, incluindo francês, alemão, espanhol, italiano, português, árabe, hindi, russo, chinês, japonês e coreano, além de mais de 80 linguagens de programação, como Python, Java, C, C++, JavaScript e Bash.

O Mistral Large 2 foi projetado para inferência de nó único, voltado principalmente para aplicações de contexto longo. Seus 123 bilhões de parâmetros permitem que ele opere com alta taxa de transferência em um único nó. O Mistral Large 2 é lançado sob a licença de pesquisa Mistral, destinada a uso em pesquisa e não comercial; para uso comercial, é necessário entrar em contato para obter uma licença comercial.

Desempenho Geral:

Em termos de desempenho, o Mistral Large 2 estabeleceu novos padrões em métricas de avaliação, alcançando uma precisão de 84,0% no benchmark MMLU, demonstrando um excelente equilíbrio entre desempenho e custo.

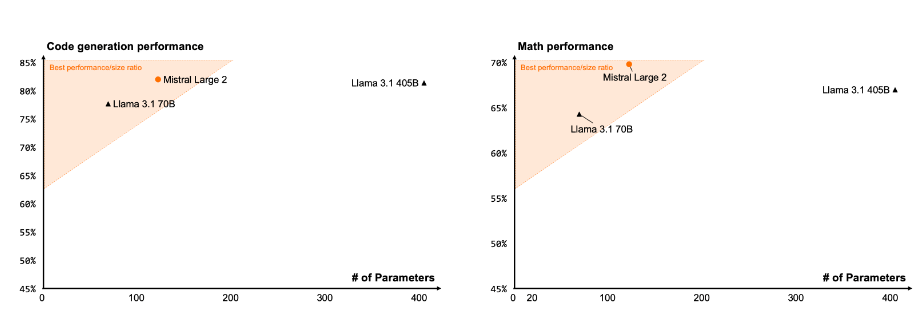

Código e Inferência

Com base na experiência de treinamento do Codestral 22B e Codestral Mamba, o Mistral Large 2 apresenta desempenho excepcional no processamento de código, chegando a rivalizar com modelos de ponta como GPT-4o, Claude 3 Opus e Llama 3405B.

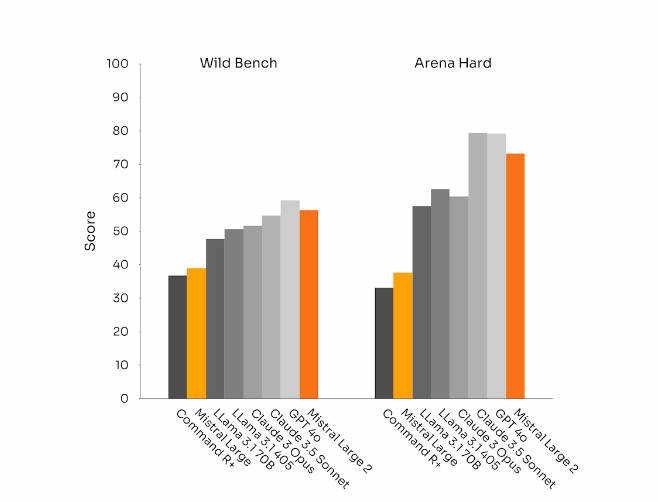

Obediência a Instruções e Alinhamento

O Mistral Large 2 também obteve avanços significativos na obediência a instruções e na capacidade de diálogo, sendo particularmente mais ágil no tratamento de diálogos complexos e multiturnos. Em alguns benchmarks, respostas mais longas tendem a melhorar as pontuações. No entanto, em muitos aplicativos comerciais, a concisão é crucial – respostas mais curtas aceleram as interações e tornam a inferência mais econômica.

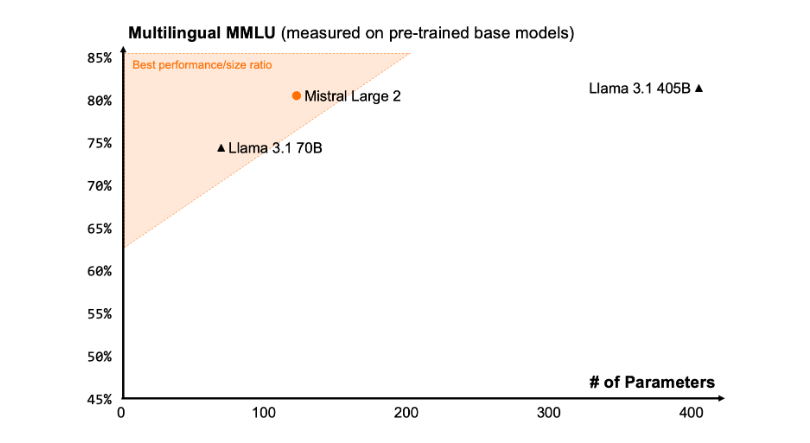

Diversidade de Idiomas

O novo Mistral Large 2 foi treinado em um grande conjunto de dados multilíngues, apresentando desempenho excepcional em inglês, francês, alemão, espanhol, italiano, português, holandês, russo, chinês, japonês, coreano, árabe e hindi. Segue os resultados de desempenho do Mistral Large 2 no benchmark MMLU multilíngue, comparado com os modelos Mistral Large anterior, Llama 3.1 e o Command R+ da Cohere.

Uso de Ferramentas e Chamadas de Funções

O Mistral Large 2 possui habilidades aprimoradas de chamada de funções e recuperação, sendo treinado para executar chamadas de funções paralelas e sequenciais com maestria, permitindo que atue como motor de aplicativos comerciais complexos.

Como Usar:

Atualmente, os usuários podem acessar o Mistral Large 2 na La Plateforme (https://console.mistral.ai/), com o nome mistral-large-2407, e testá-lo no Chat. Ele está disponível na versão 24.07 (nosso sistema de controle de versão YY.MM aplicado a todos os modelos) e com o nome da API mistral-large-2407. Os pesos do modelo instruct estão disponíveis e também hospedados no HuggingFace (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407).

Na La Plateforme, os produtos incluem dois modelos de uso geral, Mistral Nemo e Mistral Large, e dois modelos especializados, Codestral e Embed. Enquanto gradualmente desativamos os modelos antigos na La Plateforme, todos os modelos Apache (Mistral 7B, Mixtral 8x7B e 8x22B, Codestral Mamba, Mathstral) ainda podem ser implantados e ajustados finos usando o SDK mistral-inference e mistral-finetune.

A partir de hoje, a funcionalidade de ajuste fino será expandida na La Plateforme: essas funcionalidades agora estão disponíveis para Mistral Large, Mistral Nemo e Codestral.

A Mistral AI também está colaborando com vários provedores de serviços em nuvem líderes para tornar o Mistral Large 2 disponível globalmente, sendo encontrado, em particular, no Vertex AI do Google Cloud Platform.

Destaques:

🌟 O Mistral Large 2 possui uma janela de contexto de 128k, suporta até dez idiomas e mais de 80 linguagens de programação.

📈 Alcança 84,0% de precisão no benchmark MMLU, com excelente desempenho e custo-benefício.

💻 Os usuários podem acessar o novo modelo através da La Plateforme e utilizá-lo amplamente em plataformas de serviços em nuvem.