Recentemente, uma equipe de pesquisa da NVIDIA, em colaboração com o Georgia Tech, UMD e HKPU, lançou um novo modelo de linguagem visual — o NVEagle. Ele consegue entender imagens e conversar com você, funcionando como um superassistente que vê e fala.

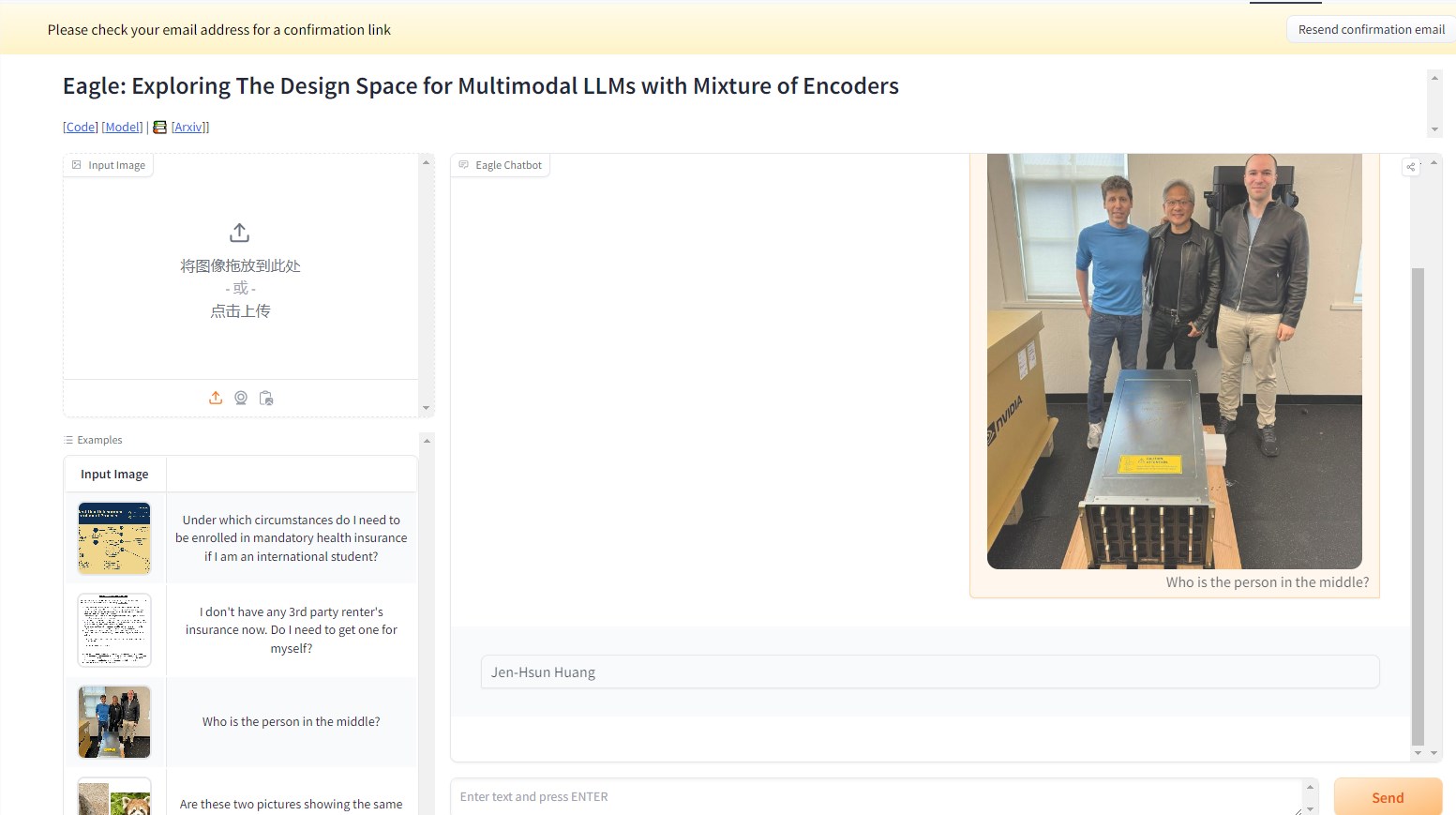

Por exemplo, na imagem abaixo, ao perguntar ao modelo NVEagle quem é a pessoa na foto, ele consegue interpretar a imagem e responder corretamente: Jensen Huang. A precisão é notável.

Este grande modelo de linguagem multimodal (MLLM) representa um avanço significativo na combinação de informações visuais e linguísticas. O NVEagle consegue entender cenários complexos da realidade e responder melhor por meio de entrada visual. Seu design centraliza na conversão de imagens em marcadores visuais, combinados com embeddings de texto, melhorando assim a compreensão de informações visuais.

No entanto, construir um modelo tão poderoso apresenta vários desafios, especialmente no que diz respeito à melhoria da capacidade de percepção visual. Estudos mostram que muitos modelos existentes, ao processar imagens de alta resolução, apresentam o fenômeno de "alucinação", ou seja, geram saídas imprecisas ou sem sentido. Isso é particularmente evidente em tarefas que exigem análise detalhada, como reconhecimento óptico de caracteres (OCR) e compreensão de documentos. Para superar essas dificuldades, a equipe de pesquisa explorou diversos métodos, incluindo testes com diferentes codificadores visuais e estratégias de fusão.

O lançamento do NVEagle é o resultado dessa pesquisa, incluindo três versões: Eagle-X5-7B, Eagle-X5-13B e Eagle-X5-13B-Chat. As versões 7B e 13B são usadas principalmente para tarefas gerais de linguagem visual, enquanto a versão 13B-Chat foi especialmente ajustada para IA conversacional, permitindo melhor interação com base em entrada visual.

Um destaque do NVEagle é o uso do mecanismo de especialista misto (MoE), que permite selecionar dinamicamente o codificador visual mais adequado para diferentes tarefas, melhorando significativamente o processamento de informações visuais complexas. O modelo já foi lançado no Hugging Face, facilitando o acesso para pesquisadores e desenvolvedores.

Em vários testes de referência, o modelo Eagle apresentou desempenho excepcional. Por exemplo, na tarefa de OCR, o modelo Eagle obteve uma pontuação média de 85,9 no OCRBench, superando outros modelos líderes, como InternVL e LLaVA-HR. No teste TextVQA, sua pontuação atingiu 88,8, mostrando bom desempenho em tarefas complexas de perguntas e respostas visuais, com uma pontuação de 65,7 no teste GQA. Além disso, o desempenho continua a melhorar com a adição de especialistas visuais adicionais.

A série de modelos NVEagle, por meio de exploração e otimização de design sistemáticas, resolveu com sucesso vários desafios importantes na percepção visual, abrindo novos caminhos para o desenvolvimento de modelos de linguagem visual.

Acesso ao projeto: https://top.aibase.com/tool/eagle

Demo: https://huggingface.co/spaces/NVEagle/Eagle-X5-13B-Chat

Destaques:

🌟 O NVEagle é um modelo de linguagem visual de nova geração da NVIDIA, projetado para melhorar a compreensão de informações visuais complexas.

📈 O modelo inclui três versões, adequadas para diferentes tarefas, sendo a versão 13B-Chat focada em IA conversacional.

🏆 Em vários testes de referência, o modelo Eagle superou muitos modelos líderes existentes, demonstrando desempenho excepcional.