Na área de IA de código aberto, a lacuna em relação às grandes empresas de tecnologia não se limita apenas à capacidade computacional. O AI2 (anteriormente Allen Institute for Artificial Intelligence) está reduzindo essa lacuna por meio de uma série de iniciativas inovadoras. Seu mais recente lançamento, o esquema de treinamento posterior Tülu3, torna a transformação de modelos de linguagem grandes "brutos" em sistemas de IA práticos acessível a todos.

Ao contrário da crença popular, os modelos de linguagem básicos não podem ser usados diretamente após o pré-treinamento. Na verdade, o processo de treinamento posterior é o fator crucial que determina o valor final do modelo. É nessa etapa que o modelo se transforma de uma rede "onipresente" mas sem discernimento em uma ferramenta prática com uma função específica.

Por muito tempo, as grandes empresas mantiveram seus esquemas de treinamento posterior em segredo. Embora qualquer pessoa possa construir modelos usando as tecnologias mais recentes, fazer com que um modelo funcione em um domínio específico (como aconselhamento psicológico ou análise de pesquisa) requer técnicas de treinamento posterior exclusivas. Mesmo projetos como o Llama do Meta, que se apresentam como "código aberto", mantêm em sigilo estrito a origem do modelo original e os métodos de treinamento gerais.

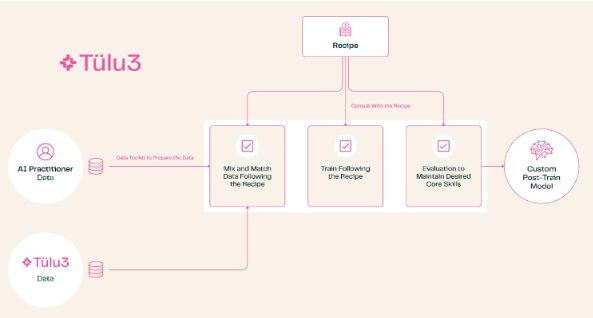

O surgimento do Tülu3 mudou essa situação. Este esquema completo de treinamento posterior abrange todo o processo, desde a seleção de tópicos e governança de dados até o aprendizado por reforço e ajuste fino. Os usuários podem ajustar as capacidades do modelo de acordo com suas necessidades, como fortalecer as habilidades de matemática e programação ou reduzir a prioridade do processamento multilíngue.

Os testes do AI2 mostraram que o desempenho dos modelos treinados com o Tülu3 atingiu o nível dos melhores modelos de código aberto. Essa inovação é significativa: ela oferece às empresas uma opção totalmente autônoma e controlável. Em particular, para instituições que lidam com dados sensíveis, como pesquisa médica, não é mais necessário depender de APIs de terceiros ou serviços personalizados. O treinamento completo pode ser realizado localmente, reduzindo custos e protegendo a privacidade.

O AI2 não apenas lançou este esquema, mas também o utilizou em seus próprios produtos. Embora os resultados atuais dos testes sejam baseados no modelo Llama, eles planejam lançar um novo modelo baseado em seu próprio OLMo e treinado com o Tülu3, o que representará uma solução verdadeiramente de código aberto do início ao fim.

Essa abertura tecnológica demonstra não apenas a determinação do AI2 em promover a democratização da IA, mas também injeta um impulso no coração da comunidade de IA de código aberto. Isso nos aproxima de um ecossistema de IA verdadeiramente aberto e transparente.