Nos últimos anos, a demanda por modelos de aprendizado de máquina em tarefas de visão e linguagem tem crescido exponencialmente. No entanto, a maioria desses modelos requer recursos computacionais significativos, tornando-os ineficientes para execução em dispositivos pessoais. Dispositivos menores, como laptops, GPUs de consumo e dispositivos móveis, enfrentam desafios consideráveis ao lidar com tarefas de visão e linguagem.

O Qwen2-VL, por exemplo, apesar de seu desempenho excepcional, exige hardware de alto nível, limitando sua usabilidade em aplicações em tempo real. Portanto, o desenvolvimento de modelos leves, capazes de funcionar com recursos limitados, tornou-se uma necessidade crucial.

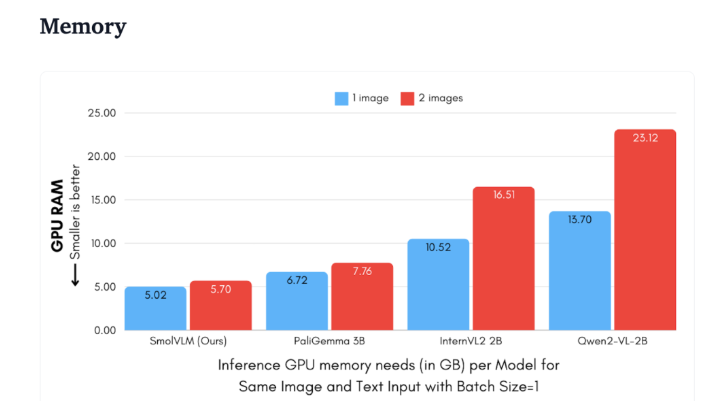

Recentemente, o Hugging Face lançou o SmolVLM, um modelo de linguagem visual de 2B parâmetros projetado especificamente para inferência em dispositivos. O SmolVLM supera outros modelos semelhantes em termos de uso de memória da GPU e velocidade de geração de tokens. Sua principal característica é a capacidade de funcionar eficientemente em dispositivos menores, como laptops ou GPUs de consumo, sem comprometer o desempenho. O SmolVLM encontrou um equilíbrio ideal entre desempenho e eficiência, resolvendo um problema que modelos anteriores enfrentavam.

Em comparação com o Qwen2-VL 2B, o SmolVLM é de 7,5 a 16 vezes mais rápido na geração de tokens, graças à sua arquitetura otimizada, permitindo inferência leve. Essa eficiência não apenas beneficia o usuário final, mas também melhora significativamente a experiência do usuário.

Do ponto de vista técnico, o SmolVLM possui uma arquitetura otimizada que suporta inferência eficiente em dispositivos. Os usuários podem até mesmo realizar ajustes finos facilmente no Google Colab, reduzindo significativamente a barreira para experimentação e desenvolvimento.

Devido ao baixo consumo de memória, o SmolVLM consegue rodar em dispositivos que antes não suportavam modelos semelhantes. Em um teste com vídeos do YouTube de 50 frames, o SmolVLM apresentou um desempenho notável, alcançando uma pontuação de 27,14% e superando dois modelos mais exigentes em termos de recursos, demonstrando sua grande capacidade de adaptação e flexibilidade.

O SmolVLM representa um marco importante no campo dos modelos de linguagem visual. Seu lançamento permite que tarefas complexas de visão e linguagem sejam executadas em dispositivos cotidianos, preenchendo uma lacuna importante nas ferramentas de IA atuais.

O SmolVLM não apenas se destaca em velocidade e eficiência, mas também oferece aos desenvolvedores e pesquisadores uma ferramenta poderosa para processamento de linguagem visual, sem a necessidade de hardware de alto custo. Com a crescente popularização da IA, modelos como o SmolVLM tornarão as poderosas capacidades de aprendizado de máquina mais acessíveis.

demo:https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

Destaques:

🌟 O SmolVLM é um modelo de linguagem visual de 2B parâmetros lançado pelo Hugging Face, projetado para inferência em dispositivos, com execução eficiente e sem necessidade de hardware de ponta.

⚡ Sua velocidade de geração de tokens é de 7,5 a 16 vezes maior que a de modelos semelhantes, melhorando significativamente a experiência e a eficiência do usuário.

📊 Em testes, o SmolVLM demonstrou grande capacidade de adaptação, obtendo boa pontuação mesmo sem treinamento com dados de vídeo.