Apenas seis meses após o lançamento dos GB200 e B200, a Nvidia lançou novas GPUs: GB300 e B300. Embora pareça uma atualização menor, representa uma grande mudança, especialmente no aumento significativo do desempenho de modelos de inferência, o que terá um impacto profundo em toda a indústria.

B300/GB300: Um salto gigante no desempenho de inferência

A GPU B300 utiliza o nó de processo de 4 nm da TSMC, otimizado para chips de computação. Isso resulta em um aumento de 50% no desempenho de FLOPS da B300 em comparação com a B200. Parte dessa melhoria se deve ao aumento do TDP, com o GB300 e o B300HGX atingindo 1,4 kW e 1,2 kW, respectivamente (contra 1,2 kW e 1 kW dos GB200 e B200). O restante da melhoria de desempenho vem de aprimoramentos de arquitetura e otimizações de nível de sistema, como a alocação dinâmica de energia entre CPU e GPU.

Além do aumento de FLOPS, a memória foi atualizada para 12-Hi HBM3E, aumentando a capacidade de HBM de cada GPU para 288 GB. No entanto, a velocidade do pino permanece inalterada, mantendo a largura de banda de memória de cada GPU em 8 TB/s. É importante notar que a Samsung não faz parte da cadeia de suprimentos do GB200 ou GB300.

Além disso, a Nvidia ajustou os preços. Isso afetará a margem de lucro dos produtos Blackwell em certa medida, mas o mais importante é que a melhoria de desempenho do B300/GB300 se refletirá principalmente nos modelos de inferência.

Projetado para modelos de inferência

A melhoria da memória é crucial para o treinamento de inferência LLM no estilo OpenAI O3, pois sequências longas aumentam o KVCache, limitando assim o tamanho do lote crítico e a latência. A atualização do H100 para o H200 (principalmente o aumento da memória) trouxe duas melhorias:

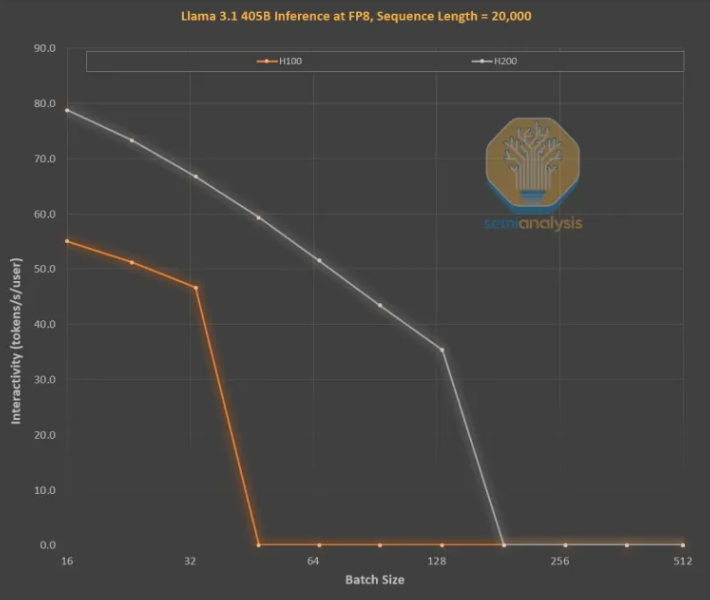

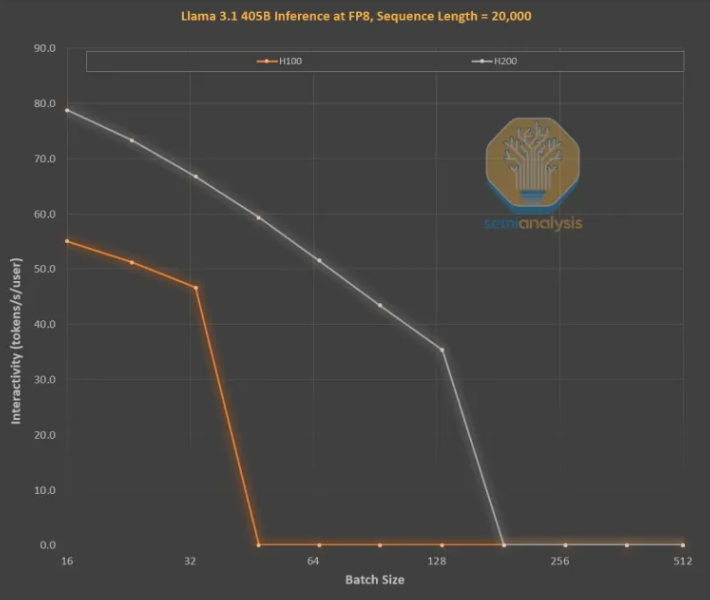

A maior largura de banda de memória (4,8 TB/s no H200, contra 3,35 TB/s no H100) resultou em um aumento geral de 43% na interatividade para todos os tamanhos de lote comparáveis.

Devido ao maior tamanho de lote executado pelo H200 em comparação com o H100, o número de tokens gerados por segundo aumentou três vezes, com uma redução de custo de aproximadamente três vezes. Essa diferença se deve principalmente à limitação do KVCache no tamanho total do lote.

A maior capacidade de memória contribui enormemente para a melhoria do desempenho. A diferença de desempenho e custo entre as duas GPUs é muito maior do que o indicado pelas suas especificações:

A experiência do usuário com modelos de inferência pode ser ruim devido ao tempo de espera perceptível entre solicitações e respostas. Acelerar significativamente o tempo de inferência aumentaria a vontade do usuário de usar e pagar pelo serviço.

A melhoria de três vezes no desempenho por meio de uma atualização de memória intermediária é surpreendente, superando a Lei de Moore, a Lei de Huang ou qualquer outra velocidade de melhoria de hardware que já vimos.

Os modelos mais poderosos podem cobrar um preço muito maior do que os modelos com desempenho ligeiramente inferior. Os modelos de ponta têm margens de lucro superiores a 70%, enquanto os modelos mais atrasados da concorrência de código aberto têm margens de lucro inferiores a 20%. Os modelos de inferência não precisam realizar apenas um raciocínio em cadeia. A funcionalidade de pesquisa pode ser expandida para melhorar o desempenho, como feito em O1Pro e O3. Isso permite que modelos mais inteligentes resolvam mais problemas e gerem mais receita para cada GPU.

Claro, a Nvidia não é a única empresa que pode aumentar a capacidade de memória. Os ASICs também podem fazer isso e, de fato, a AMD pode estar em uma posição melhor, pois a capacidade de memória de seus MI300X, MI325X e MI350X geralmente é maior do que a da Nvidia, com 192 GB, 256 GB e 288 GB, respectivamente. No entanto, a Nvidia possui uma arma secreta chamada NVLink.

A importância do NVL72 é que ele permite que 72 GPUs trabalhem juntas no mesmo problema, compartilhando memória com latência muito baixa. Nenhum outro acelerador no mundo possui capacidade de comutação totalmente interconectada.

O GB200NVL72 e o GB300NVL72 da Nvidia são cruciais para a realização de muitas funções essenciais:

Maior interatividade, reduzindo a latência de cada cadeia de raciocínio.

72 GPUs podem distribuir o KVCache, permitindo cadeias de raciocínio mais longas (aumentando a inteligência).

A escalabilidade do tamanho do lote é muito melhor do que em servidores típicos de 8 GPUs, reduzindo os custos.

Maior volume de amostra trabalhando no mesmo problema para melhorar a precisão e o desempenho do modelo.

Portanto, a tokenomics do NVL72 aumentou mais de 10 vezes, especialmente em cadeias de inferência longas. A utilização de memória do KVCache é prejudicial à rentabilidade, mas o NVL72 é a única maneira de estender o comprimento da inferência para mais de 100.000 tokens.

GB300: Remodelação da cadeia de suprimentos

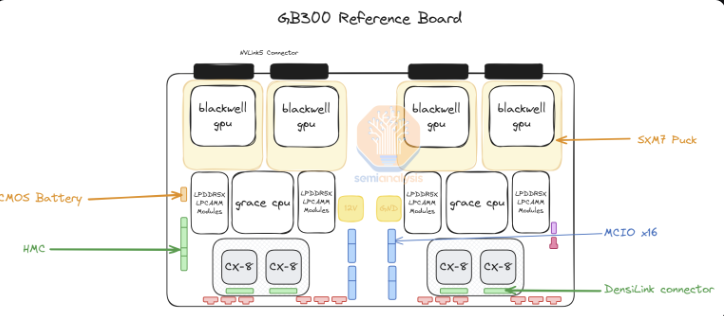

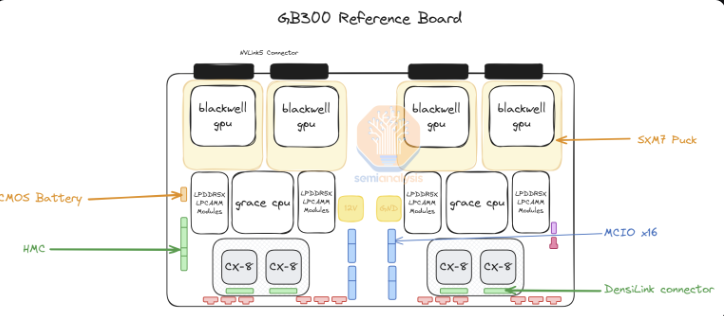

Para o GB300, a Nvidia fez grandes mudanças na cadeia de suprimentos e no conteúdo fornecido. Para o GB200, a Nvidia fornecia toda a placa Bianca (incluindo GPU Blackwell, CPU Grace, 512 GB LPDDR5X, conteúdo VRM), além da bandeja de comutação e placa traseira de cobre.

Para o GB300, a Nvidia fornece apenas o módulo B300 no "SXM Puck", a CPU Grace em encapsulamento BGA e o HMC, que virá da startup americana Axiado, em vez da Aspeed do GB200. Os clientes finais agora comprarão diretamente os componentes restantes na placa de computação, e a memória de segunda camada utilizará módulos LPCAMM, em vez de LPDDR5X soldado. A Micron será o principal fornecedor desses módulos. A bandeja de comutação e a placa traseira de cobre permanecem inalteradas, sendo totalmente fornecidas pela Nvidia.

A mudança para o SXM Puck abre oportunidades para mais OEMs e ODMs participarem da placa de computação. Antes, apenas a Wistron e a Foxconn podiam fabricar placas de computação Bianca, mas agora mais OEMs e ODMs podem participar. A Wistron é a maior perdedora no formato ODM, pois perdeu participação na placa Bianca. Para a Foxconn, a perda de participação na placa Bianca é compensada pelo fato de ser a única fabricante dos SXM Puck e de seus slots. A Nvidia está tentando introduzir outros fornecedores para os Pucks e slots, mas ainda não fez nenhuma outra encomenda.

Outra grande mudança é o conteúdo VRM. Embora haja algum conteúdo VRM no SXM Puck, a maior parte do conteúdo VRM embarcado será adquirida diretamente pelos hiperescalares/OEMs de fornecedores de VRM. Devido à mudança no modelo de negócios, a Monolithic Power Systems perderá participação de mercado.

A Nvidia também oferece o ConnectX-8 NIC de 800G na plataforma GB300, fornecendo o dobro da largura de banda de expansão em InfiniBand e Ethernet. A Nvidia havia anteriormente cancelado o ConnectX-8 do GB200 devido à complexidade do tempo de lançamento e à renúncia de habilitar o PCIe Gen6 na placa Bianca.

O ConnectX-8 apresenta melhorias significativas em comparação com o ConnectX-7. Ele não apenas possui o dobro da largura de banda, mas também possui 48 canais PCIe, em vez de 32, permitindo arquiteturas exclusivas, como o MGX B300A resfriado a ar. Além disso, o ConnectX-8 possui capacidade SpectrumX, enquanto nos produtos 400G anteriores, o SpectrumX exigia uma Bluefield 3DPU menos eficiente.

Impacto do GB300 em hiperescalares

O impacto da latência do GB200 e GB300 nos hiperescalares significa que muitos pedidos a partir do terceiro trimestre serão transferidos para as novas GPUs mais caras da Nvidia. Até a semana passada, todos os hiperescalares decidiram adotar o GB300. Isso se deve em parte ao desempenho superior do GB300, mas também ao fato de poderem controlar seu próprio destino.

Devido aos desafios do tempo de lançamento e às grandes mudanças em racks, resfriamento e fontes de alimentação/densidade, os hiperescalares não permitiram muitas alterações no GB200 em nível de servidor. Isso fez com que o Meta abandonasse a esperança de NICs de múltiplas fontes da Broadcom e da Nvidia, passando a depender totalmente da Nvidia. Em outros casos, como o Google, eles abandonaram a NIC interna, passando a usar apenas a Nvidia.

Para organizações com milhares de pessoas acostumadas a otimizar todos os custos, da CPU à rede, parafusos e placas de metal, isso é simplesmente inacreditável.

O exemplo mais chocante é a Amazon, que escolheu uma configuração muito subótima, com um TCO pior do que o design de referência. Devido ao uso de switches PCIe e NICs de adaptadores de fibra óptica elástica de 200G menos eficientes, a Amazon precisava de resfriamento a ar, impossibilitando a implantação de racks NVL72 como Meta, Google, Microsoft, Oracle, X.AI e Coreweave. Devido à sua NIC interna, a Amazon teve que usar NVL36, com um custo maior por GPU devido ao maior conteúdo de backplane e switch. Em resumo, devido às suas restrições em torno da personalização, a configuração da Amazon não é ideal.

Com o GB300, os hiperescalares podem personalizar mais componentes, como placas-mãe e resfriamento. Isso permite que a Amazon construa sua própria placa-mãe personalizada, com resfriamento a água e integração de componentes anteriormente resfriados a ar, como o switch PCIe Astera Labs. Com mais componentes com resfriamento a água e, finalmente, o HVM no NIC K2V6400G no terceiro trimestre de 25, isso significa que a Amazon pode retornar à arquitetura NVL72 e melhorar significativamente seu TCO.

Embora os hiperescalares tenham que projetar, verificar e validar mais conteúdo, essa é a maior desvantagem. Isso pode facilmente se tornar a plataforma mais complexa que os hiperescalares já tiveram que projetar (exceto o sistema TPU do Google). Alguns hiperescalares serão capazes de projetar rapidamente, mas outros com equipes mais lentas ficarão para trás. Apesar dos relatórios de mercado sobre cancelamentos, acreditamos que a Microsoft é uma das mais lentas a implantar o GB300 devido à sua velocidade de projeto mais lenta, e ainda está comprando alguns GB200 no quarto trimestre.

A diferença no preço total pago pelos clientes é significativa, pois os componentes são extraídos da pilha de lucros da Nvidia e transferidos para a ODM. A receita da ODM é afetada e, o mais importante, a margem de lucro da Nvidia também mudará ao longo do ano.

Referência: https://semianalysis.com/2024/12/25/nvidias-christmas-present-gb300-b300-reasoning-inference-amazon-memory-supply-chain/