No mundo em rápida evolução da inteligência artificial, uma empresa chamada Etched está apostando tudo em uma arquitetura de IA chamada Transformer. A empresa anunciou recentemente o lançamento do Sohu, o primeiro circuito integrado específico para aplicação (ASIC) do mundo projetado especificamente para Transformers, alegando que seu desempenho supera em muito qualquer GPU atualmente disponível no mercado e que revolucionará o campo da IA.

A arquitetura Transformer domina o campo da IA

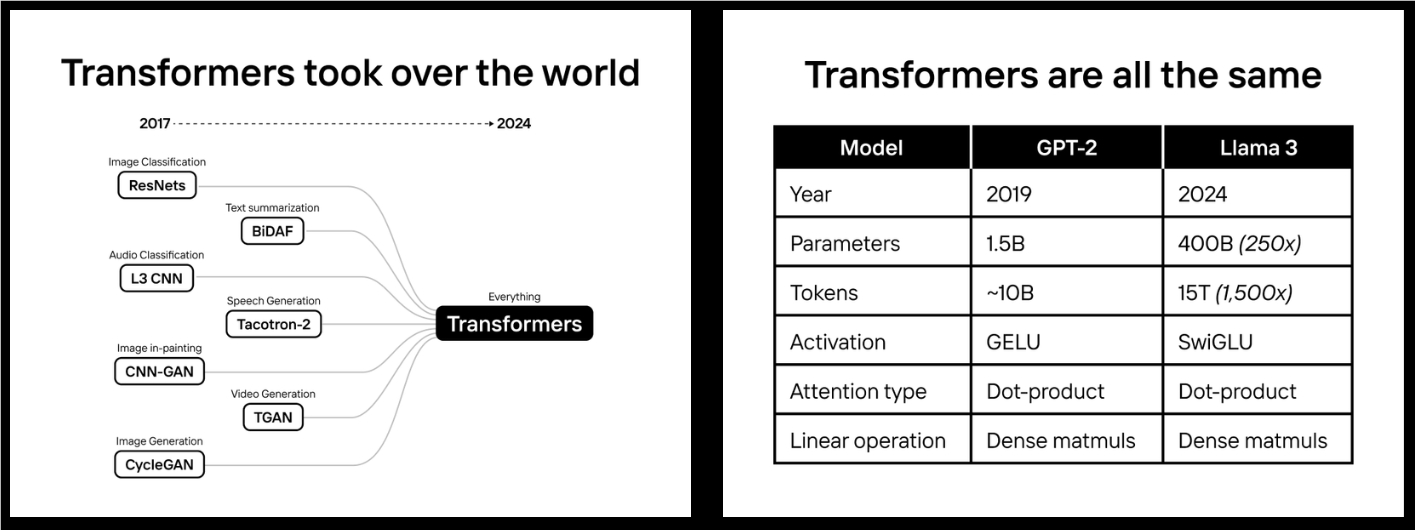

Em 2022, a Etched fez uma previsão ousada: a arquitetura Transformer dominaria o mundo da IA. Acontece que eles estavam certos. Hoje, de ChatGPT a Sora, de Gemini a Stable Diffusion 3, cada modelo de IA de ponta usa a arquitetura Transformer. Baseada nessa previsão, a Etched passou dois anos desenvolvendo o chip Sohu.

O chip Sohu alcança um aumento de desempenho sem precedentes ao gravar diretamente a arquitetura Transformer no hardware. Embora isso signifique que o Sohu não pode executar a maioria dos modelos de IA tradicionais, como o DLRM por trás dos anúncios do Instagram, o modelo de dobramento de proteínas AlphaFold2 ou o modelo de imagem anterior Stable Diffusion 2, para modelos Transformer, o Sohu é muito mais rápido do que qualquer outro chip.

Vantagem de desempenho significativa

De acordo com a Etched, um servidor com oito chips Sohu pode processar mais de 500.000 tokens por segundo ao executar o modelo Llama70B. Esse desempenho é uma ordem de magnitude mais rápido do que a próxima geração de GPUs Blackwell (B200) da Nvidia, e a um custo menor.

Especificamente, um servidor 8xSohu pode substituir 160 GPUs H100. Isso significa que o uso de chips Sohu pode reduzir significativamente o custo de operação de modelos de IA, ao mesmo tempo em que aumenta significativamente a velocidade de processamento.

A lógica por trás da aposta

A razão pela qual a Etched apostou tão fortemente na arquitetura Transformer é sua profunda compreensão das tendências de desenvolvimento da IA. A empresa acredita que a escalabilidade é a chave para alcançar a inteligência sobre-humana. Nos últimos cinco anos, os modelos de IA superaram os humanos na maioria dos testes padronizados, e isso se deve principalmente ao aumento significativo da capacidade computacional. Por exemplo, os recursos computacionais usados pela Meta para treinar o modelo Llama400B foram 50.000 vezes maiores do que os usados pela OpenAI para treinar o GPT-2.

No entanto, continuar a escalar enfrenta desafios significativos. O custo dos data centers de próxima geração pode exceder o PIB de um pequeno país. No ritmo atual de desenvolvimento, nosso hardware, redes elétricas e recursos financeiros não conseguem acompanhar. Essa é a oportunidade do chip Sohu.

A inevitabilidade dos chips especializados

A Etched acredita que, com a desaceleração da Lei de Moore, a única maneira de melhorar o desempenho é por meio da especialização. Antes da arquitetura Transformer dominar o campo da IA, muitas empresas estavam desenvolvendo chips de IA e GPUs flexíveis para lidar com uma variedade de arquiteturas diferentes. Mas agora, com a demanda de inferência Transformer no mercado crescendo de cerca de US$ 50 milhões para bilhões de dólares, juntamente com a convergência da arquitetura de modelos de IA, o surgimento de chips especializados tornou-se inevitável.

Quando o custo de treinamento de um modelo chega a US$ 1 bilhão e o custo de inferência ultrapassa US$ 10 bilhões, mesmo uma melhoria de 1% no desempenho justifica um projeto de chip personalizado de US$ 50 milhões a US$ 100 milhões. Na realidade, a vantagem de desempenho do ASIC é muito maior do que isso.

Como o chip Sohu funciona

O chip Sohu consegue atingir um desempenho tão alto porque é otimizado especificamente para a arquitetura Transformer. Ao remover a maior parte da lógica de fluxo de controle, o Sohu pode acomodar mais unidades de cálculo matemático. Isso resulta em uma taxa de utilização de FLOPS superior a 90% para o Sohu, enquanto a taxa de utilização ao executar TRT-LLM em uma GPU é de cerca de 30%.

A Etched explica que, como a maior parte da área de uma GPU é usada para garantir a capacidade de programação, um design específico para Transformer pode acomodar mais unidades de computação. Na verdade, dos 80 bilhões de transistores de uma GPU H100, apenas 3,3% são usados para multiplicação de matrizes. O Sohu, ao se concentrar no Transformer, pode acomodar mais FLOPS no chip sem reduzir a precisão ou usar técnicas de esparsidade.

.png)

Ecossistema de software

Embora o chip Sohu tenha alcançado um grande avanço no hardware, o ecossistema de software também é crucial. Em comparação com GPUs e TPUs, o desenvolvimento de software para o Sohu é relativamente simples, pois só precisa suportar a arquitetura Transformer. A Etched promete open-sourcear todo o software, de drivers a kernels e pilhas de serviços, o que facilitará muito o uso e a otimização do chip Sohu pelos desenvolvedores.

Perspectivas futuras

Se a aposta da Etched for bem-sucedida, o chip Sohu mudará completamente o cenário da indústria de IA. Atualmente, muitos aplicativos de IA enfrentam gargalos de desempenho. Por exemplo, o Gemini leva mais de 60 segundos para responder a uma pergunta sobre um vídeo, os agentes de codificação são mais caros do que os engenheiros de software e levam horas para concluir tarefas, e os modelos de vídeo só conseguem gerar um quadro por segundo.

O chip Sohu tem o potencial de aumentar a velocidade dos modelos de IA em 20 vezes, ao mesmo tempo em que reduz significativamente os custos. Isso significa que aplicativos como geração de vídeo em tempo real, chamadas, agentes inteligentes e pesquisa se tornarão possíveis. A Etched já começou a aceitar inscrições de usuários iniciais para o serviço em nuvem para desenvolvedores Sohu e está ativamente recrutando pessoas para se juntarem à sua equipe.

Os avanços na capacidade computacional de IA podem ter um impacto profundo, e o chip Sohu da Etched certamente merece nossa atenção. À medida que mais detalhes forem divulgados e os aplicativos reais forem implementados, poderemos avaliar melhor o potencial dessa tecnologia e seu impacto no campo da IA.