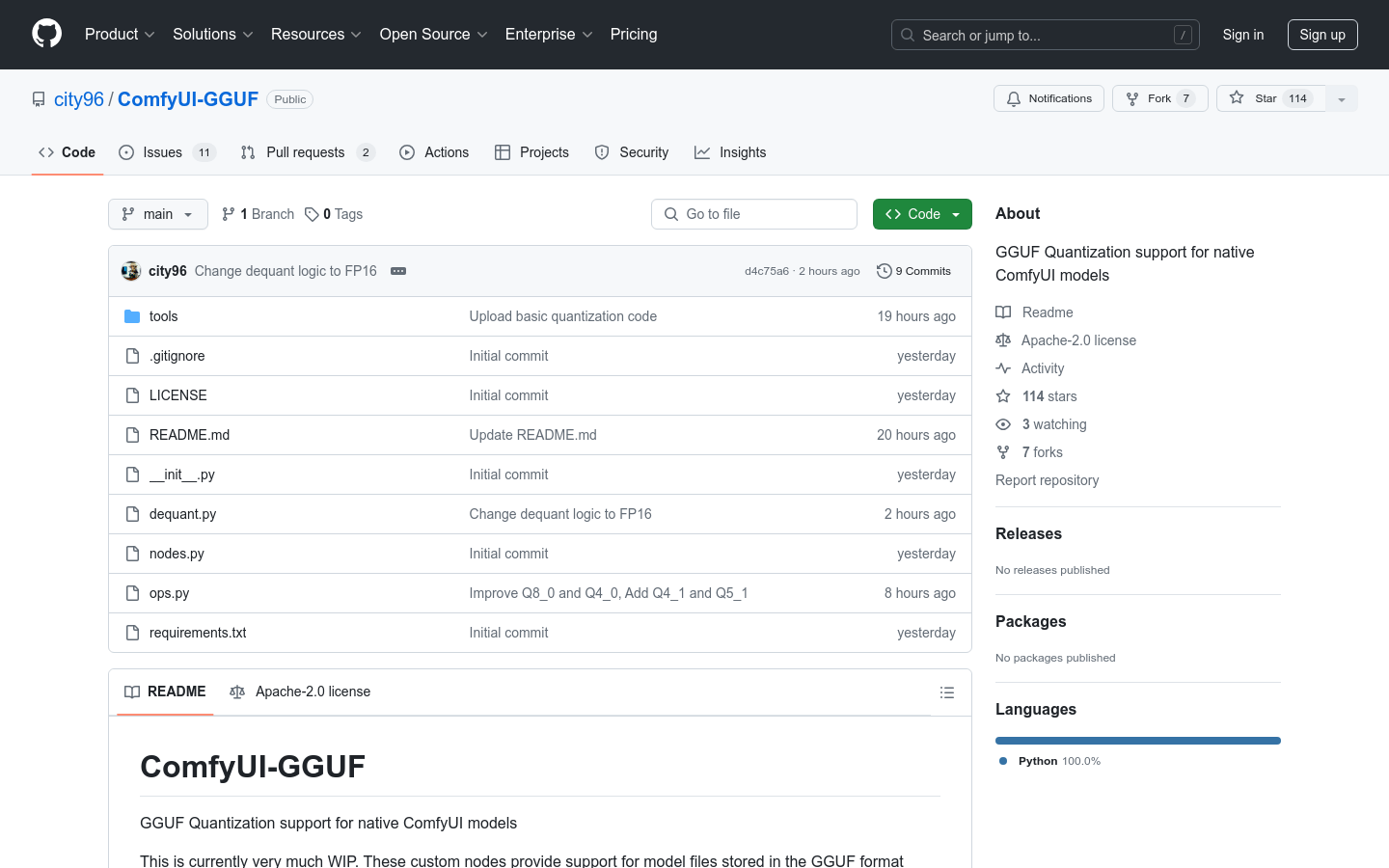

ComfyUI-GGUF

Suporte à quantização GGUF, otimizando o desempenho de modelos nativos do ComfyUI

Produto ComumProgramaçãoGGUFQuantização

O ComfyUI-GGUF é um projeto que fornece suporte à quantização GGUF para modelos nativos do ComfyUI. Ele permite que arquivos de modelos sejam armazenados no formato GGUF, popularizado pelo llama.cpp. Embora modelos UNET convencionais (conv2d) não sejam adequados para quantização, modelos transformer/DiT como o flux parecem ser menos afetados. Isso permite sua execução em GPUs de baixo custo com uma taxa de bits menor por variável de peso.

ComfyUI-GGUF Situação do Tráfego Mais Recente

Total de Visitas Mensais

474564576

Taxa de Rejeição

36.20%

Média de Páginas por Visita

6.1

Duração Média da Visita

00:06:34