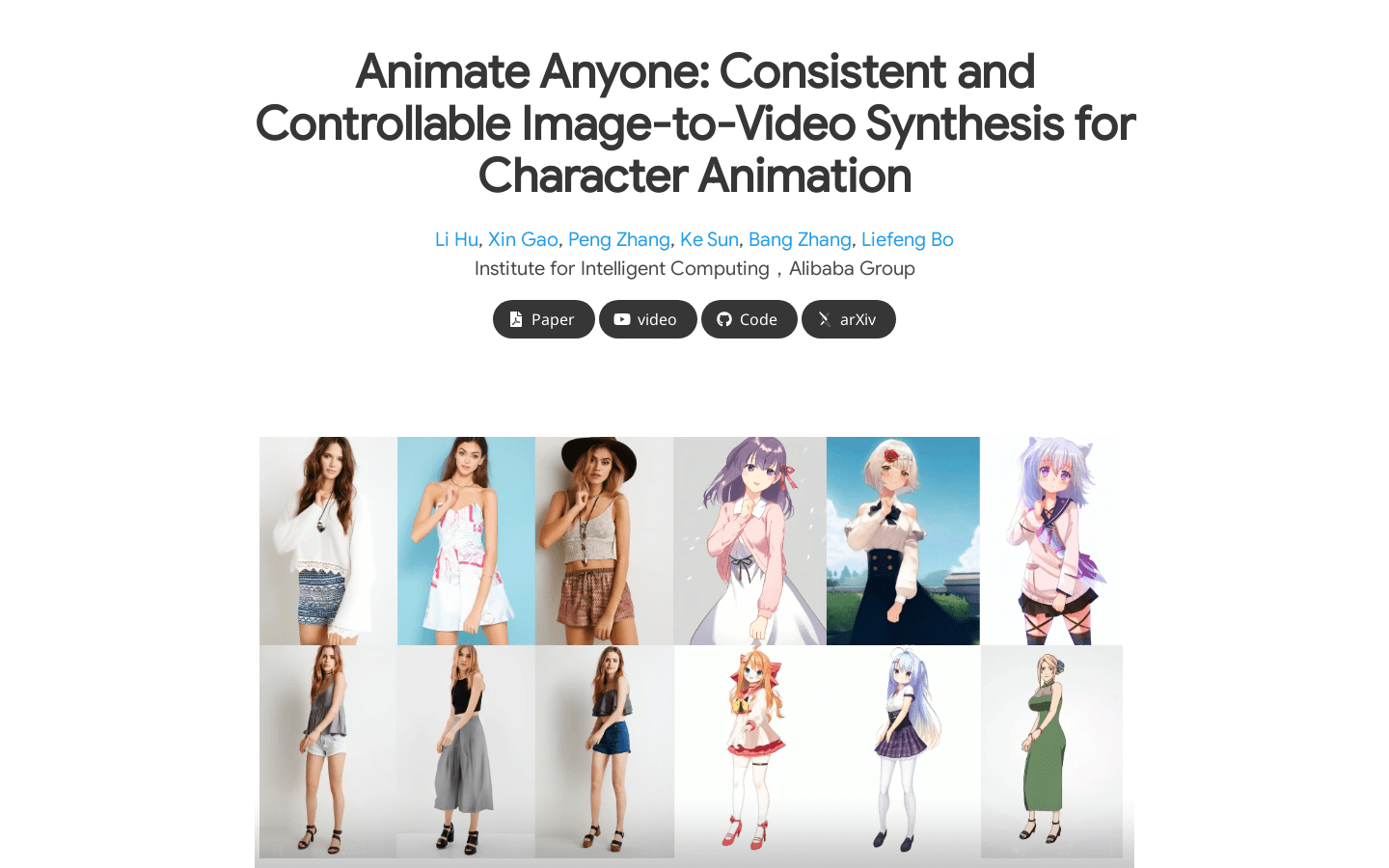

Animer n'importe qui

Synthèse d'images à vidéos d'animation de personnages cohérente et contrôlable

Animer n'importe qui Dernière situation du trafic

Nombre total de visites mensuelles

142573

Taux de rebond

44.23%

Nombre moyen de pages par visite

1.8

Durée moyenne de la visite

00:00:40