在人工智能领域,算力和时间一直是制约技术进步的关键因素。然而,DeepMind团队的最新研究成果,为这一难题提供了解决方案。

他们提出了一种名为JEST的全新数据筛选方法,通过智能筛选最佳数据批次进行训练,实现了AI训练时间的大幅缩短和算力需求的显著降低。据称,可以将AI训练时间减少13倍,并将算力需求降低90%。

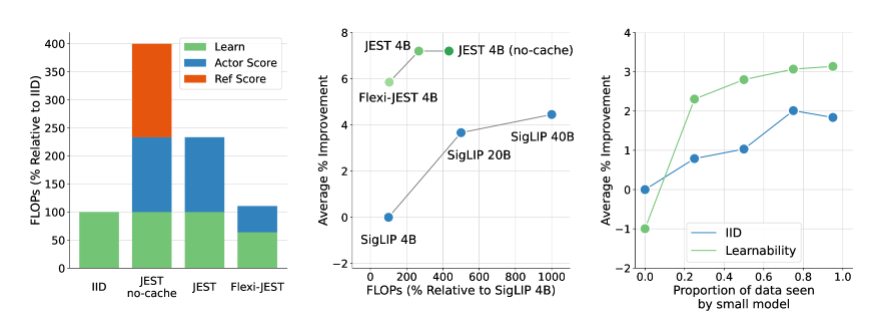

JEST方法的核心在于联合选择最佳数据批次,而非单个样本,这一策略被证明在加速多模态学习方面尤为有效。与传统的大规模预训练数据筛选方法相比,JEST不仅大幅减少了迭代次数和浮点运算次数,而且在仅使用10%的FLOP预算的情况下,就能超越以往的最先进水平。

DeepMind团队的研究揭示了三个关键结论:选择好的数据批次比单独挑选数据点更有效,在线模型近似可以用于更高效地过滤数据,以及可以引导小型高质量数据集以利用更大的非精选数据集。这些发现为JEST方法的高效性能提供了理论基础。

JEST的工作原理,是通过借鉴之前关于RHO损失的研究,结合学习模型和预训练参考模型的损失,评估数据点的可学习性。它选择那些对于预训练模型来说较容易,但对于当前学习模型来说较难的数据点,以此提高训练效率和效果。

此外,JEST还采用了基于阻塞吉布斯采样的迭代方法,逐步构建批次,每次迭代中根据条件可学习性评分选择新的样本子集。这种方法在过滤更多数据时持续改进,包括使用仅基于预训练的参考模型来评分数据。

DeepMind的这项研究不仅为AI训练领域带来了突破性进展,也为未来的AI技术发展提供了新的思路和方法。随着JEST方法的进一步优化和应用,我们有理由相信,人工智能的发展将迎来更加广阔的前景。

论文:https://arxiv.org/abs/2406.17711

划重点:

🚀 **训练效率革命**:DeepMind的JEST方法使AI训练时间减少13倍,算力需求降低90%。

🔍 **数据批次筛选**:JEST通过联合选择最佳数据批次,而非单个样本,显著提升了多模态学习的效率。

🛠️ **创新训练方法**:JEST利用在线模型近似和高质量数据集引导,优化了大规模预训练的数据分布和模型泛化能力。