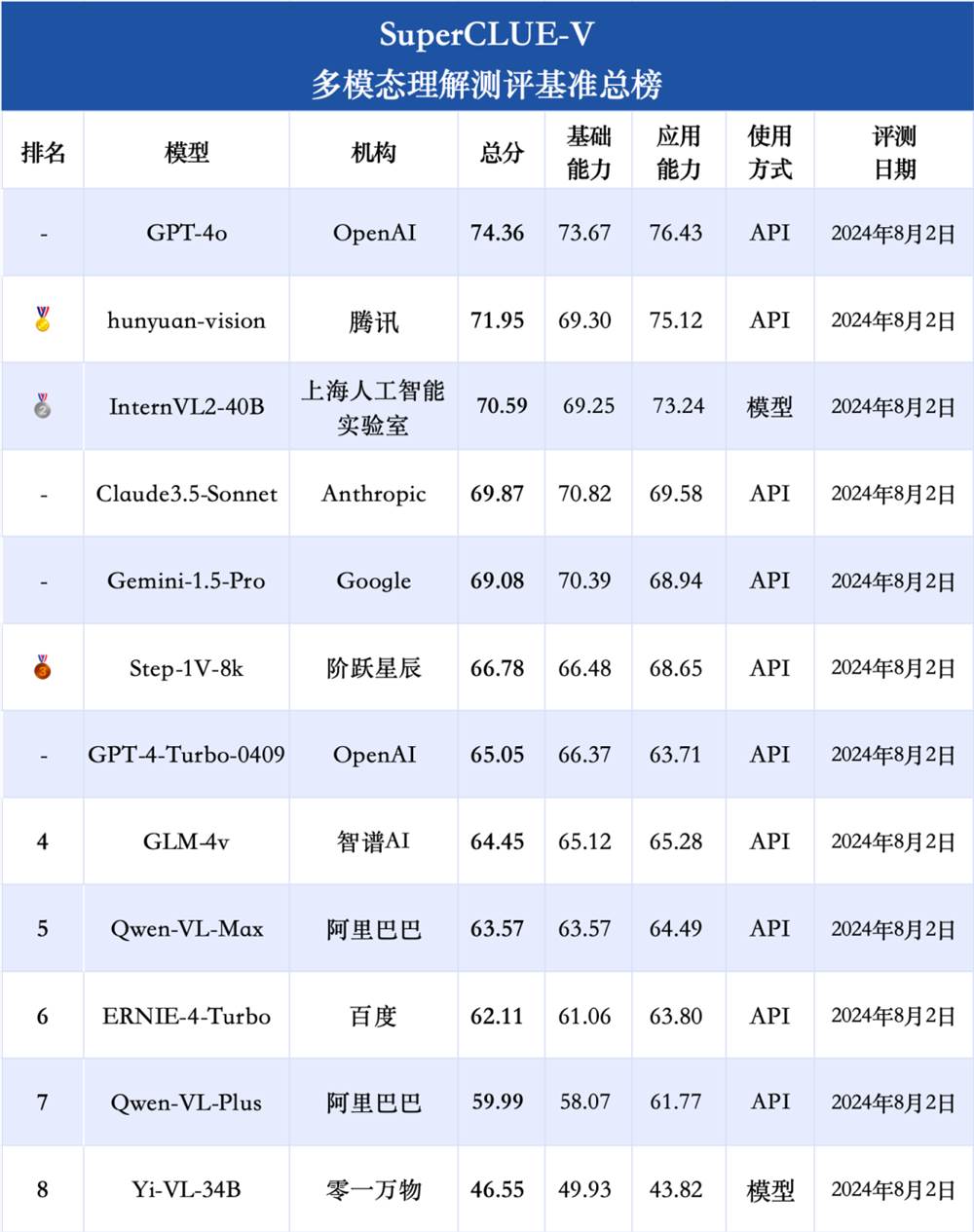

在人工智能的多模态领域,国产大模型正展现出强劲的实力。最新发布的中文多模态大模型测评基准SuperCLUE-V榜单显示,腾讯的hunyuan-vision和上海AI Lab的InternVL2-40B分别成为国内闭源和开源界的两大领跑者,甚至超越了国际知名的Claude-3.5-Sonnet和谷歌的Gemini-1.5-Pro。

腾讯混元大模型的多模态版本,hunyuan-vision,不仅在API调用上受到开发者的青睐,更在腾讯元宝APP中免费向用户开放体验。元宝APP一直以"实用AI搭子"著称,强调实用易用性,而其在多模态能力上的突破,更是在评测中拿下国内第一的佳绩。

为了更直观地展示国产多模态大模型的进步,我们对腾讯元宝进行了一系列的测试。从梗图表情包理解、照片内容识别到视觉错觉挑战,腾讯元宝都展现出了出色的表现。在实际应用场景中,无论是财报摘要读取、学术图表识别还是行测找规律题,元宝都能够准确理解并给出合理的答案。

特别是在一道考验对中国文化背景理解的附加题中,腾讯元宝准确识别了《葫芦兄弟》的截图,并正确回答了相关问题,显示出其在理解中文语境方面的优势。

腾讯混元大模型作为一位"老朋友",自去年9月首次亮相以来,一直保持快速迭代,目前已扩展至万亿参数规模,覆盖文本、多模态理解及生成等领域。在国内大模型中,腾讯混元率先完成MoE架构升级,从单个稠密模型升级到多个专家组成的稀疏模型。

腾讯元宝APP,主打"实用AI搭子",不仅在多端同步、聊天记录同步方面表现出色,更在多模态理解能力上展现出了强大的实力。无论是文档截图、人像风景、收银小票还是任意照片,元宝都能基于图中内容给出自己的理解和分析。

腾讯元宝团队表示,接下来将把更多精力放在融合模型多模态能力上,进一步提升用户体验。同时,腾讯也在深度搜索和深度长文阅读等方面进行了功能更新,减少了技术细节的暴露,简化了用户操作。