一位12年级学生建立了一个创新平台,让人们能够评估不同AI模型在Minecraft创作中的表现,为人工智能评测领域带来了新的视角。

新基准测试方法应对传统评估局限性

随着传统AI基准测试方法的局限性日益明显,开发者们开始寻找更具创造性的评估途径。对一群开发者而言,微软旗下的沙盒建造游戏Minecraft成为了理想选择。

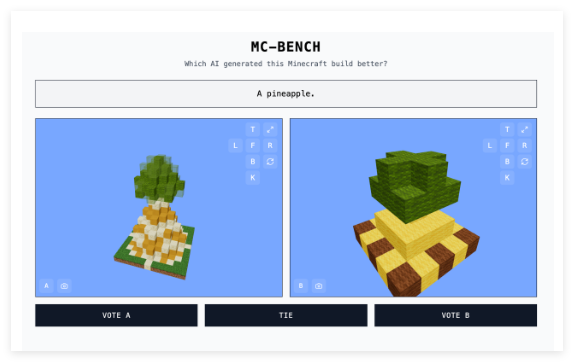

高中生Adi Singh与团队合作开发的Minecraft Benchmark(简称MC-Bench)网站允许AI模型在面对面的挑战中相互竞争,通过Minecraft创作来回应各种提示。用户可以投票选出表现更佳的模型,投票后才能看到每个作品背后的AI制作者。

Singh表示,选择Minecraft作为测试平台是因为其广泛的知名度——作为有史以来最畅销的电子游戏,即使对从未玩过的人来说,也能直观判断哪个块状菠萝更胜一筹。

"Minecraft让人们更容易看到AI开发的进展,"Singh告诉TechCrunch。"人们已经习惯了Minecraft,习惯了它的外观和氛围。"

项目获得主要AI公司支持

MC-Bench目前有8名志愿者参与。根据网站信息,Anthropic、Google、OpenAI和阿里巴巴已为该项目提供补贴,允许使用它们的产品运行基准测试,但这些公司与项目没有其他关联。

Singh分享了项目的未来愿景:"目前,我们只是进行简单的构建,反思我们与GPT-3时代相比取得的进步,但我们计划扩展到长期规划和目标导向任务。游戏可能只是测试代理推理的媒介,它比现实生活更安全,在测试方面更易于控制,在我看来这更理想。"

除Minecraft外,《精灵宝可梦红》、《街头霸王》和《你画我猜》等游戏也被用作AI实验基准,部分原因是AI基准测试本身极具挑战性。

直观评估替代复杂指标

研究人员通常在标准化评估中测试AI模型,但这些测试往往让AI拥有主场优势。由于训练方式的特点,模型天生擅长某些类型的问题,尤其是涉及记忆或基本推理的任务。

这种矛盾体现在多个案例中:OpenAI的GPT-4能在LSAT考试中取得88%的成绩,却无法准确数出"strawberry"一词中有多少个"R";Anthropic的Claude3.7Sonnet在标准化软件工程基准测试中准确率达62.3%,但在玩Pokémon游戏方面却不如大多数五岁儿童。

从技术角度看,MC-Bench是一个编程基准,要求模型编写代码来创建指定的构建,如"雪人弗罗斯蒂"或"原始沙滩上迷人的热带海滩小屋"。但对大多数用户而言,评估雪人外观比深入分析代码更直观,这使得该项目具有更广泛的吸引力,有望收集更多关于模型表现的数据。

虽然这些分数对AI实用性的影响仍有待商榷,但Singh坚信这是一个有力信号:"目前的排行榜与我自己使用这些模型的经验非常接近,这与许多纯文本基准测试不同。也许MC-Bench可以帮助公司了解他们是否朝着正确的方向前进。"