Meta联合滑铁卢大学的研究人员近日共同发布了一款名为 MoCha 的全新 AI 系统,能够通过简单的文本描述生成带有同步语音和自然动作的完整动画角色。这一创新技术有望极大地提升内容创作的效率和表现力,并在多个领域展现出巨大的应用潜力。

打破传统,全身动画与精准口型同步

与以往侧重于面部表情的 AI 模型不同,MoCha 的独特之处在于能够渲染全身的自然运动。无论是从近距离还是半近距离拍摄,系统都能根据文本内容生成包括 唇部同步、手势以及多角色之间的互动 等细腻动作。早期的演示主要集中在上半身,展示了系统如何使角色的口型与对话内容精准匹配,肢体语言也与文本所表达的含义自然契合。

为了实现更精确的唇部同步,研究团队创新性地引入了 “语音-视频窗口注意力”机制。这一机制有效地解决了 AI 视频生成中长期存在的两大挑战:音频保持完整分辨率时视频处理过程中的信息压缩,以及并行视频生成时容易出现的口型错位问题。其核心原理在于 限制每一帧画面只能访问特定窗口范围内的音频数据。这种方法模仿了人类语音的运作方式——口部动作依赖于即时声音,而肢体语言则跟随更广泛的文本模式。通过在每帧音频前后添加标记,MoCha 能够生成更流畅的过渡和更准确的唇语同步效果。

多角色轻松管理,提示系统简洁高效

在处理包含多个角色的场景时,MoCha 团队开发了一套 简洁高效的提示系统。用户只需 定义一次角色信息,便可以通过简单的标签(如 ‘Person1’,‘Person2’)在不同的场景中引用这些角色。这种方式避免了重复描述角色的繁琐过程,使得多角色动画的创作更加便捷。

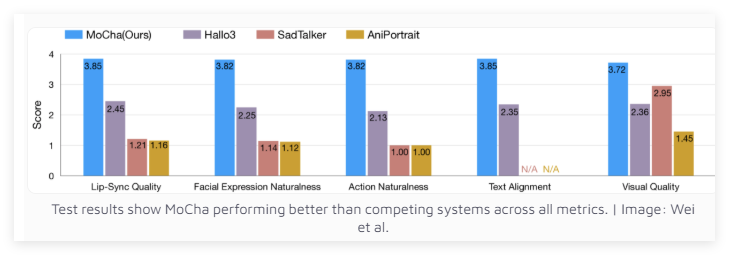

性能卓越,超越同类系统

经过在150种不同场景下的测试,MoCha 在唇部同步和自然动作质量方面均优于同类系统。独立评估人员对 MoCha 生成的视频的逼真度给予了高度评价。测试结果表明,MoCha 在各项指标上都展现出超越竞争对手的实力。

Meta 的研究团队认为,MoCha 在 数字助理、虚拟化身、广告和教育内容 等领域都展现出巨大的应用潜力。然而,Meta 尚未透露该系统是否会开源,或者仍将作为研究原型存在。值得注意的是,MoCha 的开发正值各大社交媒体公司竞相发展 AI 驱动视频技术的关键时期。

此前,Meta 已经推出了 MovieGen,而 TikTok 的母公司字节跳动也在积极研发其自身的 AI 动画系统,包括 INFP、OmniHuman-1和 Goku. 这场 AI 视频技术的竞赛,无疑将加速相关技术的进步和应用普及。