相关AI新闻推荐

谷歌发布全新视觉语言模型 PaliGemma 2 Mix 集成多种功能助力开发者

近日,谷歌宣布推出一款全新的视觉 - 语言模型(Vision-Language Model, VLM),名为 PaliGemma2Mix。这款模型融合了图像处理与自然语言处理的能力,能够同时理解视觉信息和文本输入,并根据需求生成相应的输出,标志着人工智能技术在多任务处理方面的进一步突破。PaliGemma2Mix 的功能非常强大,它集成了图像描述、光学字符识别(OCR)、图像问答、目标检测和图像分割等多种视觉 - 语言任务,适用于多种应用场景。开发者可以通过预训练检查点(checkpoints)直接使用这款模型,或根据自己的需求

硅基流动CEO否认曾拒绝DeepSeek入股:是对未合作表遗憾

近日,围绕硅基流动完成Pre-A轮融资的报道引发了一场关于公司早期发展历程的讨论。创投日报此前报道称,2023年下半年DeepSeek创始人梁文锋曾提出入股硅基流动的意向,条件是开源其自研LLM推理引擎,但遭到了硅基流动CEO袁进辉的拒绝。对此,袁进辉今日在朋友圈作出回应,否认了上述说法。他表示自己提及2023年未与梁文锋展开合作,是在表达对自身缺乏远见的遗憾,而非如报道所述拒绝了投资意向。据了解,成立于2023年8月的硅基流动专注于开发大模型时代的AI基础设施平台。该公司通

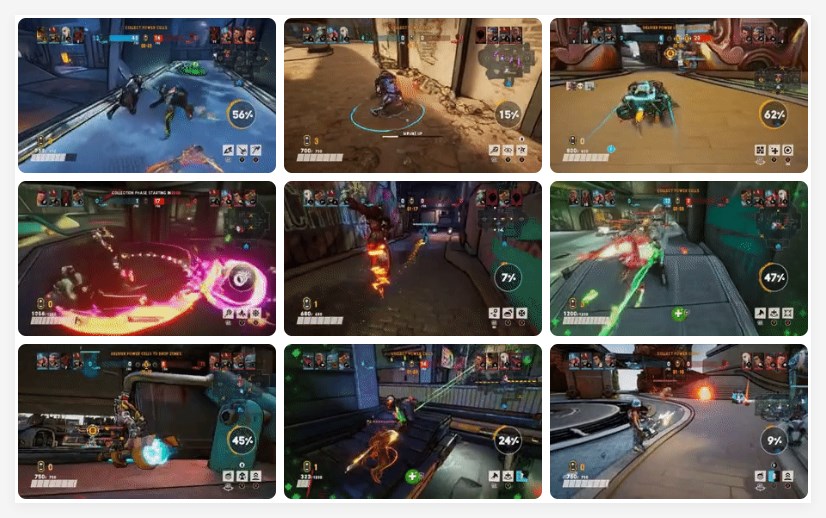

Xbox推新生成AI模型Muse,助力游戏开发者高效创建游戏元素

正文:微软近日宣布推出其新的生成性人工智能模型 Muse,进一步加大在游戏领域的 AI 应用。“Muse” 是由微软研究院与 Xbox Game Studios 的 Ninja Theory 团队合作开发的,这一模型专门针对 Ninja Theory 的多人战斗竞技游戏《Bleeding Edge》进行训练。Muse 的独特之处在于它对3D 游戏世界的深入理解,包括游戏物理和玩家的操作反应。这种深度学习使得 Muse 能够生成一致而多样化的游戏玩法,为游戏创作者提供了强大的支持。微软研究院的目标是探索如何利用生成式 AI 模型来丰富游戏体验,他们与全球

Meta 宣布举办首届生成式 AI 开发者大会 LlamaCon,聚焦 Llama 系列模型

Meta 公司近日宣布,将于4月29日举行首届 LlamaCon 开发者大会,专注于其 Llama 系列生成式 AI 模型的最新进展。这一大会旨在为开发者提供一个平台,分享开源 AI 的最新成果,帮助他们更好地构建应用和产品。随着生成式 AI 技术的迅猛发展,Meta 希望通过此次大会进一步推动其生态系统的建设。在这场即将到来的大会上,Meta 计划展示多项与 Llama 模型相关的新功能和技术进展。Llama 模型自推出以来下载量已达数亿次,已经吸引了至少25个合作伙伴进行托管,显示出其在行业中的广泛应用。Met