日前,Meta 低调的发布了六项研究成果,为 AI 领域带来了新的应用和技术突破。其中包括了多模态模型、文本生成音乐模型、音频水印技术、数据集等多个项目。下面一起来看看这些研究成果具体都是哪些。

Meta Chameleon(“变色龙”模型)

首先,发布的多模态模型 “Chameleon” 可以同时处理文本和图像,支持混合输入和输出文本,为处理多模态数据提供了全新的解决方案。

虽然大多数当前的后期融合模型使用基于扩散的学习,但 Meta Chameleon 对文本和图像使用标记化。这可以实现更统一的方法,并使模型更易于设计、维护和扩展。

如下视频案例:图像生成创意标题或使用文本提示和图像的混合来创建一个全新的场景

目前,Meta将根据研究许可公开发布 Chameleon7B 和34B 模型的关键组件。其当前发布的模型经过了安全调整,支持混合模式输入和纯文本输出,可用于研究目的。官方强调不会发布 Chameleon 图像生成模型。

产品入口:https://top.aibase.com/tool/meta-chameleon

Multi-Token Prediction(多词预测)

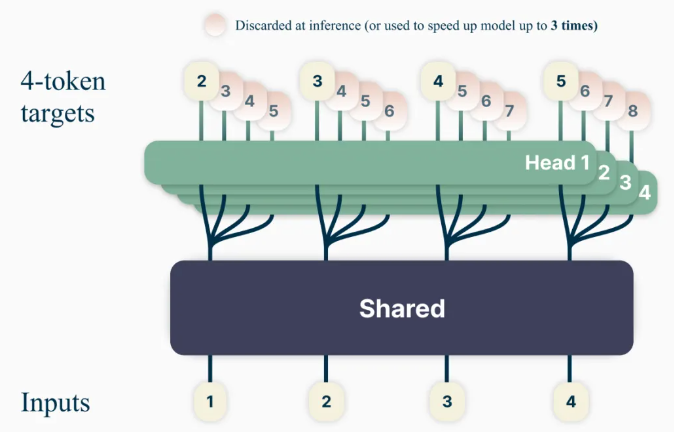

新的语言模型训练方法 “Multi-Token Prediction” 旨在提高模型能力和训练效率,将训练模型一次预测多个单词,提升了模型的预测准确性。

使用这种方法,可以训练语言模型来同时预测多个未来单词,而不是以前每次预测一个单词的方法。这提高了模型能力和训练效率,同时提高了速度。本着负责任的开放科学精神,官方将根据非商业/研究专用许可证发布预训练模型以供代码完成。

产品入口: https://top.aibase.com/tool/multi-token-prediction

文本生成音乐模型 “JASCO”

虽然现有的文本转音乐模型(如MusicGen)主要依靠文本输入来生成音乐,但Meta的新模型“用于时间控制文本转音乐生成的元联合音频和符号条件”(JASCO)能够接受各种条件输入,例如特定的和弦或节拍,以改善对生成的音乐输出的控制。具体来说,可以将信息瓶颈层与时间模糊结合使用,以提取与特定控制相关的信息。这允许在同一个文本转音乐生成模型中同时结合符号和基于音频的条件。

JASCO 在生成质量方面与评估基线相当,同时允许对生成的音乐进行更好、更灵活的控制。官方将发布研究论文和示例页面,本月晚些时候将在 MIT 许可下作为AudioCraft存储库的一部分发布推理代码,并在 CC-BY-NC 下发布预训练模型。

代码入口:https://top.aibase.com/tool/audiocraft

音频水印技术 “AudioSeal”

这是第一种专门为局部检测 AI 生成的语音而设计的音频水印技术,可以精确定位较长音频片段中的 AI 生成的片段。AudioSeal 通过专注于检测 AI 生成的内容而不是隐写术来改进传统的音频水印。

与依赖复杂解码算法的传统方法不同,AudioSeal 的局部检测方法可以实现更快、更高效的检测。与以前的方法相比,这种设计将检测速度提高了485倍,使其非常适合大规模和实时应用。我们的方法在音频水印的稳健性和不可感知性方面实现了最先进的性能。

AudioSeal 是根据商业许可发布。

产品入口:https://top.aibase.com/tool/audioseal

PRISM 数据集

于此同时,Meta 还发布了与外部伙伴合作的 PRISM 数据集,包含全球1500名参与者的对话数据和偏好,用于改进大型语言模型,从而提高模型的对话多样性、偏好多样性和社会效益。

该数据集将每个人的偏好和细粒度反馈映射到与21位不同 LLM 的8,011次实时对话中。

数据集入口:https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

“DIG In” 指标

用于评估文本生成图像模型中存在的地理差异,为模型改进提供了更多的参考数据。为了了解不同地区的人们对地理表示的看法有何不同,Meta进行了一项大规模注释研究。我们为每个示例收集了超过65,000条注释和超过20份调查回复,涵盖吸引力、相似性、一致性和共享建议,以改进对文本转图像模型的自动和人工评估。

代码入口:https://top.aibase.com/tool/dig-in

这些项目的发布为 AI 领域带来了新的技术突破和应用前景,对于推动 AI 技术的发展和应用具有重要意义。