一项对1400万篇 PubMed 摘要的分析显示,自 ChatGPT 推出以来,AI 文本生成器已影响了至少10% 的科学摘要,在某些领域和国家,这一比例甚至更高。

来自图宾根大学和西北大学的研究人员对2010年至2024年间的1400万篇科学摘要进行了语言变化的研究。他们发现,ChatGPT 和类似的 AI 文本生成器导致了某些风格词汇的大幅增加。

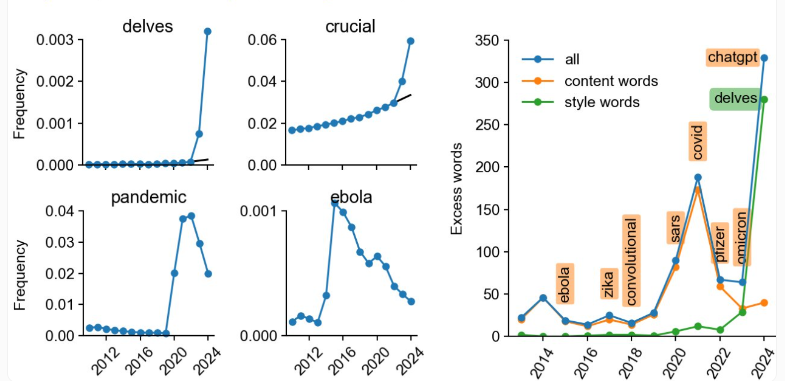

研究人员首先确定了2024年相比以往年份显著更频繁出现的词汇。这些词汇包括 ChatGPT 写作风格中典型的许多动词和形容词,比如 “深入挖掘”、“复杂”、“展示” 和 “突出” 等。

根据这些标志词,研究人员估计在2024年,AI 文本生成器影响了至少10% 的所有 PubMed 摘要。在某些情况下,这一影响甚至超过了 “Covid”、“流行病” 或 “埃博拉” 等词汇在其所处时期的影响。

研究人员发现,在中国和韩国等国家的 PubMed 子组中,大约有15% 的摘要是使用 ChatGPT 生成的,而在英国仅为3%。然而,这并不一定意味着英国作者使用 ChatGPT 较少。

事实上,根据研究人员的说法,实际上使用 AI 文本生成器的可能要高得多。许多研究人员会编辑 AI 生成的文本,以删除典型的标志词。母语使用者在这方面可能具有优势,因为他们更有可能注意到这类短语。这使得确定受 AI 影响的摘要的真实比例变得困难。

在可测量的范围内,AI 的使用在期刊中特别高,比如在 Frontiers 和 MDPI 期刊中约为17%,在 IT 期刊中更是达到了20%。在 IT 期刊中,中国作者的比例最高,达到了35%。

对于科学作者来说,AI 可能有助于使文章更具可读性。研究作者 Dmitry Kobak 表示,专门用于摘要的生成 AI 并不一定是问题所在。

然而,AI 文本生成器也可能捏造事实,强化偏见,甚至进行抄袭,它们还可能降低科学文本的多样性和独创性。

似乎有些讽刺的是,Meta 公司在 ChatGPT 发布不久之前发布的科学开源语言模型 “Galactica” 遭到了科学界部分人士的严厉批评,迫使 Meta 将其下线。这显然并未阻止生成 AI 进入科学写作,但这可能阻止了一个专门针对这一任务进行优化的系统的推出。

划重点:

😮 通过对 PubMed 摘要的分析,发现自 ChatGPT 推出以来,至少10% 的科学摘要受到了 AI 文本生成器的影响。

😯 在中国和韩国等国家的 PubMed 子组中,约15% 的摘要是使用 ChatGPT 生成的,而在英国仅为3%。

😲 AI 文本生成器可能会捏造事实、强化偏见,甚至进行抄袭,因此研究人呼吁重新评估在科学中使用 AI 文本生成器的指导方针。