アリババ傘下のQwenチームは最近、最新のオープンソース大規模言語モデル(LLM)ファミリーメンバーであるQwQ-32Bを発表しました。このパラメータ数320億個の推論モデルは、強化学習(RL)を用いて複雑な問題解決タスクにおける性能向上を目指しています。

QwQ-32Bは、Hugging FaceとModelScopeでApache2.0ライセンスの下でオープンソース化されています。これは、このモデルが商業目的と研究目的に使用できることを意味し、企業は有料サービスを含む製品やアプリケーションに直接適用できます。個人ユーザーもQwen Chatを通じてこのモデルにアクセスできます。

QwQ(Qwen-with-Questionsの略)は、アリババが2024年11月に初めて発表したオープンソース推論モデルで、OpenAIのo1-previewとの競争を目指しています。最初のQwQは、推論プロセスで自身の回答を検証・改善することで、論理推論と計画能力を強化し、特に数学とコーディングタスクで優れた性能を発揮しました。

以前のQwQは、320億個のパラメータと32,000トークンのコンテキスト長を持ち、AIMEやMATHなどの数学ベンチマークテスト、GPQAなどの科学的推論タスクにおいてo1-previewを上回りました。しかし、初期バージョンのQwQはLiveCodeBenchなどのプログラミングベンチマークテストでは比較的弱く、言語の混合や時折の循環論証などの課題に直面していました。

それにもかかわらず、アリババはApache2.0ライセンスでこのモデルを公開することで、OpenAIのo1などの独自の代替手段と差別化し、開発者や企業が自由に適応および商業化できるようにしています。AI分野の発展に伴い、従来のLLMの限界がますます顕著になり、大規模化による性能向上は徐々に鈍化しており、大規模推論モデル(LRM)への関心が強まっています。LRMは、推論時の推論と自己省察によって精度を向上させます(例:OpenAIのo3シリーズやDeepSeek-R1など)。

最新のQwQ-32Bは、強化学習と構造化された自己質問の統合により、性能をさらに向上させ、推論AI分野における重要な競争相手となることを目指しています。Qwenチームの研究によると、強化学習はモデルの複雑な問題解決能力を大幅に向上させることができます。QwQ-32Bは、数学的推論、コーディング能力、一般的な問題解決能力を強化するために、多段階の強化学習トレーニング方法を採用しています。

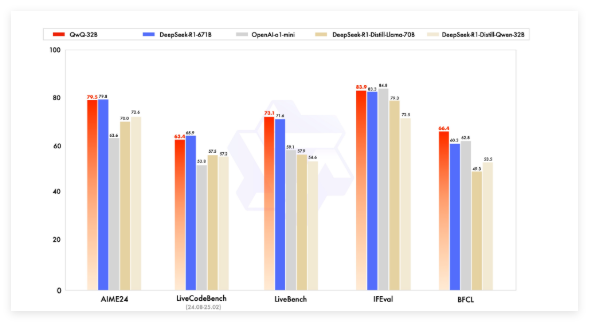

ベンチマークテストでは、QwQ-32BはDeepSeek-R1、o1-mini、DeepSeek-R1-Distilled-Qwen-32Bなどの主要なモデルと競合し、一部の競合製品よりもパラメータ数が少ないにもかかわらず、競争力のある結果を達成しました。例えば、DeepSeek-R1は6710億個のパラメータ(活性化370億個)を持つのに対し、QwQ-32Bは同等の性能を維持しながら、メモリ消費量が少なく、通常GPUで24GBのVRAMが必要です。一方、DeepSeek R1全体を実行するには1500GB以上のVRAMが必要です。

QwQ-32Bは因果言語モデルアーキテクチャを採用し、64個のTransformerレイヤー、RoPE、SwiGLU、RMSNorm、Attention QKVバイアスなど、いくつかの最適化が行われています。また、一般化クエリアテンション(GQA)を採用し、拡張コンテキスト長131,072トークンを持ち、事前学習、教師あり微調整、強化学習を含む多段階のトレーニングを受けています。

QwQ-32Bの強化学習プロセスは2段階に分かれています。まず、数学とコーディング能力に重点を置き、正確性検証器とコード実行サーバーを使用してトレーニングを行います。第2段階では、汎用報酬モデルとルールベースの検証器を使用して報酬トレーニングを行い、指示に従う能力、人間との整合性、代理推論能力を向上させながら、数学とコーディング能力を維持します。

QwQ-32Bはまた、agentic capabilitiesを備えており、環境からのフィードバックに基づいて推論プロセスを動的に調整できます。Qwenチームは、最適な性能を得るために特定の推論設定を使用することを推奨しており、vLLMを使用したデプロイをサポートしています。

QwenチームはQwQ-32Bを、強化学習による推論能力の強化における第一歩と考えており、今後、拡張強化学習のさらなる探求、エージェントと強化学習の統合による長期推論の実現、強化学習に最適化された基礎モデルの継続的な開発を行い、最終的には汎用人工知能(AGI)を目指します。

モデル:https://qwenlm.github.io/blog/qwq-32b/

要点:

🚀 アリババがオープンソース推論大規模モデルQwQ-32Bを発表。強化学習技術を採用し、複雑な問題解決能力を向上。

💡 QwQ-32Bは、数学、プログラミングなどのベンチマークテストでより大きなパラメータを持つモデルと同等の性能を示し、メモリ消費量も少ない。Apache2.0ライセンスでオープンソース化されており、商用利用も無料。

🧠 このモデルは拡張コンテキスト長(13万トークン)とagentic capabilitiesを備え、今後、強化学習によるモデルの知能向上における可能性をさらに探求していく。