Was passiert, wenn KI mit selbstgenerierten Bildern weiter trainiert wird? Forscher der Stanford University und der University of California, Berkeley, haben kürzlich ein Experiment durchgeführt, dessen Ergebnisse verblüffend sind.

Sie stellten fest, dass KI-Bildgenerierungsmodelle, die mit ihren eigenen generierten Bildern erneut trainiert werden, stark verzerrte Bilder erzeugen. Schlimmer noch: Diese Verzerrung beschränkt sich nicht nur auf die für das erneute Training verwendeten Textaufforderungen. Sobald das Modell „kontaminiert“ ist, ist eine vollständige Wiederherstellung selbst durch anschließendes Training mit echten Bildern nur schwer möglich.

Ausgangspunkt des Experiments war ein Open-Source-Modell namens Stable Diffusion (SD). Die Forscher wählten zunächst 70.000 hochwertige Gesichtsbilder aus dem FFHQ-Gesichtsdatensatz aus und klassifizierten sie automatisch. Anschließend generierten sie mit diesen echten Bildern als Eingabe über das Stable Diffusion-Modell 900 Bilder, die mit den Merkmalen bestimmter Personengruppen übereinstimmten.

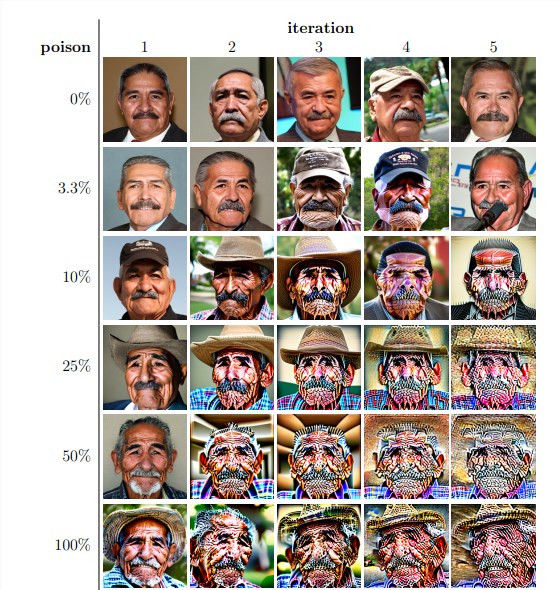

Als Nächstes verwendeten die Forscher diese generierten Bilder für das iterative Wiedertraining des Modells. Sie stellten fest, dass das Modell unabhängig vom Anteil selbstgenerierter Bilder im Wiedertrainingsdatensatz letztendlich zusammenbrach und die Qualität der generierten Bilder stark abnahm. Sogar bei einem Anteil von nur 3 % selbstgenerierter Bilder im Wiedertrainingsdatensatz trat der Modellzusammenbruch auf.

Die Ergebnisse zeigten, dass die Bilder des Basis-Stable-Diffusion-Modells mit den Textaufforderungen übereinstimmten und eine hohe visuelle Qualität aufwiesen. Nach dem iterativen Wiedertraining wiesen die generierten Bilder jedoch semantische Inkonsistenzen und visuelle Verzerrungen auf. Die Forscher stellten außerdem fest, dass der Modellzusammenbruch nicht nur die Bildqualität beeinträchtigte, sondern auch zu einem Mangel an Vielfalt bei den generierten Bildern führte.

Um dies zu überprüfen, führten die Forscher Kontrollversuche durch, bei denen versucht wurde, den Einfluss des Modellzusammenbruchs durch Anpassung des Farbhistograms der generierten Bilder und Entfernung von Bildern niedriger Qualität zu verringern. Die Ergebnisse zeigten jedoch, dass diese Maßnahmen den Modellzusammenbruch nicht effektiv verhindern konnten.

Die Forscher untersuchten auch, ob das Modell nach der „Kontamination“ durch erneutes Training wiederhergestellt werden konnte. Sie stellten fest, dass die Qualität der generierten Bilder zwar in einigen Fällen nach mehreren Iterationen des Wiedertrainings verbessert wurde, die Anzeichen eines Modellzusammenbruchs jedoch weiterhin bestanden. Dies deutet darauf hin, dass die Auswirkungen einer „Kontamination“ des Modells langfristig und möglicherweise irreversibel sein können.

Diese Studie zeigt ein wichtiges Problem auf: Die derzeit gängigen diffusionsbasierten Text-zu-Bild-Generierungs-KI-Systeme sind sehr empfindlich gegenüber Daten„kontamination“. Diese „Kontamination“ kann unbeabsichtigt erfolgen, z. B. durch unselektives Herunterladen von Bildern aus Online-Ressourcen. Sie kann aber auch gezielt erfolgen, z. B. durch das absichtliche Platzieren „kontaminierter“ Daten auf Websites.

Angesichts dieser Herausforderungen schlagen die Forscher einige mögliche Lösungen vor, z. B. die Verwendung von Bildauthentizitätsdetektoren zum Ausschluss von KI-generierten Bildern oder das Einfügen von Wasserzeichen in die generierten Bilder. Diese Methoden sind zwar nicht perfekt, aber in Kombination könnten sie das Risiko einer Daten„kontamination“ deutlich reduzieren.

Diese Studie erinnert uns daran, dass die Entwicklung der KI-Technologie nicht ohne Risiken ist. Wir müssen vorsichtiger mit KI-generierten Inhalten umgehen und sicherstellen, dass sie keine langfristigen negativen Auswirkungen auf unsere Modelle und Datensätze haben. Zukünftige Forschung muss untersuchen, wie KI-Systeme widerstandsfähiger gegen diese Art von Daten„kontamination“ gemacht werden können oder wie die „Heilung“ von Modellen beschleunigt werden kann.