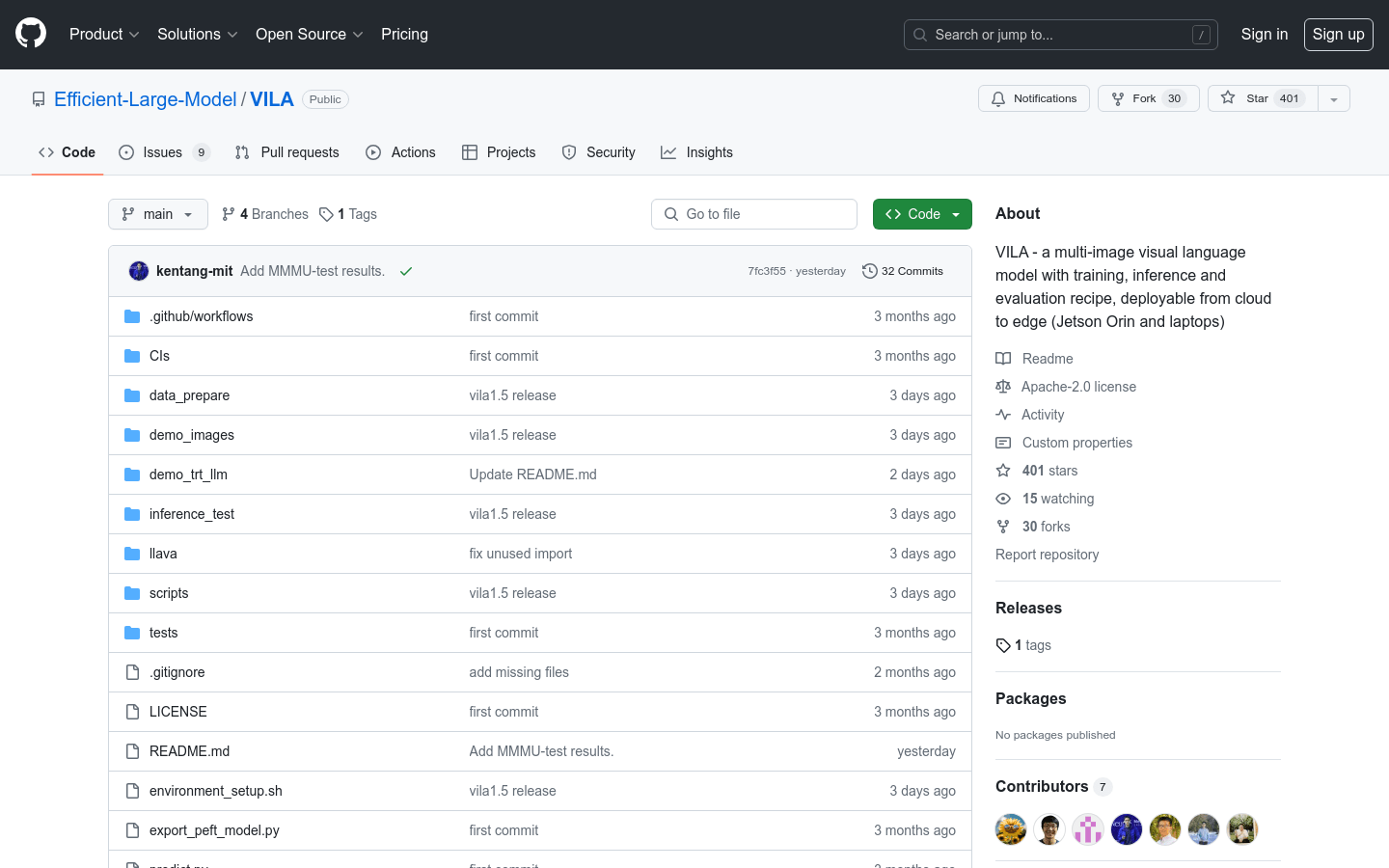

VILA

Ein multimodales visuelles Sprachmodell mit Trainings-, Inferenz- und Evaluierungslösungen, das sich von der Cloud bis zu Edge-Geräten (wie Jetson Orin und Laptops) einsetzen lässt.

Normales ProduktBildVisuelles SprachmodellVideoverständnis

VILA ist ein vortrainiertes visuelles Sprachmodell (VLM), das durch das Vortraining mit umfangreichen, interleaved Bild-Text-Daten Videoverständnis und Multi-Bild-Verständnis ermöglicht. VILA ist durch AWQ 4-Bit-Quantisierung und das TinyChat-Framework auf Edge-Geräten einsetzbar. Die Hauptvorteile sind: 1) Interleaved Bild-Text-Daten sind entscheidend für die Leistungssteigerung; 2) Das Nicht-Einfrieren des großen Sprachmodells (LLM) während des interleaved Bild-Text-Pretrainings fördert das kontextuelle Lernen; 3) Das Remixen von Text-Anweisungsdaten ist entscheidend für die Verbesserung der VLM- und reinen Textleistung; 4) Die Token-Komprimierung ermöglicht die Skalierung der Anzahl der Videobilder. VILA zeigt faszinierende Fähigkeiten, darunter Video-Inferenz, kontextuelles Lernen, visuelle Denkverkettung und verbessertes Weltwissen.

VILA Neueste Verkehrssituation

Monatliche Gesamtbesuche

474564576

Absprungrate

36.20%

Durchschnittliche Seiten pro Besuch

6.1

Durchschnittliche Besuchsdauer

00:06:34