ALMA-13B-R

Modelo avanzado de traducción automática

Producto ComúnProductividadTraducción automáticaAjuste fino del modelo

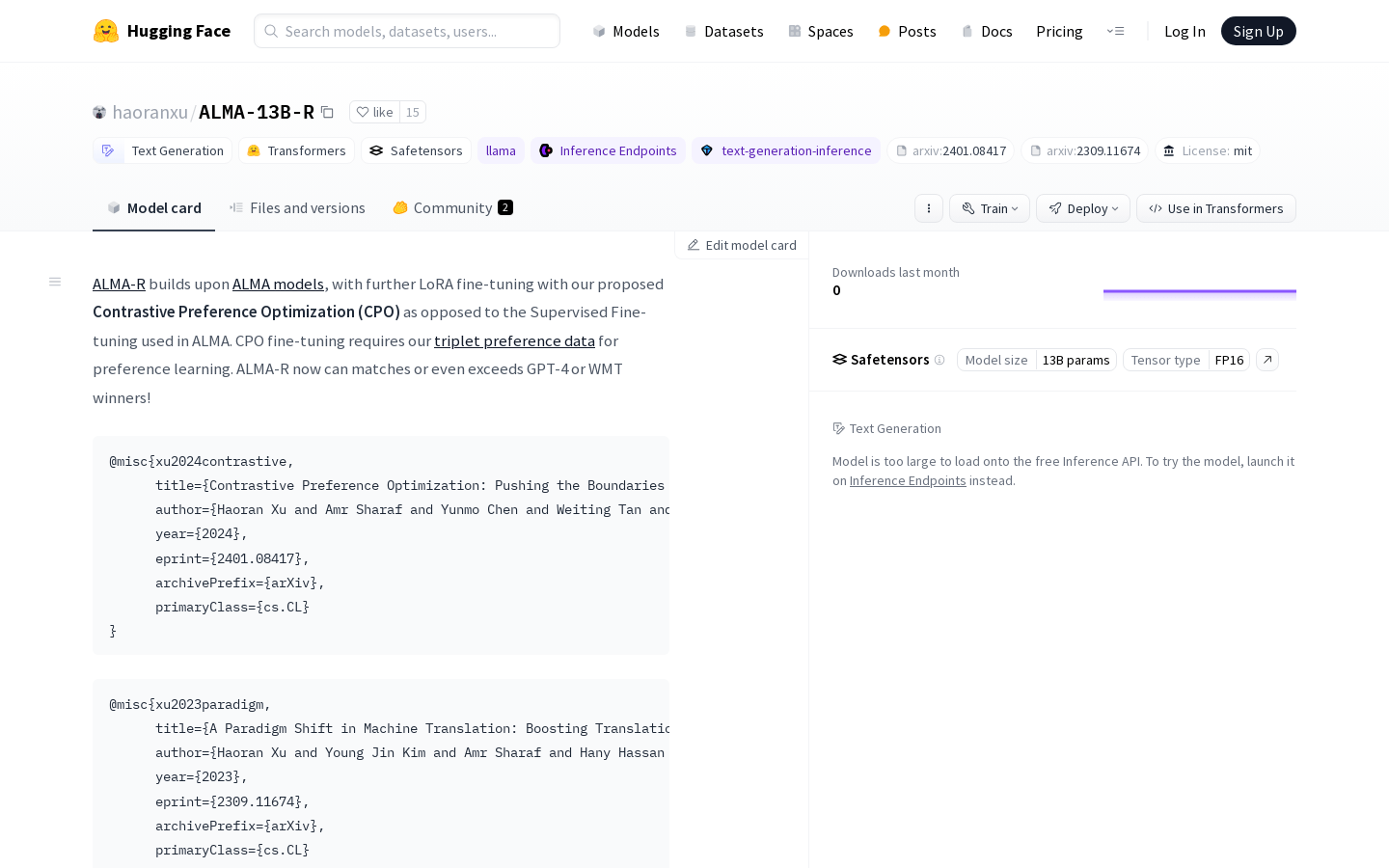

El modelo ALMA-R, ajustado con LoRA mediante la Optimización de Preferencia Contrastiva (CPO), supera a GPT-4 y a los ganadores del WMT. Los usuarios pueden descargar el modelo ALMA(-R) y el conjunto de datos en el repositorio de GitHub. ALMA-R se basa en el modelo ALMA y se ha ajustado con nuestra Optimización de Preferencia Contrastiva (CPO), en lugar del ajuste supervisado utilizado en ALMA. El ajuste con CPO requiere nuestros datos de preferencias en tripletas para el aprendizaje de preferencias. ¡ALMA-R ahora puede igualar o incluso superar a GPT-4 o a los ganadores del WMT!

ALMA-13B-R Situación del tráfico más reciente

Total de visitas mensuales

29742941

Tasa de rebote

44.20%

Páginas promedio por visita

5.9

Duración promedio de la visita

00:04:44