Meta a récemment annoncé le lancement de trois nouvelles fonctionnalités pour ses lunettes intelligentes Ray-Ban : l’IA en temps réel, la traduction en temps réel et Shazam. Actuellement, les fonctionnalités d’IA en temps réel et de traduction en temps réel sont réservées aux membres du programme d’accès anticipé Meta, tandis que la fonctionnalité Shazam est disponible pour tous les utilisateurs aux États-Unis et au Canada.

Annoncées plus tôt cette année lors de la conférence Meta Connect 2024, les fonctionnalités d’IA en temps réel et de traduction en temps réel permettent des interactions innovantes. L’IA en temps réel permet aux utilisateurs de converser naturellement avec l’assistant IA de Meta tout en observant leur environnement. Par exemple, dans le rayon fruits et légumes d’un supermarché, vous pourriez théoriquement demander à l’IA de Meta de vous suggérer des recettes en fonction des ingrédients que vous examinez. Meta indique qu’avec une batterie complètement chargée, les utilisateurs peuvent utiliser la fonctionnalité d’IA en temps réel pendant environ 30 minutes.

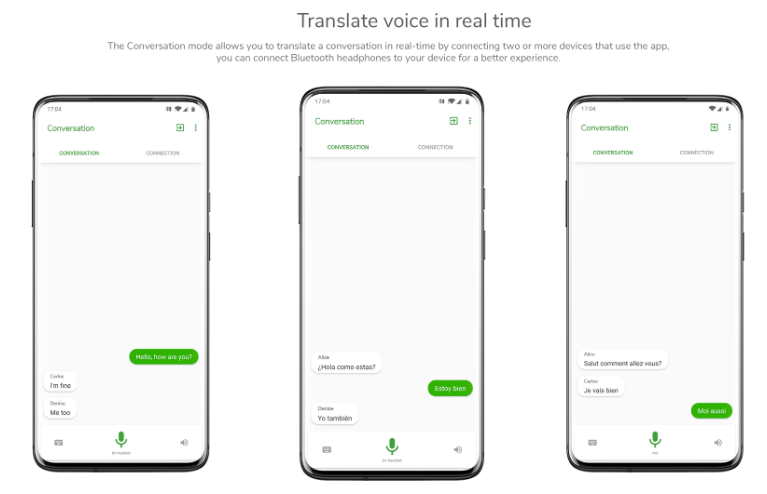

Parallèlement, la fonctionnalité de traduction en temps réel permet aux lunettes de traduire la parole en temps réel entre l’anglais et l’espagnol, le français ou l’italien. Vous pouvez choisir d’entendre la traduction via les lunettes elles-mêmes ou de consulter le texte traduit sur votre téléphone. Vous devez télécharger les paires de langues au préalable et spécifier la langue que vous et votre interlocuteur utilisez.

La fonctionnalité Shazam est plus directe. Lorsque vous entendez une chanson, il vous suffit de le signaler à l’IA Meta, qui devrait alors être en mesure de vous indiquer le titre de la chanson en cours de lecture. Mark Zuckerberg, PDG de Meta, a présenté cette fonctionnalité dans une vidéo Instagram.

Si ces nouvelles fonctionnalités n’apparaissent pas sur vos lunettes, assurez-vous que vos lunettes fonctionnent avec le logiciel v11 et que votre application Meta View est en version v196. Si vous n’avez pas encore rejoint le programme d’accès anticipé, vous pouvez faire une demande via ce site web.

Cette mise à jour intervient à un moment où les géants de la technologie mettent en avant les assistants IA comme argument de vente principal pour les lunettes intelligentes. La semaine dernière, Google a lancé Android XR, un nouveau système d’exploitation spécialement conçu pour les lunettes intelligentes, en soulignant son assistant IA Gemini comme application phare. Simultanément, Andrew Bosworth, directeur technique de Meta, a publié un article de blog indiquant que « 2024 est une année de progrès significatifs pour les lunettes IA ». Bosworth a également affirmé que les lunettes intelligentes pourraient être la meilleure forme de « véritablement natif IA » et la première catégorie de matériel entièrement définie par l’IA dès le départ.

En résumé, la mise à niveau des fonctionnalités des lunettes intelligentes Meta démontre le potentiel considérable de l’IA dans le domaine des appareils portables, et la compétition entre les géants de la technologie devrait accélérer le développement de la technologie des lunettes intelligentes.