ALMA-13B-R

Modèle de traduction automatique avancé

Produit OrdinaireProductivitéTraduction automatiqueAffinage du modèle

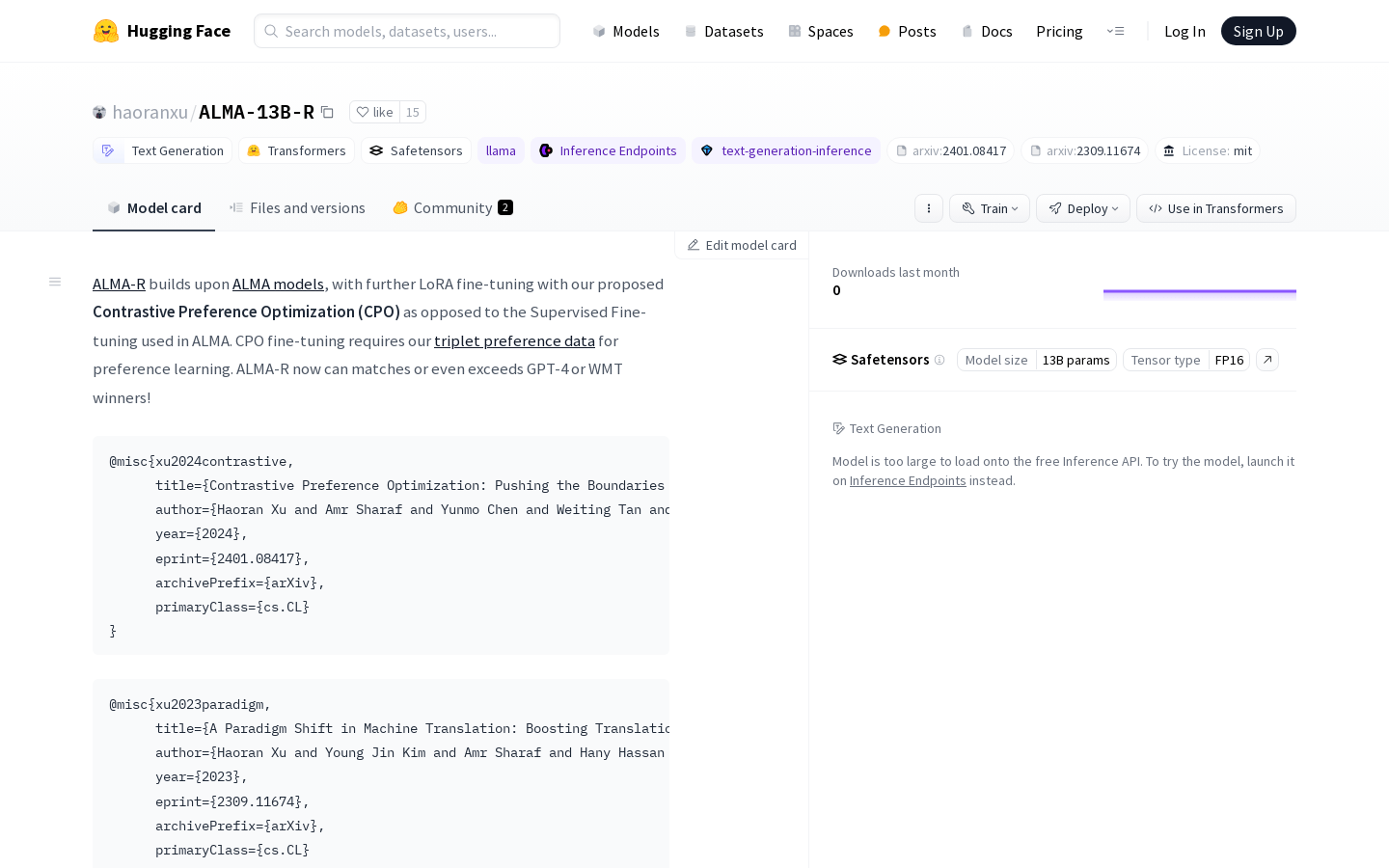

Le modèle ALMA-R, affiné par optimisation de préférence contrastive (CPO) via LoRA, surpasse GPT-4 et les gagnants du WMT. Les utilisateurs peuvent télécharger le modèle ALMA(-R) et les ensembles de données sur le dépôt GitHub. ALMA-R, basé sur le modèle ALMA, utilise l'optimisation de préférence contrastive (CPO) que nous avons proposée pour l'affinage, contrairement à l'affinage supervisé utilisé dans ALMA. L'affinage CPO nécessite nos données de préférence en triplets pour l'apprentissage par préférence. ALMA-R atteint désormais, voire dépasse, les performances de GPT-4 ou des lauréats du WMT !

ALMA-13B-R Dernière situation du trafic

Nombre total de visites mensuelles

29742941

Taux de rebond

44.20%

Nombre moyen de pages par visite

5.9

Durée moyenne de la visite

00:04:44