Groq कंपनी ने हाल ही में अपनी वेबसाइट पर एक तेज़ LLM इंजन लॉन्च किया है, जिससे डेवलपर्स सीधे बड़े भाषा मॉडल के त्वरित प्रश्न पूछने और कार्य निष्पादन कर सकते हैं।

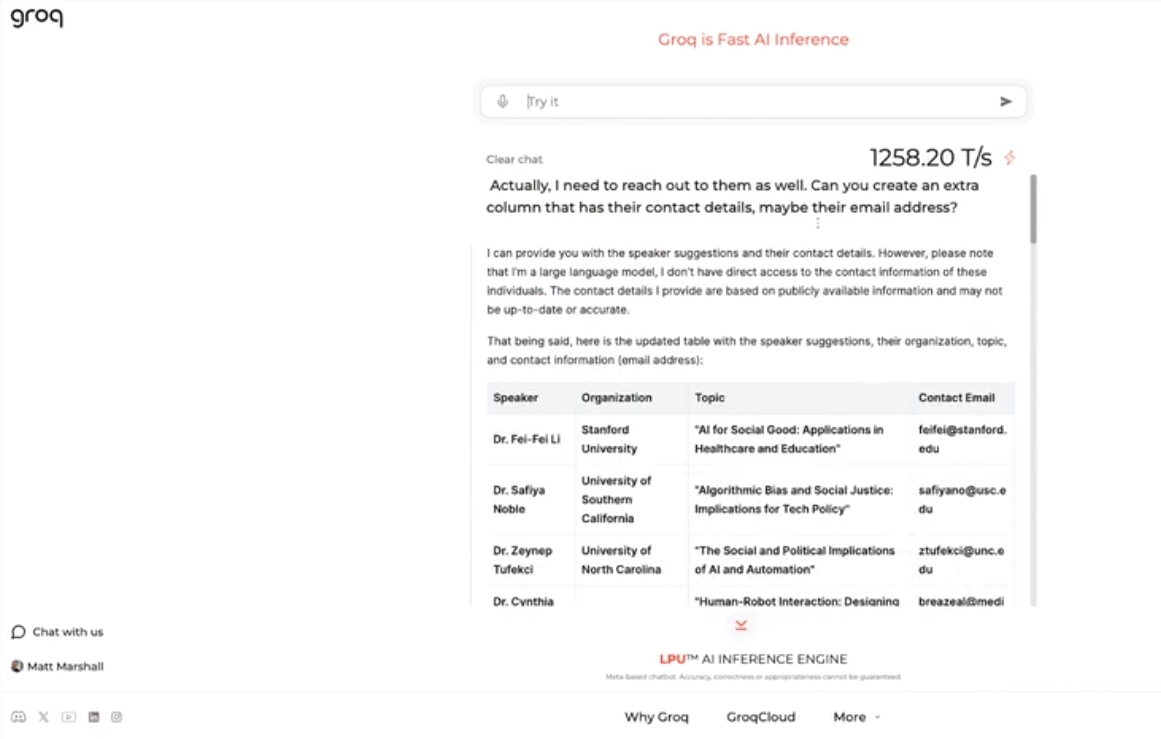

यह इंजन Meta के ओपन-सोर्स LLama3-8b-8192LLM का उपयोग करता है, जो अन्य मॉडलों का डिफ़ॉल्ट रूप से समर्थन करता है, और इसकी गति आश्चर्यजनक है। परीक्षण परिणामों के अनुसार, Groq का इंजन प्रति सेकंड 1256.54 टोकन संसाधित कर सकता है, जो Nvidia जैसी कंपनियों के GPU चिप्स से कहीं अधिक है। इस कदम ने डेवलपर्स और गैर-डेवलपर्स का व्यापक ध्यान आकर्षित किया, जिससे LLM चैटबॉट की तेजी और लचीलापन प्रदर्शित हुआ।

Groq के CEO Jonathan Ross ने कहा कि LLM का उपयोग और बढ़ेगा, क्योंकि लोग देखेंगे कि Groq के तेज़ इंजन पर इसका उपयोग करना कितना सरल है। प्रदर्शनों के माध्यम से, लोग देख सकते हैं कि इस गति पर विभिन्न कार्यों को आसानी से पूरा किया जा सकता है, जैसे कि नौकरी के विज्ञापन बनाना, लेख की सामग्री को संशोधित करना आदि। Groq का इंजन यहां तक कि वॉयस कमांड के आधार पर प्रश्न पूछ सकता है, जो इसकी शक्तिशाली कार्यक्षमता और उपयोगकर्ता मित्रता को प्रदर्शित करता है।

Groq मुफ्त LLM वर्कलोड सेवा प्रदान करने के अलावा, डेवलपर्स के लिए एक कंसोल भी प्रदान करता है, जिससे वे आसानी से OpenAI पर बनाए गए अनुप्रयोगों को Groq पर स्विच कर सकते हैं।

यह सरल स्विचिंग विधि बड़ी संख्या में डेवलपर्स को आकर्षित कर रही है, और वर्तमान में 280,000 से अधिक लोग Groq की सेवाओं का उपयोग कर रहे हैं। CEO Ross ने कहा कि अगले वर्ष, वैश्विक रूप से आधे से अधिक इंफेरेंस कंप्यूटिंग Groq के चिप्स पर चलेगी, जो कंपनी की AI क्षेत्र में क्षमता और संभावनाओं को दर्शाता है।

मुख्य बिंदु:

🚀 Groq ने तेज़ LLM इंजन लॉन्च किया, जो प्रति सेकंड 1256.54 टोकन संसाधित करता है, GPU की गति से कहीं अधिक

🤖 Groq का इंजन LLM चैटबॉट की तेजी और लचीलापन को प्रदर्शित करता है, डेवलपर्स और गैर-डेवलपर्स का ध्यान आकर्षित करता है

💻 Groq मुफ्त LLM वर्कलोड सेवा प्रदान करता है, 280,000 से अधिक डेवलपर्स इसका उपयोग कर रहे हैं, और उम्मीद है कि अगले वर्ष वैश्विक रूप से आधे इंफेरेंस कंप्यूटिंग इसके चिप्स पर चलेगी