Yuan2.0-M32-hf-int8

उच्च-प्रदर्शन मिश्रित विशेषज्ञ भाषा मॉडल

सामान्य उत्पादप्रोग्रामिंगमिश्रित विशेषज्ञ मॉडलध्यान राउटर

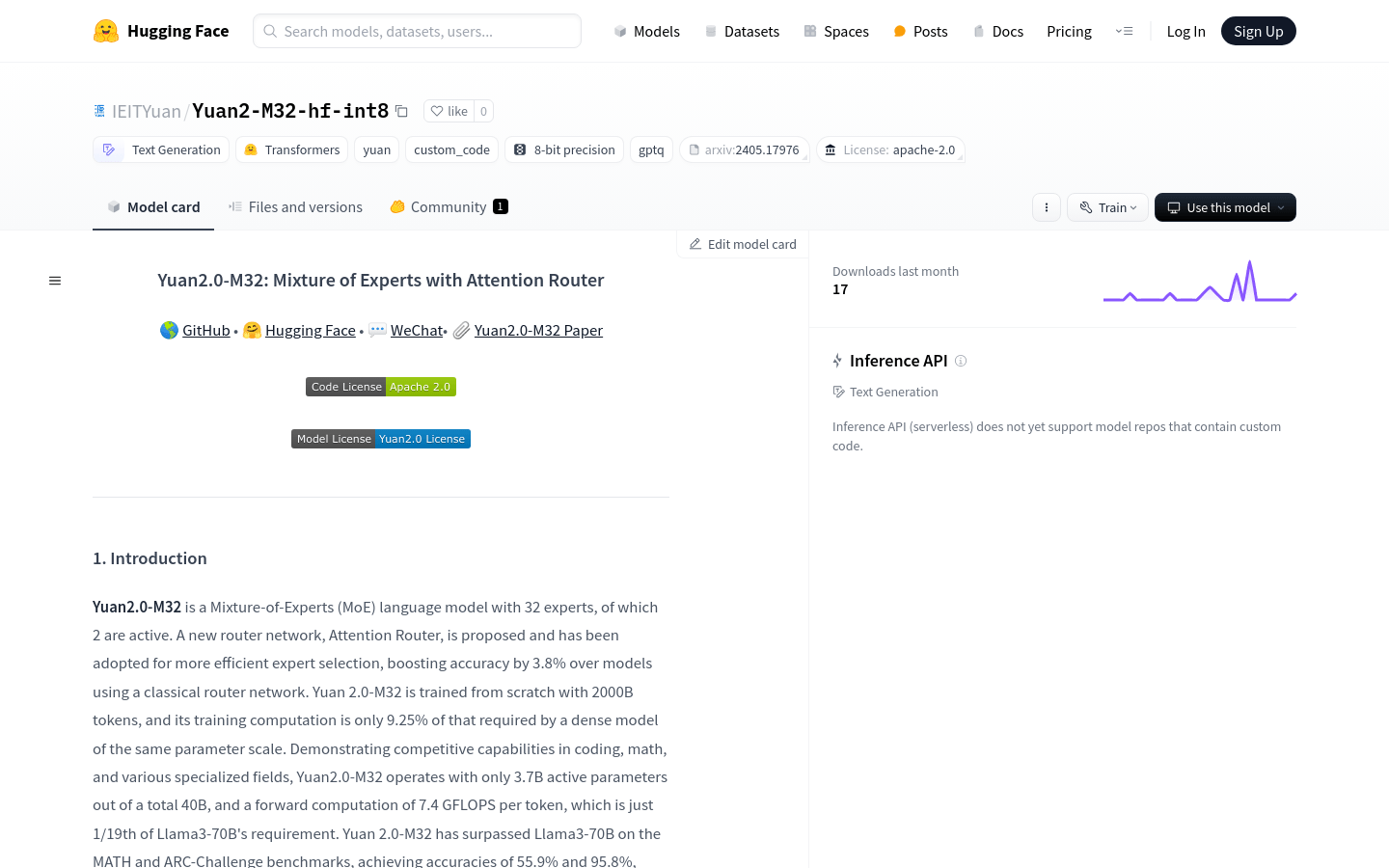

Yuan2.0-M32-hf-int8 एक 32 विशेषज्ञों वाला मिश्रित विशेषज्ञ (MoE) भाषा मॉडल है, जिसमें से केवल 2 सक्रिय हैं। इस मॉडल में एक नए राउटिंग नेटवर्क - ध्यान राउटर का उपयोग करके विशेषज्ञ चयन की दक्षता में सुधार किया गया है, जिससे परंपरागत राउटिंग नेटवर्क वाले मॉडल की तुलना में सटीकता में 3.8% का सुधार हुआ है। Yuan2.0-M32 को 200 बिलियन टोकन का उपयोग करके शुरू से ही प्रशिक्षित किया गया है, इसकी प्रशिक्षण गणना समान पैरामीटर स्केल के घने मॉडल की आवश्यकता वाली गणना का केवल 9.25% है। यह मॉडल प्रोग्रामिंग, गणित और विभिन्न पेशेवर क्षेत्रों में प्रतिस्पर्धी प्रदर्शन दिखाता है और इसमें केवल 3.7 बिलियन सक्रिय पैरामीटर हैं, जो कुल 4 बिलियन पैरामीटर का एक छोटा सा हिस्सा है। प्रत्येक टोकन के लिए फॉरवर्ड गणना केवल 7.4 GFLOPS है, जो Llama3-70B की आवश्यकता का केवल 1/19 है। MATH और ARC-Challenge बेंचमार्क परीक्षणों में Yuan2.0-M32 ने Llama3-70B को पीछे छोड़ दिया है, जिसमें क्रमशः 55.9% और 95.8% की सटीकता प्राप्त की है।

Yuan2.0-M32-hf-int8 नवीनतम ट्रैफ़िक स्थिति

मासिक कुल विज़िट

29742941

बाउंस दर

44.20%

प्रति विज़िट औसत पृष्ठ

5.9

औसत विज़िट अवधि

00:04:44