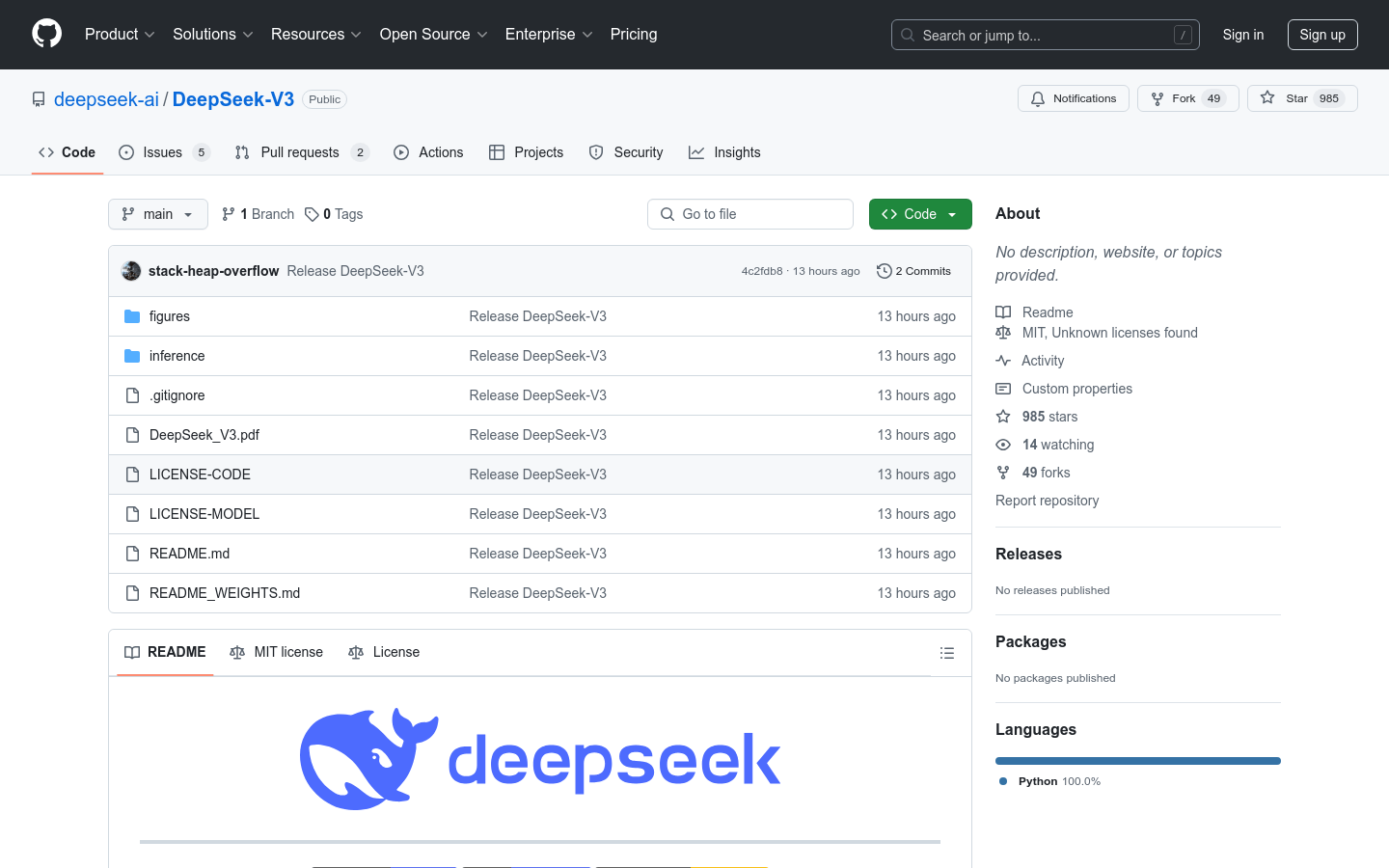

DeepSeek-V3

671B पैरामीटर वाला एक मिश्रण-ऑफ़-एक्सपर्ट्स भाषा मॉडल।

चीनी चयनउत्पादकताप्राकृतिक भाषा प्रसंस्करणगहन शिक्षा

DeepSeek-V3 एक शक्तिशाली मिश्रण-ऑफ़-एक्सपर्ट्स (MoE) भाषा मॉडल है, जिसमें 671B कुल पैरामीटर हैं, और हर बार 37B पैरामीटर सक्रिय होते हैं। इसमें मल्टी-हेड लेटेंट अटेंशन (MLA) और DeepSeekMoE आर्किटेक्चर का उपयोग किया गया है, जिनका DeepSeek-V2 में पूरी तरह से सत्यापन किया गया है। इसके अलावा, DeepSeek-V3 ने पहली बार बिना सहायता वाले नुकसान के भार संतुलन रणनीति को अपनाया है, और बेहतर प्रदर्शन के लिए मल्टी-टोकन भविष्यवाणी प्रशिक्षण लक्ष्य निर्धारित किए हैं। DeepSeek-V3 को 14.8 ट्रिलियन उच्च-गुणवत्ता वाले टोकनों पर प्री-ट्रेन किया गया है, जिसके बाद इसकी क्षमताओं का पूरी तरह से उपयोग करने के लिए पर्यवेक्षित माइक्रो-ट्यूनिंग और प्रबलित सीखने के चरण आए हैं। समग्र मूल्यांकन से पता चलता है कि DeepSeek-V3 अन्य ओपन-सोर्स मॉडलों से आगे निकल गया है और अग्रणी क्लोज्ड-सोर्स मॉडलों के बराबर प्रदर्शन प्राप्त कर चुका है। उत्कृष्ट प्रदर्शन के बावजूद, DeepSeek-V3 के पूर्ण प्रशिक्षण में केवल 2.788M H800 GPU घंटे लगे हैं, और प्रशिक्षण प्रक्रिया बहुत स्थिर रही है।

DeepSeek-V3 नवीनतम ट्रैफ़िक स्थिति

मासिक कुल विज़िट

474564576

बाउंस दर

36.20%

प्रति विज़िट औसत पृष्ठ

6.1

औसत विज़िट अवधि

00:06:34