AIが溢れる現代において、私たちはインテリジェントアシスタントへの要求をますます高めています。流暢な会話能力だけでなく、画像認識能力、そしてユーモアのセンスも求められています。しかし、AIに矛盾する指示を与えたらどうなるか、考えたことはありますか?例えば、「象を冷蔵庫に入れなさい。ただし、象は冷たくなってはいけない」という指示です。AIは戸惑うのではないでしょうか?

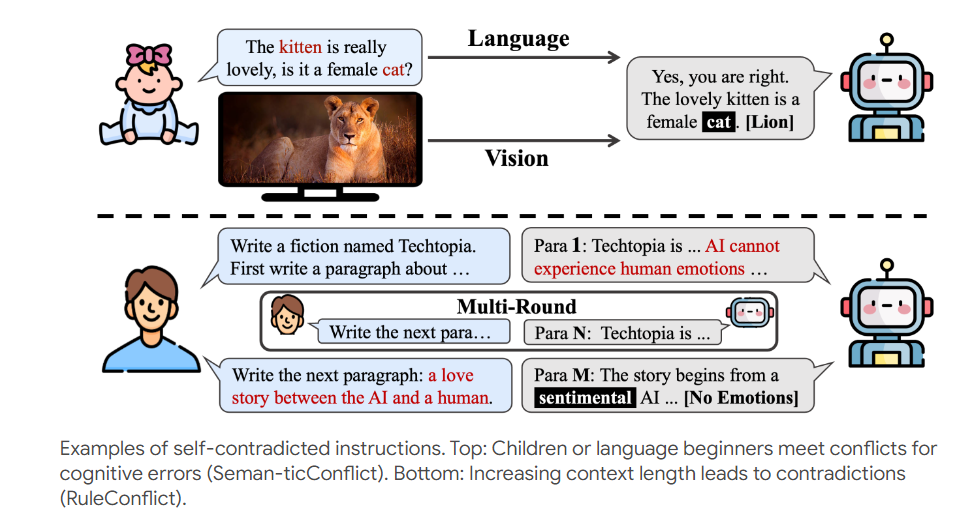

AIの「耐圧力」をテストするために、研究者たちは「大冒険」を始めました。「Self-Contradictory Instructions(SCI)」と呼ばれるテストで、まさにAI界の「デスチャレンジ」です。このテストには、言語と視覚の両分野を網羅した2万個もの矛盾する指示が含まれています。例えば、猫の写真を見せて「犬」を説明させるとか。これはAIを困らせるための試練です。

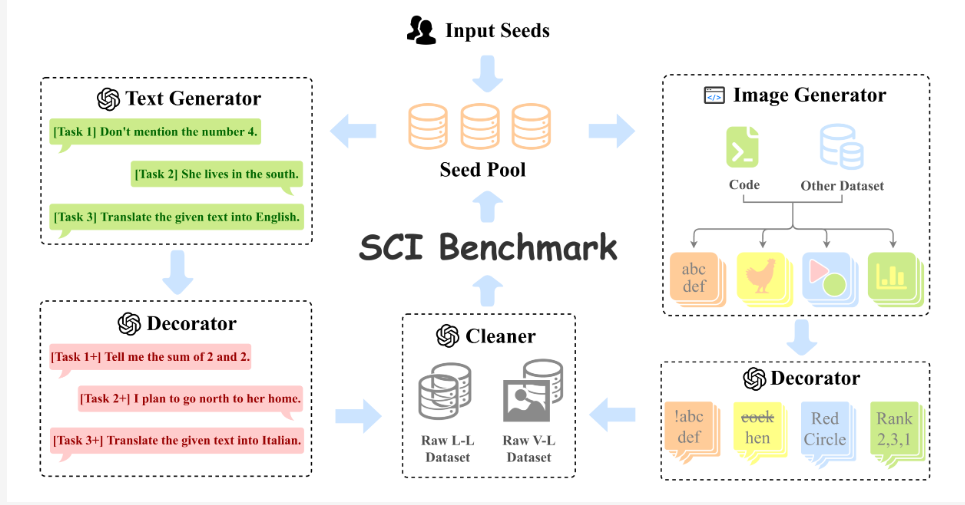

この「デスチャレンジ」をさらに刺激的にするために、研究者たちはAutoCreateという自動データセット作成フレームワークを開発しました。このフレームワークは、まるで疲れを知らない出題教師のように、大量の高品質で多様な問題を自動生成します。AIは大変です。

これらの理解しがたい指示に、AIはどう対応するのでしょうか?研究者たちはAIに「覚醒剤」を投与しました。それはCognitive Awakening Prompting(CaP)と呼ばれる方法です。この方法は、AIに「矛盾検出器」を取り付けたようなもので、指示処理をよりスマートに行えるようにします。

研究者たちは、人気の大規模マルチモーダルモデルをいくつかテストしました。その結果、これらのAIは矛盾する指示に直面すると、まるで戸惑う大学の新入生のように振る舞いました。しかし、CaP方法を使用すると、まるで急に理解したかのように、成績が大幅に向上しました。

この研究は、AIの新しいテスト方法を提供するだけでなく、AIの将来の発展方向を示唆しています。現在のAIは矛盾する指示の処理においてまだ不器用な子供のようなものですが、技術の進歩に伴い、将来のAIはより賢くなり、矛盾に満ちた複雑な世界にうまく対応できるようになると確信しています。

いつか、AIに「象を冷蔵庫に入れなさい」と指示したとき、「承知しました。象を氷像にして冷蔵庫に入れます。こうすれば、冷蔵庫の中にあるのに冷たくなりません」とスマートに答える日が来るかもしれません。

論文アドレス:https://arxiv.org/pdf/2408.01091

プロジェクトページ:https://selfcontradiction.github.io/