先日、OpenAIは「ストロベリー」というコードネームで知られていた、正式名称「o1-preview」のAIモデルを発表しました。

OpenAIは、この新しいモデルが物理学、化学、生物学などの高度な基準タスクにおいて、博士課程の学生に劣らない性能を示すと約束していました。しかし、初期テストの結果は、このAIが人間の科学者やプログラマーに取って代わるという目標には程遠いことを示しています。

ソーシャルメディアでは、多くのユーザーが「OpenAI o1」AIとのインタラクション体験を共有しており、その結果、このモデルは基本的なタスクでも依然として不十分なパフォーマンスを示していることが明らかになっています。

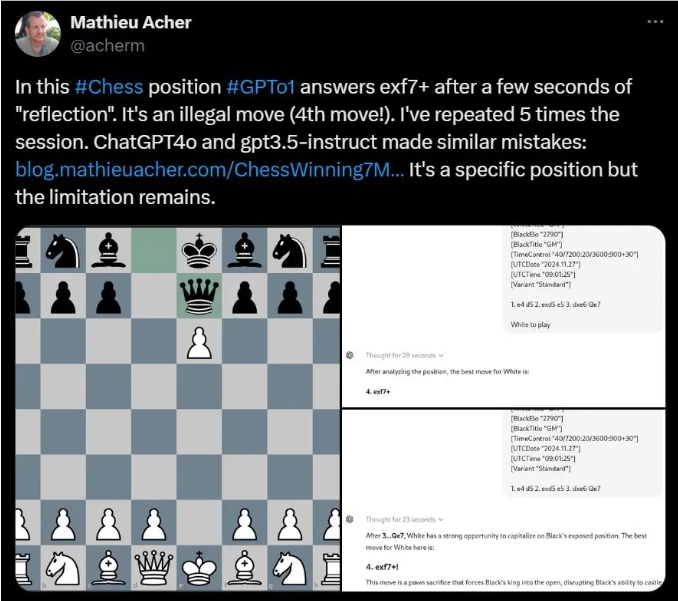

例えば、INSA Rennesの研究者Mathieu Acher氏は、OpenAI o1がチェスのパズルを解く際に、頻繁に不正な手を提案することを発見しました。

一方、Meta AIの科学者Colin Fraser氏は、羊を川を渡らせるという簡単な言葉のパズルにおいて、このAIが正しい答えを放棄し、論理の通らないでたらめな回答を提示したと指摘しています。

さらに、OpenAIがデモに使用した論理パズルにおいても、ストロベリーに関する質問に対してユーザーは異なる回答を得ており、あるユーザーはモデルの誤答率が75%に達したことを発見しました。

それだけでなく、一部のユーザーは、この新しいモデルが「strawberry」という単語の中に含まれる文字「R」の数を数えることさえ頻繁に間違えることを報告しています。

OpenAIは発表時に、これは初期段階のモデルであり、ウェブブラウジングやファイルアップロードなどの機能はまだ備わっていないと述べていましたが、このような基本的なミスは驚きです。

改善のため、OpenAIは新しいモデルに「思考連鎖」プロセスを導入し、OpenAI o1を以前のGPT-4oモデルから大きく差別化しました。この方法により、AIは答えを出す前に何度も推敲することができますが、そのため応答時間が長くなるというデメリットもあります。

あるユーザーは、このモデルが言葉のパズルの答えを出すのに92秒もかかったにもかかわらず、結果は依然として間違っていたことを発見しました。

OpenAIの研究科学者Noam Brown氏はこれについて、現在の応答速度は遅いものの、将来のバージョンではより長い時間をかけて思考し、画期的な問題に新たな知見を提供できると期待していると述べています。

しかし、著名なAI評論家Gary Marcus氏はこれに対して懐疑的な見方を示し、長時間処理すれば必ず超越的な推論能力が得られるとは限らないと主張しています。彼は、AI技術は発展を続けているものの、現実世界の研究と実験は依然として不可欠であると強調しています。

このように、OpenAIの新しいAIモデルは実際の使い方において様々な面で期待外れであり、AI技術の将来の発展に関する議論を引き起こしています。

要点:

🌟 最近、OpenAIは新しいAIモデル「ストロベリー」を発表し、複雑なタスクで博士課程の学生に匹敵する性能を謳っています。

🤖 多くのユーザーは、このAIが不正な手を提案したり、簡単なパズルを間違えたりするなど、基本的なタスクで頻繁にミスをすることを発見しました。

💬 OpenAIは、このモデルはまだ開発中であることを認めていますが、長時間思考すれば推論能力が向上するとは限らず、多くの基本的な問題が未解決のままです。