近年、視覚と言語のタスクにおける機械学習モデルの需要が高まっていますが、多くのモデルは膨大な計算資源を必要とし、個人デバイスでの効率的な実行が困難です。特にノートパソコン、コンシューマー向けGPU、モバイルデバイスなどの小型デバイスでは、視覚言語タスクの処理に大きな課題があります。

例えばQwen2-VLは優れた性能を持つ一方で、ハードウェア要件が高く、リアルタイムアプリケーションでの利用可能性を制限しています。そのため、少ないリソースでも動作する軽量化モデルの開発が重要な課題となっています。

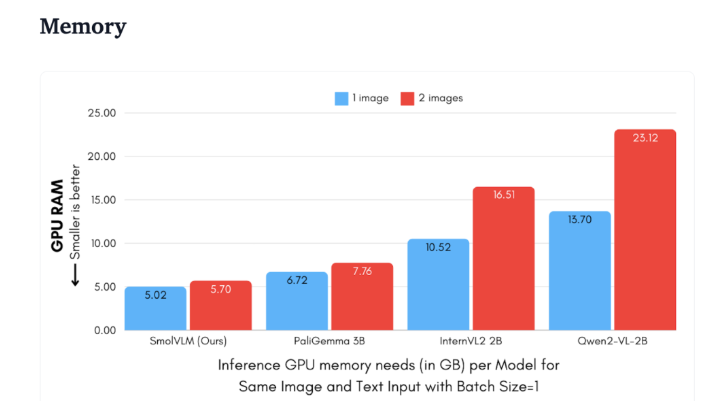

Hugging Faceは最近、デバイス上での推論用に設計された2Bパラメータの視覚言語モデル、SmolVLMを発表しました。SmolVLMは、GPUメモリ使用量とトークン生成速度において、他の同等のモデルを凌駕しています。主な特徴は、ノートパソコンやコンシューマー向けGPUなど、比較的低スペックなデバイスでも効率的に動作することです。性能と効率のバランスが理想的に取れており、従来のモデルが抱えていた問題を解決しています。

Qwen2-VL2Bと比較して、SmolVLMのトークン生成速度は7.5~16倍高速です。これは最適化されたアーキテクチャのおかげで、軽量な推論が可能になったためです。この効率性により、エンドユーザーにとって実用的なメリットだけでなく、使い勝手も大幅に向上しています。

技術的な観点から見ると、SmolVLMは最適化されたアーキテクチャを持ち、効率的なデバイス上での推論をサポートしています。Google Colabで簡単にファインチューニングできるため、実験や開発のハードルが大幅に低くなっています。

メモリ消費量が少いため、従来は同等のモデルを実行できなかったデバイスでもSmolVLMはスムーズに動作します。50フレームのYouTube動画をテストした結果、SmolVLMは27.14%という高いスコアを達成し、リソース消費量でもよりリソースを消費する2つのモデルを上回りました。これは、その高い適応性と柔軟性を示しています。

SmolVLMは、視覚言語モデル分野における重要なマイルストーンです。これにより、複雑な視覚言語タスクを日常的なデバイスで実行できるようになり、現在のAIツールの重要な空白を埋めるものです。

SmolVLMは速度と効率において優れた性能を発揮するだけでなく、開発者や研究者にとって、高価なハードウェアに投資することなく視覚言語処理を行うための強力なツールとなります。AI技術の普及に伴い、SmolVLMのようなモデルによって、強力な機械学習能力がより身近なものになるでしょう。

demo:https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

要点:

🌟 SmolVLMは、Hugging Faceが発表した、デバイス上での推論用に設計された2Bパラメータの視覚言語モデルで、効率的に動作し、高性能なハードウェアは必要ありません。

⚡ トークン生成速度は同等のモデルの7.5~16倍で、ユーザーエクスペリエンスとアプリケーション効率を大幅に向上させます。

📊 テストでは、SmolVLMは高い適応性を示し、動画データによるトレーニングなしでも良好なスコアを達成しました。