3月11日、通義实验室チームは、全モダリティモデルの開発に新たなブレークスルーをもたらすR1-Omniモデルのオープンソース化を発表しました。このモデルは強化学習と検証可能な報酬(RLVR)手法を組み合わせ、多モダリティ感情認識タスクにおける推論能力と汎化性能の向上に重点を置いています。

R1-Omniのトレーニングは2つの段階に分かれています。コールドスタート段階では、Explainable Multimodal Emotion Reasoning(EMER)データセットとHumanOmniデータセットからなる、580本のビデオデータを含む複合データセットを使用して微調整を行います。この段階の目的は、モデルに基本的な推論能力を構築し、RLVR段階に入る前に一定の多モダリティ感情認識能力を持たせることで、その後のトレーニングの円滑性、効率性、安定性を確保することです。

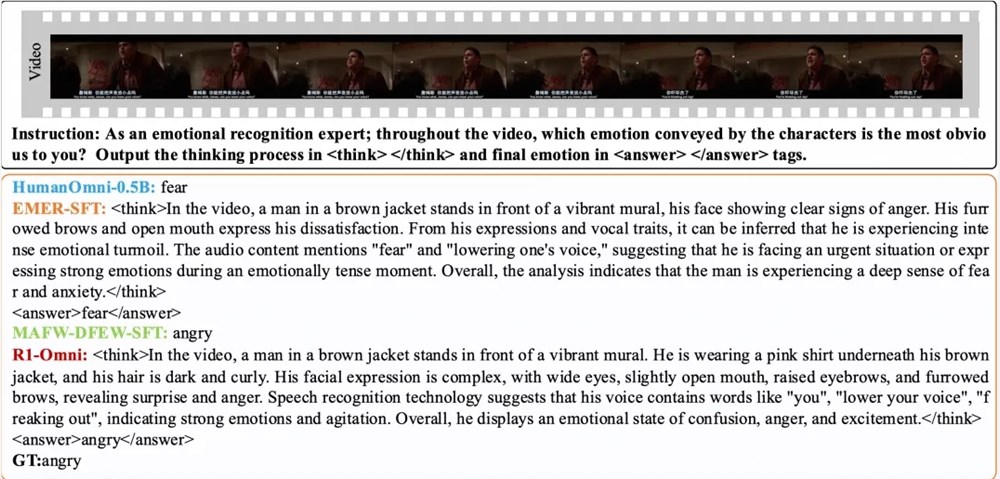

その後、RLVR段階では、強化学習と検証可能な報酬メカニズムによってモデルをさらに最適化します。この段階の鍵となるのは、ポリシーモデルと報酬関数です。ポリシーモデルは、ビデオフレームとオーディオストリームで構成される多モダリティ入力データを取り扱い、詳細な推論プロセスを含む候補応答を生成し、モデルが視覚情報と聴覚情報をどのように統合して予測を導き出すかを示します。報酬関数はDeepSeek R1に着想を得ており、精度報酬とフォーマット報酬の2つの部分で構成され、これらが最終的な報酬を形成します。これにより、モデルは正しい予測を生成するよう促されると同時に、出力が構造化され、予め設定されたフォーマットに準拠することも保証されます。

実験結果によると、R1-Omniは、同分布テストセットDFEWとMAFWにおいて、元のベースラインモデルと比較して平均35%以上、教師あり微調整(SFT)モデルと比較して未加重平均再現率(UAR)で10%以上の向上を示しました。異なる分布のテストセットRAVDESSでは、加重平均再現率(WAR)とUARの両方が13%以上向上し、優れた汎化能力を示しました。さらに、R1-Omniは顕著な透明性という利点も持ち合わせています。RLVR手法により、モデルにおけるオーディオとビデオ情報の役割がより明確になり、特定の感情判断に対する各モダリティ情報の重要な役割を明確に示すことができます。これは、モデルの意思決定プロセスを理解し、将来の研究のための重要な参考資料となります。

論文:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/HumanMLLM/R1-Omni

モデル:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B