12年生が、Minecraftでの様々なAIモデルの性能を評価できる革新的なプラットフォームを構築し、人工知能評価分野に新たな視点をもたらしました。

従来の評価方法の限界に対処する新たなベンチマーク手法

従来の人工知能ベンチマーク手法の限界がますます明らかになる中、開発者たちはより創造的な評価方法を探求し始めています。ある開発者グループにとって、マイクロソフトのサンドボックス型建築ゲームMinecraftは理想的な選択肢となりました。

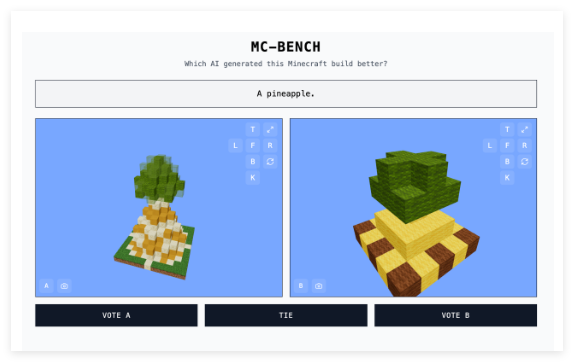

高校生であるAdi Singh氏と彼のチームが開発したMinecraft Benchmark(略称MC-Bench)ウェブサイトでは、AIモデルが直接対決形式で競い合い、様々なプロンプトに対してMinecraft作品で応答します。ユーザーは、どちらのモデルの性能が優れているか投票できます。投票後、各作品の裏側にあるAI開発者を確認できます。

Singh氏は、Minecraftをテストプラットフォームとして選択した理由として、その高い知名度を挙げています。史上最も売れたビデオゲームの一つであるため、プレイしたことがない人でも、どちらのブロック状パイナップルが優れているかを直感的に判断できます。

「Minecraftは、人々がAI開発の進歩をより容易に理解できるようにします」とSingh氏はTechCrunchに語っています。「人々はMinecraftに慣れ親しんでおり、その見た目や雰囲気に馴染んでいます。」

主要なAI企業からの支援

MC-Benchには現在、8人のボランティアが参加しています。ウェブサイトの情報によると、Anthropic、Google、OpenAI、アリババが本プロジェクトに資金を提供し、それぞれの製品をベンチマークテストに使用することを許可していますが、それ以外の関係はありません。

Singh氏は、プロジェクトの将来展望について次のように述べています。「現時点では、単純な構築を行い、GPT-3時代と比べてどれだけ進歩したかを振り返っていますが、長期的な計画や目標指向のタスクへと拡大していく予定です。ゲームはエージェントの推論をテストするための媒体に過ぎず、現実世界よりも安全で、テストにおいてより制御しやすいため、私にとっては理想的です。」

Minecraft以外にも、『ポケットモンスター赤・緑』、『ストリートファイター』、『ピクショナリ』などのゲームがAI実験のベンチマークとして使用されています。これは、AIベンチマークテスト自体が非常に困難であるためです。

複雑な指標に代わる直感的な評価

研究者たちは通常、標準化された評価でAIモデルをテストしますが、これらのテストはAIに有利に働くことが多いです。訓練方法の特徴により、モデルは特定の種類の問題、特に記憶や基本的な推論を伴うタスクに得意です。

この矛盾は多くの事例に見られます。OpenAIのGPT-4はLSAT試験で88%の成績を収める一方、「strawberry」という単語に含まれる「R」の数を正確に数えることができません。AnthropicのClaude 3.7 Sonnetは標準化されたソフトウェアエンジニアリングベンチマークテストで62.3%の精度を達成する一方、ポケモンゲームでは5歳児の多くに劣ります。

技術的な観点から見ると、MC-Benchはプログラミングベンチマークであり、モデルは「雪だるまフロスティ」や「原始的なビーチにある魅力的なトロピカルビーチハウス」など、指定された建造物を作成するためのコードを作成する必要があります。しかし、ほとんどのユーザーにとって、コードを詳細に分析するよりも、雪だるまの外観を評価する方が直感的です。そのため、本プロジェクトはより幅広い人々の関心を集め、モデルの性能に関するより多くのデータ収集が期待できます。

これらのスコアがAIの実用性にどのような影響を与えるかはまだ議論の余地がありますが、Singh氏は、これが強力なシグナルであると確信しています。「現在のランキングは、私がこれらのモデルを使用する経験と非常に近いです。これは、多くの純粋なテキストベースのベンチマークテストとは異なります。MC-Benchは、企業が正しい方向に進んでいるかどうかを理解するのに役立つかもしれません。」